目录

一、引言

二、Kafka 的演进:AutoMQ 存算分离的创新与实现

Apache Kafka 在大规模数据下的挑战

为什么选择 AutoMQ

AutoMQ 落地效果:千核资源替换,成本下降 50%

三、ClickHouse 的进化:存算分离架构的实践与应用

背景

ClickHouse 企业版介绍

落地实践与优化

四、总结

五、引用

一、引言

得物作为全球领先的潮流网购社区,日益增长的用户和数据带来了巨大的技术挑战。当前,得物的可观测性平台每天生成数 PB 级 Trace 数据和数万亿条 Span 记录,要求平台具备高效的实时处理能力和低成本的数据存储解决方案。

传统的存算一体架构将计算与存储资源绑定,随着数据规模的扩大,暴露出了以下问题:

扩展性受限:存算资源无法独立扩展,导致计算和存储的扩容必须同步,进而提升了成本。

资源利用率低:计算与存储资源无法按需动态调整,造成闲置资源浪费。

运维复杂性高:集群扩展和缩容涉及复杂的资源迁移,增加了运维难度。

为了有效解决这些问题,得物可观测性平台采用了存算分离架构,结合 AutoMQ 和 Kafka 以及 ClickHouse 存储技术,实现了高效的资源管理和性能优化。

二、Kafka 的演进:AutoMQ 存算分离的创新与实现

Apache Kafka 在大规模数据下的挑战

Apache Kafka 处于得物观测业务的核心数据链路中

在得物的可观测性平台中,Apache Kafka 被广泛用于数据收集、加工和分发。然而,随着业务数据量的不断增长,Kafka 的架构暴露出以下问题:

存储成本高:Kafka 的存储部分占据了大部分(计算与存储成本比例为 1:3)云资源开销,为了控制成本,得物调整了 Kafka 的数据 TTL 和副本配置,但存储成本仍居高不下。

冷读效率低:冷读场景下,磁盘吞吐量常达到上限,导致性能瓶颈。

得物 Kafka 磁盘高危报警

运维复杂性高:随着集群规模的扩大,Kafka 集群的扩缩容操作变得更加复杂,面临较高的运维风险。

这些问题源于 Kafka 原生架构的局限性,特别是其面向 IDC 环境的 Shared-Nothing 架构,难以充分发挥云计算时代对弹性和扩展性的要求。

为什么选择 AutoMQ

AutoMQ 云原生架构

为了解决 Kafka 在大规模数据处理中的问题,得物可观测性平台选择了 AutoMQ 作为替代方案。AutoMQ 的优势包括:

100%兼容 Kafka 协议:AutoMQ 完全兼容 Kafka 客户端和生态工具,迁移过程顺畅,避免了大规模改造。

存算分离架构:存储与计算解耦,AutoMQ 基于对象存储和 EBS 存储研发了共享流存储库 S3Stream[1],并通过 S3Stream 替换了 Apache Kafka 的整个存储层,大幅降低存储成本,同时支持存储与计算的独立扩展。

弹性扩缩容能力:支持动态资源调整,无需数据迁移或停机,提升资源利用率。

未来扩展性:支持大规模数据量增长,能够与现代存储和计算工具无缝集成,满足长期需求。

AutoMQ 面向冷读场景的性能优化

在冷读场景下,Apache Kafka 的性能问题十分明显。KAFKA-7504[2]问题导致冷读操作影响实时写入,严重时会降低整个集群的吞吐量。AutoMQ 通过以下方式优化了这一问题:

对象存储与计算分离:存储与计算的彻底分离避免了冷读对写入性能的影响。

高效查询性能:AutoMQ 对查询操作进行了优化,即使在高并发场景下,冷读性能保持稳定。

Apache Kafka 的读写 IO 链路

Apache Kafka 的读写链路引入了两个关键的技术:Page Cache[3]和零拷贝 SendFile[4]系统调用。

Page Cache 极大地简化了 Kafka 内存管理的负担,完全由内核来负责。但存在冷热无法分离的问题,如果有业务持续在冷读,会跟热数据互相争抢内存资源,导致追尾读能力持续下降。

SendFile 是 Kafka 零拷贝的关键技术,但该调用行为发生在 Kafka 的网络线程池,如果执行 SendFile 时需要从磁盘上拷贝数据(冷读场景),会在一定程度上阻塞该线程池。又因为该线程池是处理 Kafka 请求的入口,包括写请求,SendFile 的阻塞行为将导致 Kafka 的写入受到巨大的影响。

在相同负载和机型下相比 Kafka,AutoMQ 冷读时可以保证不影响写入吞吐和延迟的情况下,拥有和 Kafka 相同水准的冷读性能[5]。

在冷读场景下,AutoMQ 显著提升了性能,与 Kafka 相比,冷读效率提升了约 5 倍,且对实时写入没有任何影响。

AutoMQ 基于共享存储架构的快速弹性能力

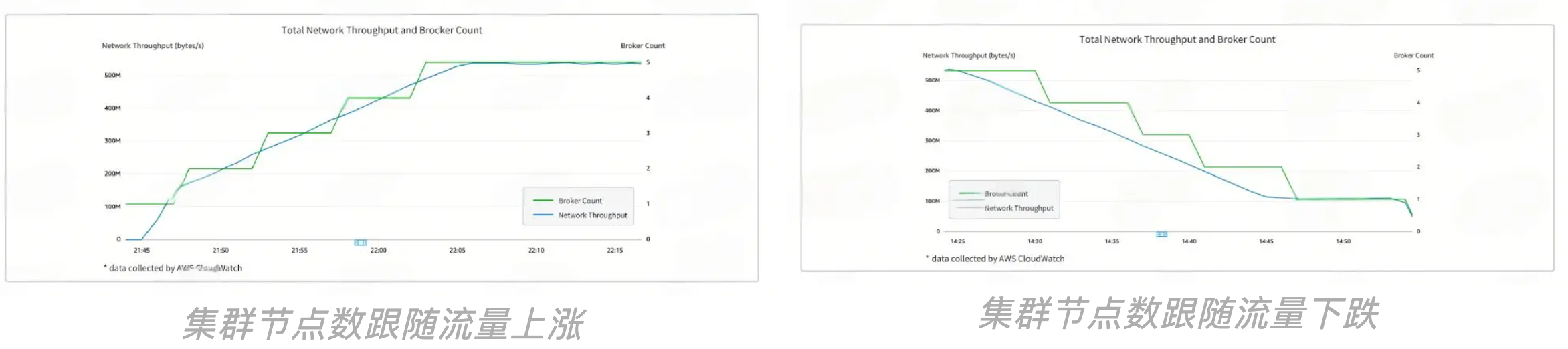

得物可观测性平台的业务流量呈现明显的峰谷波动,AutoMQ 通过存算分离架构实现了卓越的弹性扩缩容能力:

快速扩容:在业务高峰期,能够迅速扩展存储或计算资源,保障系统性能。

智能缩容:高峰过后,快速回收闲置资源,避免浪费并降低运维负担。

AutoMQ 的扩缩容依赖秒级分区迁移技术[6]。在扩容时,借助弹性伸缩组(ASG)[7]或 Kubernetes HPA,分区可以批量迁移到新节点,确保流量快速平衡,通常在十秒内完成。缩容时,待下线节点的分区会迅速迁移至其他节点,完成秒级下线。与 Apache Kafka 需要通过复制数据进行扩缩容不同,AutoMQ 利用共享存储架构避免了数据复制,显著提高了扩缩容效率,避免了数据重平衡[9],跟 Apache Kafka 的实现有巨大的区别。

AutoMQ 自动流量重平衡 vs. Apache Kafka 手动迁移

案例

AutoMQ 通过监控集群流量和 CPU 等指标,自动进行扩缩容。当流量达到扩容阈值时,系统会自动增加 Broker 节点;当流量下降至缩容阈值时,系统会优雅地将即将下线的 Broker 上的分区以 Round-Robin 方式秒级迁移至其他 Broker,完成流量平衡。

AutoMQ 落地效果:千核资源替换,成本下降 50%

AutoMQ 在得物可观测性平台上线半年以来,逐步替换了整个可观测性架构对 Apache Kafka 的依赖,基于 AutoMQ 的整体可观测架构如下图所示,AutoMQ 集群承担了所有微服务业务的产生的观测数据,并基于 ClickHouse 进一步提供点查和观测数据分析的能力。

得物基于 AutoMQ 的可观测架构

AutoMQ 也为得物可观测性平台带来了以下显著的成效:

云账单成本同比下降 50%以上,同时运维效率大幅度提升。

完成近千核计算资源替换,总体吞吐高达数十 GiB/s。

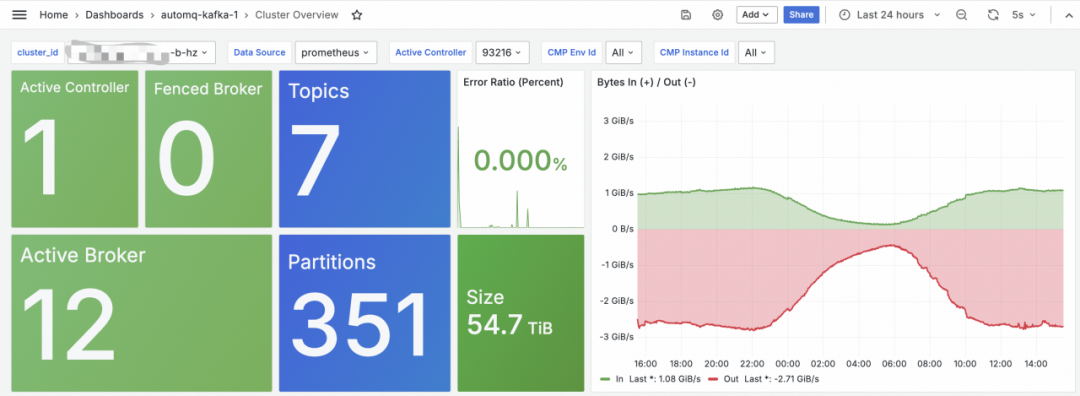

AutoMQ 落地效果:平稳支撑得物双十一期间 100%流量

除了成本大幅度降低之外,今年通过 AutoMQ 的架构支撑得物双十一,避免了过往双十一前繁重的容量评估工作,以及提前扩容的运维成本。AutoMQ 集群上线以来,以及双十一期间全程保持高可用,零宕机,支撑了双十一期间 100%的流量,且高峰期负载平稳,无性能抖动。如下图是得物可观测性平台 AutoMQ 集群中其中一个 GiB 级吞吐的集群。

得物其中的一个 AutoMQ GiB 级集群

三、ClickHouse 的进化:存算分离架构的实践与应用

背景

得物可观测性平台在分布式链路追踪中,采用 ClickHouse 作为 Trace 索引数据的存储引擎,每天管理着数十万亿行追踪数据。随着数据量的持续增长,平台不仅需要保障实时查询的高效性能,还面临着存储成本优化和集群维护复杂度提升的双重挑战。

面临的挑战

ClickHouse 凭借卓越的性能,在面对大规模数据时依然能够提供极快的查询响应,为可观测性平台的实时分析和监控提供了坚实保障。然而,随着业务扩展和数据量激增,原有的基于云盘自建的开源分布式架构逐渐暴露出了一些问题:

成本高:得物的 Trace 平台从 2022 年至今,数据量从日增百 TB 级增长到数 PB,膨胀了 30 倍。数据冷热存储的成本压力增加。

可扩展性差:作为一个电商平台,每年的双 11 和 618 等购物节,Trace 平台都会迎来数倍的流量上涨,为了保证业务的稳定运行,每逢业务高峰都要进行集群的扩容,分布式架构下集群扩容麻烦、需要停写影响业务,再加上集群扩容中的协调难题都为平台的维护带来了额外的工作量和稳定性压力。

容灾能力较低:在实际应用中,考虑到海量数据产生的成本问题,得物并未采用多副本策略,而是通过单副本存储来优化资源利用率和降低存储开销,在更加追求系统稳定性和数据安全保障的今天,如何提高系统的容灾能力也成为了一个重要的课题。

集群写入负载平衡难:为了平衡集群节点的写入负载,每次扩容时需与上游服务协同进行 rebalance,以合理分配数据至新节点。这一过程虽确保了扩展后的集群性能,但对运维效率提出了更高的要求,涉及数据分布调整和写入负载平衡的精细化管理。

因此,如何在保持 ClickHouse 性能优势的同时,优化扩容过程中的运维流程,解决集群写入负载平衡问题,进一步提升系统的稳定性,是得物平台在持续扩展中亟需解决的核心问题。

ClickHouse 企业版介绍

ClickHouse 企业版是专为云环境下的存算分离架构设计,支持更高效的计算与存储资源管理。企业版与社区版的最大区别在于,它引入了更先进的存算分离架构和更多功能,能够在大规模数据处理、实时查询和存储管理方面提供更优的性能。

存算分离架构是 ClickHouse 企业版的核心创新,它通过将计算资源和存储资源分开,极大地提高了系统的弹性和扩展性。在这种架构下,计算节点和存储节点独立扩展,存储资源可以通过共享存储(如 OSS、S3 等)进行集中管理,而计算节点则能够根据负载情况进行自动伸缩,从而更好地应对流量高峰期的挑战。

企业版还引入了 Serverless 计算模型,允许平台根据实际负载自动调整计算资源的大小。相比于传统的基于固定资源分配的计算模式,Serverless 架构能帮助平台实现弹性伸缩,只在需要时自动分配计算资源,极大地节省了资源开销,同时也能更好的应对业务流量的非预期增长,提高了系统的稳定性。

SharedMergeTree 表引擎

在 ClickHouse 企业版中,SharedMergeTree 表引擎是实现存算分离架构的关键组件。SharedMergeTree 优化了对共享存储(如 Amazon S3、Google Cloud Storage、MinIO、阿里云 OSS 等)的支持,100%兼容社区版的 MergeTree 引擎的同时,内核还可以自动将社区版的建表语句转化为企业版专属引擎的建表语句(如下图所示),业务迁移无需 DDL 改造。

与传统的 ClickHouse 集群架构相比,SharedMergeTree 引擎通过以下方式提升了数据存储和查询性能:

共享存储支持:所有数据都存储在共享存储中,而计算节点通过访问共享存储来执行查询和分析。这种设计使得数据的存储和计算完全分离,计算节点无需持有数据副本,从而降低了存储和计算资源的冗余。

无状态计算节点:计算节点不再存储数据副本,而是通过访问共享存储中的数据进行计算。这使得每个计算节点都是“无状态”的,具有更好的扩展性和容错能力。在面对流量高峰时,新的计算节点可以快速加入并开始工作,而不需要重新分配或迁移数据。

简化集群管理:用户无需管理传统的 Shard 或 Distributed Table,SharedMergeTree 引擎只需创建一张表即可,简化了集群管理流程,降低了维护复杂度。

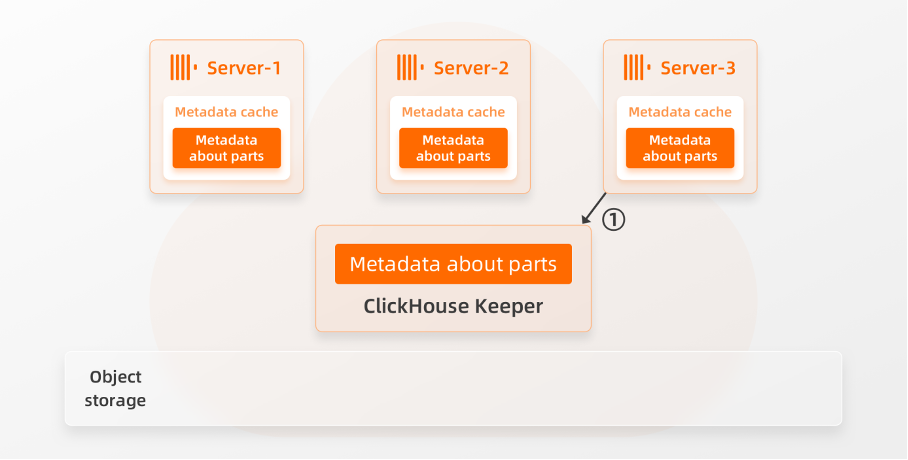

水平扩展

在大规模电商平台的场景下,面对节假日等流量高峰时,系统需要具备快速扩展和高可用性的能力。ClickHouse 企业版通过 SharedMergeTree 引擎,实现了分钟级水平扩展,并且在扩展过程中集群可正常执行读写任务,稳定性不受影响。

扩容流程:

新节点(Server-3)加入:当需要增加计算节点时,新节点首先注册至集群的元数据管理服务(如 Keeper),并开始监听数据元数据变化。

元数据同步:新节点从 Keeper 同步当前有效的元数据,无需锁定集群,不会影响集群其他节点的操作。

立即参与工作:新节点完成元数据同步后,立即可以处理查询请求,并按需访问共享存储中的数据。

通过这种方式,ClickHouse 企业版能够在高负载下实现弹性扩展,确保集群的稳定性和业务的连续性。

落地实践与优化

最终,得物可观测性平台基于 ClickHouse 企业版的功能,在写入、查询、容灾能力及弹性能力方面进行了全面优化,实现了高性能和高效率的分布式链路追踪系统。

从自建 ClickHouse 社区版升级为企业版,因为企业版的存算分离架构不再有分片的概念,不再需要通过直连本地表进行写入的方式对不同分片间的数据和写入流量进行均衡,所以和原先直连节点做写入的方式不同,切换为企业版后业务写入操作的对象变为了集群本身,写入逻辑得到了简化,原有的写入流量和分片间数据不均衡带来的运维和管理的问题也从架构上得到了解决。

写入优化

以下是具体的实践总结:

负载均衡:借助负载均衡(LB),将写入请求均匀分配到多个计算节点,避免单节点过载,提高系统稳定性。lb 采用 rr 模式,当集群版本升级进行节点的分批重启、以及集群中某一节点进行故障重建时,会自动调整为 wrr 模式来保障集群的整体无感。

性能提升:利用 ClickHouse 企业版的 Serverless 架构,成功支持了分布式链路追踪场景下集群每秒高达 2000 万行的写入操作,单次请求 40 万行数据写入耗时优化至 1s 左右。

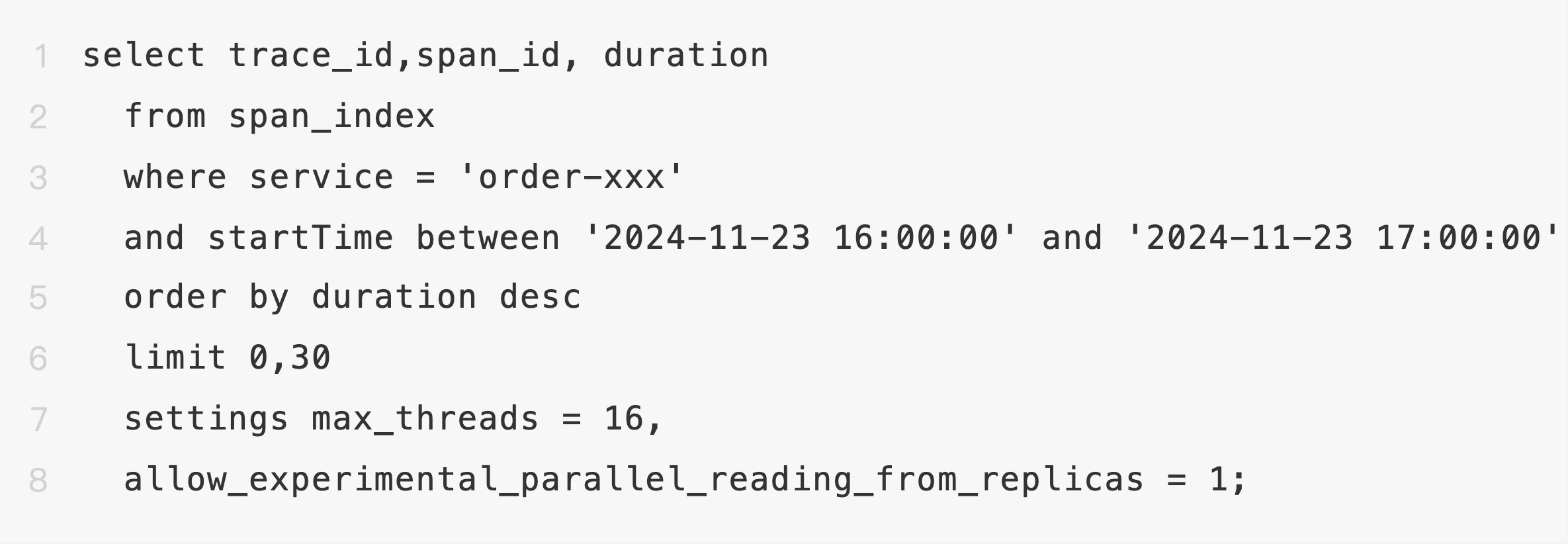

查询优化

并行查询:通过 Parallel Replica 特性,将查询分发至多个节点并行处理,显著提高效率。在特定场景下,查询速度提升可达 2.5 倍。整体查询效率与自建 ClickHouse 不相上下。

索引优化:调整 ORDER BY 字段与查询顺序,最大化利用索引过滤及数据块优化,显著减少不必要的数据扫描,从而提升查询响应速度。

容灾能力

单节点故障容忍:集群默认 3Keeper+至少双节点架构,每个计算节点都保存着一份完整的元数据,且计算节点仅管理元数据,核心业务数据存储于共享存储中。因此,单节点故障不会影响数据访问,其余节点可继续提供服务,确保业务稳定性。

高可用存储:通过采用如 OSS 等分布式对象存储,平台实现了高冗余的数据存储,进一步增强了系统在硬件故障情况下的恢复能力。

弹性能力

秒级弹性扩容:平台能够根据业务负载的实时变化,自动调整计算资源。通过监控 CPU 和内存使用,系统动态决策并热修改 Pod 配置,使扩容资源即时生效,无需重启服务。

按需付费:

计算按需付费:每个节点的弹升和弹降都是独立进行,只和当前节点的实际业务负载有关的,因此无需再担心各节点间流量压力差异带来的成本冗余;同时节点的弹性扩容和缩容的最小单位均为 1CCU(约 1C4G),扩容事件同步至计费模块后,平台按秒计费,仅需为实际资源使用量付费。这一机制帮助得物大幅降低了资源浪费,同时确保了成本优化。

存储按实际使用量付费:相比存算一体架构下需要预留至少 20%的存储空间来保障集群的稳定性的资源预购模式,ClickHouse 企业版的共享存储解决了自建社区版各分片数据不均衡、运维麻烦、成本冗余多的问题,同时仅按照实际使用量计费的模式结合对象存储本身价格低廉的特征,降低了得物大数据量场景下的存储成本 70%+。

四、总结

通过 ClickHouse 企业版,得物可观测性平台实现了从写入到查询、从容灾到弹性的全面优化。企业版的存算分离架构提升了系统可靠性,而秒级弹性能力结合秒级按需付费显著降低了计算资源的使用成本约 20%和存储资源的采购成本 70%+(总成本下降 60%)。这种实践模式不仅满足了高并发、高性能的业务需求,同时也为系统的扩展性和运维效率提供了有力支持,成功应对了链路追踪数据管理中的各种挑战。

五、引用

[1]AutoMQ 基于 S3 的共享流存储库:https://docs.automq.com/zh/automq/architecture/s3stream-shared-streaming-storage/overview

[2]Kafka 冷读性能问题来源:https://issues.apache.org/jira/browse/KAFKA-7504

[3]Linux Page Cache: https://en.wikipedia.org/wiki/Page_cache

[4]Linux SendFile: https://man7.org/linux/man-pages/man2/sendfile.2.html

[5]AutoMQ 性能白皮书:https://docs.automq.com/zh/automq/benchmarks/benchmark-automq-vs-apache-kafka

[6]AutoMQ 秒级分区迁移:https://docs.automq.com/zh/automq/architecture/technical-advantage/partition-reassignment-in-seconds

[7]AWS Auto Scaling Groups: https://docs.aws.amazon.com/autoscaling/ec2/userguide/auto-scaling-groups.html

[8]Kubernetes 用于扩容的 HPA 组件:https://kubernetes.io/docs/tasks/run-application/horizontal-pod-autoscale/

[9]AutoMQ 持续数据自平衡:https://docs.automq.com/zh/automq/architecture/technical-advantage/continuous-self-balancing

[10]阿里云云数据库 ClickHouse:https://help.aliyun.com/zh/clickhouse/?spm=a2c4g.11174283.0.0.61f5735a0zfJIS

注册 ClickHouse 中国社区大使,领取认证考试券

征稿启示

面向社区长期正文,文章内容包括但不限于关于 ClickHouse 的技术研究、项目实践和创新做法等。建议行文风格干货输出 &图文并茂。质量合格的文章将会发布在本公众号,优秀者也有机会推荐到 ClickHouse 官网。请将文章稿件的 WORD 版本发邮件至:Tracy.Wang@clickhouse.com。