“Transformer 架构可能正把整个行业困在一个局部的瓶颈中,阻碍我们找到真正的智能推理方法”这是该架构的共同发明者之一 Llion Jones 的观点。

尽管 Llion 是著名论文《Attention Is All You Need》的原始作者之一,但他在很大程度上已经停止了对 Transformer 的研究。他认为,由于 Transformer 本身表现出色,所有人都专注于对同一架构进行小幅改进,而非去探索下一个重大突破。

Llion 出生于英国威尔士,从小就对计算机充满兴趣,他在 14 岁时学会编程,其中尝试的第一批项目之一就是编写聊天机器人,而如今他正从事聊天机器人技术的前沿工作。

2011 年,Llion 获得 Google 软件工程师职位,开始在 YouTube 工作。他最初申请的是伦敦办公室的职位,但在通过电话面试后,他才发现自己申请的工作实际上是在加利福尼亚。为了得到这次工作机会,Llion 同意搬到旧金山,并在那里生活了 7 年,之后搬到了东京。

期间,在 YouTube 工作几年后,Llion 希望再次追求人工智能的兴趣。2015 年,他调入 Google Research 从事自然语言处理研究。正值“深度学习”革命时期,这是一个非常不错的契机。工作一年后,他参与了《Attention is All You Need》的研究。

在 Transformers 的研究工作之后,Llion 在著名未来学家 Ray Kurzweil 手下继续推动 Transformers 和语言建模技术的发展。工作 12 年后,他在 2023 年离开 Google 并创立了自己的公司 Sakana AI。

Sakana AI 最近刚获 200 亿日元(1.35 亿美元)的 B 轮融资,投资方包括三菱 UFJ 金融集团(MUFG)等。融资完成后,企业估值约为 4000 亿日元(26.35 亿美元)。

Sakana AI 表示,尽管全球 AI 模型的研发竞争日益激烈,“但其巨额成本所对应的经济回报与在社会中的应用路径仍不够明确”。同时指出,“相较于美中两国,日本作为后来者,在计算资源投入规模上直接竞争并不现实”。因此,公司将致力于开发不依赖庞大算力的高效 AI 技术,以及推动 AI 在社会中的实际应用。

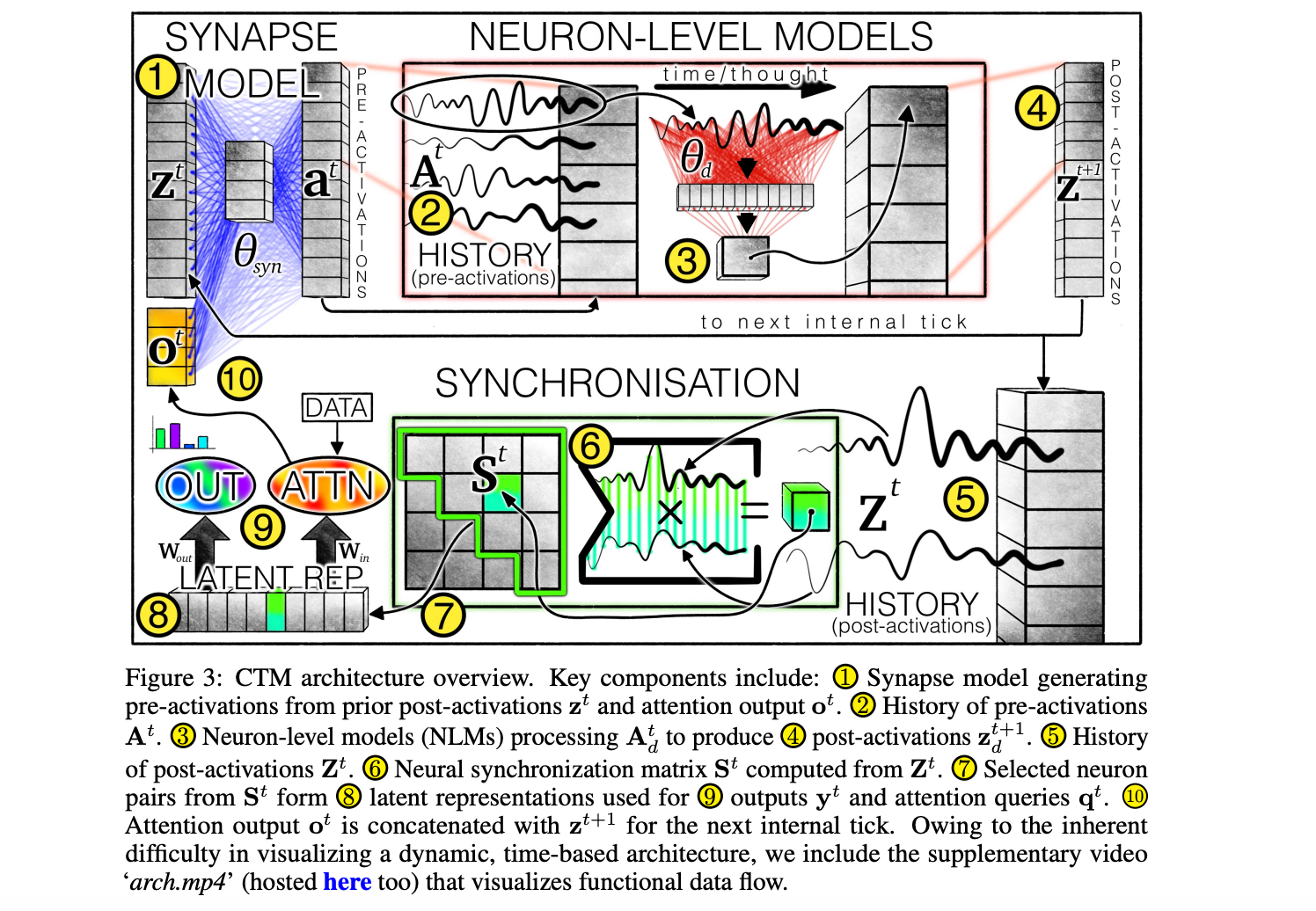

他们最新的成果就是在 NeurIPS 2025 上发布了《Continuous Thought Machine(连续思考机器)》。业内之所以关注,是因为它具有原生的自适应计算能力。这是一种构建递归模型的新方法,它为神经元引入了更高层次的概念,并使用“同步”作为表征手段,让我们能够以更像人类的方式解决问题。

近期,Llion 和 Sakana AI 研究实验室科学家 Luke Darlow 在“Machine Learning Street Talk”节目中讨论了当前的研究现状。节目中,Llion 直言“规模化效果太好也是一种不幸”。Luke 则详细解释了为什么他们认为新推出的 CTM 架构会显著优于 Transformer。

我们翻译并整理了这次采访,在不改变原意基础上进行了删改,以飨读者。

从不再研究 Transformer 说起

Llion:虽然我当年参与发明了 Transformer,但幸运的是,可能除了另外七位共同作者外,没有人像我一样在这个领域深耕了这么久。所以我在今年早些时候做了一个决定:大幅减少我在 Transformer 上的研究投入。原因是我强烈感觉到这个领域已经过度饱和了。并不是说 Transformer 已经无事可做,而是我想趁这个机会去做一些完全不同的事情,让自己在研究方向上拥有更多的探索空间。

其实在 Transformer 刚出现那几年,AI 研究的氛围和现在完全不同。现在这种事情已经很难发生了,最大的原因是:我们拥有的研究自由度比过去少了很多。

Transformer 的诞生完全是“自下而上”的。并不是有人制定了一个宏大的计划,让大家按图索骥;而是一群人吃午饭时讨论:当前的问题是什么、我们能不能换一种办法解决,然后真的有自由花上几个月去验证想法,最终才碰撞出全新的架构。

如今我们已经在大模型上花了数亿美元,而最大的那类“基于进化的搜索”实验大概也就做到数万级别而已。我们现在拥有如此巨大的算力,如果真的把这些进化式搜索算法彻底放大,会发生什么?我敢肯定,一旦有人真正下定决心,把这些“演化—生命”类实验规模化,一定会发现非常有趣的东西。

但当时我提出这类方向时,整个环境都在一头扎进同一种技术路线里,没有人对我的建议感兴趣,完全没有。所以现在我创立了自己的公司,可以真正追求那些让我兴奋的技术方向。

主持人:很多人知道我是 Kenneth Stanley 的忠实粉丝,他的那本《为什么伟大不能被计划》彻底改变了我的人生。他想表达的是,我们要允许大家顺着自己的“兴趣梯度”去探索,别被各种 KPI 或者委员会给框住了,只有这样,我们才能真正去“觅食”新知识。如果掺杂了太多的目的性,最后只会搞出一堆毫无生气的平庸“浆糊”,根本没法发现那些有趣的新东西。这也正是你们 Sakana AI 这家公司的核心理念,对吧?

Llion:没错,正是这样。我们全公司都是那本书的铁粉,实际上我们还打算请作者来公司做分享。这确实是我们内部经常讨论的哲学问题。

作为联合创始人,我的核心任务之一就是捍卫研究员现有的自由。说实话,能拥有这种资源去折腾,本身就是一种特权。我见过太多例子了,随着公司规模扩大,压力接踵而至,自由空间就会被压缩。但正因为我们坚信这套哲学,因此我希望尽可能长久地让大家保持这种研究自由。

主持人:那你觉得,随着公司慢慢成熟,具体是哪些东西在一点点蚕食这种自由呢?你会怎么形容这个过程?

Llion:现在的 AI 行业,关注度、人才、资金都前所未有得多,这当然是好事。但遗憾的是,这也加剧了竞争压力。大家都想从技术里榨出价值、变现……

做初创公司,起步时你充满激情,而且还有资金助跑,所以你有资本去试错。但不可避免地,大家开始要投资回报、要有产出,你需要赶着出产品,这不可避免地扼杀了研究员的创造力。因为你要发论文,或者要搞出能直接落地的技术,这种压力一上来,那种“当家作主”的感觉就下去了。

但我真的是这么跟新入职的同事说的:“我就想让你做你觉得有趣、重要的事情”,我是认真的。

要替代 Transformer,必须是碾压式的好

主持人 :YouTube 上有个概念叫“受众俘获”(Audience Capture)。我觉得可能也存在一种“技术俘获”。你看 Google 早期也是非常开放探索的,而现在 Transformer 已经成了所有 AI 技术的基石,这是你的巨大成就。

但类似的故事也在 OpenAI 上演,他们现在满眼都是商业化机会,他们可能会变成下一个 LinkedIn,变成应用平台、搜索平台,甚至社交网络。我想这也可能发生在你们身上,特别是考虑到今天要聊的这篇新论文——“连续思维机器”(Continuous Thought Machines,简称 CTM)。这可能是一项革命性的技术,但一旦大家看清了它的商业潜力,那种变现的压力也会随之而来。

Llion:我很喜欢“受众俘获”这个类比。现在的确可以说,我们都被大语言模型(LLM)给“俘获”了。它们效果太好了,导致所有人都一窝蜂地去搞这个。我很担心我们现在是不是卡在一个“局部最优解”里出不来了,我们得想办法跳出去。

刚才聊到 Transformer,我其实特别喜欢回顾它诞生前的那段时期,因为太有代表性了。

在 Transformer 之前,主流技术是 RNN(循环神经网络)。当时也是这种感觉:当我们搞出 Seq2Seq 时,那是个巨大突破,翻译质量、语音识别质量都大幅提升。当时的气氛跟现在很像,大家都觉得:“行了,就是它了,我们只要把这技术打磨完美就行。”

那会儿我最痴迷的任务是字符级语言建模。每当有基于 RNN 的新论文出来,我就特兴奋,赶紧找来看,想知道他们是怎么做到的。结果你会发现,很多论文其实只是在同样的架构上做微调。比如 LSTM、GRU,或者用单位矩阵初始化以使用 ReLU 函数,或者稍微调整门控位置,或者上下层都加上门控。

我记得当时特别喜欢一个叫“分层 LSTM”的研究,模型可以自己决定是否计算某些层。如果你用维基百科的数据训练它,你会发现它的计算决策结构竟然跟句子结构吻合了。我当时爱死这些东西了!但是呢,这些改进带来的提升总是很微小,比如从 1.26 比特/字符降到 1.25,再到 1.24。这在当时就算成果,能发论文,大家也很兴奋。

但是后来 Transformer 出来了。我之后去的那个团队,第一次尝试把非常深、仅解码器(Decoder-only)的 Transformer 用在语言建模上,结果直接干到了 1.1 左右。

效果好到什么程度?同事特意跑到我工位旁,礼貌地问:“你是不是算错了?你用的单位是不是纳特而不是比特?” 我们说:“不不不,数是对的,就是这么强。”后来我也被震撼到了:之前那所有的研究——顺便说一句,那都是非常优秀的研究——突然之间就变得毫无意义了。

真的,之前大家在 RNN 上做的那些无休止的排列组合,瞬间就成了浪费时间。

我觉得我们现在就处在类似的境地。好多论文还是守着同一个架构,做着无数琐碎的微调,比如调整归一化层的位置或者采用略微不同的训练方法等。我们可能又在犯同样的错误,浪费同样的时间。

我不认为游戏已经结束了,我不相信这就是最终架构,只要无脑 scaling 就行。我相信迟早会有新的突破出现,到时候回头看,大家又会发现:“哎呀,我们要早点醒悟就好了,当时浪费了不少时间。”

主持人:没错,我们其实是被自己的成功给“套牢”了。这就是所谓的“吸引盆”(Basin of Attraction,物理学术语,此处比喻陷入某种局部最优的状态),而且这种坑还不少。Sara Hooker 之前提过“硬件彩票(hardware lottery)”,而这就像是一场“架构彩票”。现在我们就在这样一个阶段。大家都在讲基座模型,潜台词就是有了它你能做任何事。

以前在企业里,就算是中型公司,也有数据科学家、机器学习工程师去微调架构。但现在呢,只剩下 AI 工程师在搞提示词工程了。所以你的意思是,那些能让我们思维多元化、想出新架构的基础技能,正在消亡?

Llion:这点我可能不太认同。我觉得我们有的是才华横溢、充满创造力的研究员,但问题是,他们的才华没地儿施展。

举个例子,在学术界,发论文的压力太大了。你会想:“我有个绝妙的点子,但万一跑不通呢?或者这想法太怪了,审稿人很难接受,我得费大劲去推销这个概念。” 相比之下,去试个新的位置编码就安全多了。现在的环境,不管是学术界还是公司,其实都没给研究人员足够的自由去做他们真正想做的研究。

主持人:确实,而且还有个有意思的现象:即便有很棒的新研究出来,大厂也不一定用。我跟 Sepp Hochreiter(注:LSTM 之父)聊过,他有一堆新架构的想法,但 OpenAI 根本不采纳。不过谷歌倒是搞了个扩散语言模型,挺酷的。我想听听你的看法,这是为什么?

现在有些说法,比如通用表征方面,说 Transformer 的表征方式跟人脑很像。还有人觉得,只要规模上去、算力管够,那是“条条大路通罗马”,既然这样,何必费劲搞新架构呢?

Llion:其实已经有更好的了。研究早就证明有些架构比 Transformer 强,但问题是,强得还不够多。

你要想让整个行业放弃一套如此成熟的架构,光是“好一点”是没用的,必须是“碾压式的好”才行。毕竟,大家熟悉 Transformer,知道如何训练它、如何运作、内部原理是什么,也知道如何微调它,而且已经有了全套用于 Transformer 训练、微调和推理的软件。

Transformer 当年对比 RNN,就是这种碾压:将它应用到新问题上时,训练速度飞快,准确率飙升,你不得不转向它。深度学习革命也是一样,当时好多人怀疑,觉得符号主义(Symbolic AI)更好,结果深度学习的效果摆在那儿,好到你根本没法忽视。

这反而让寻找“下一代技术”变得更难了。这就像一种“地心引力”,总把你拉回到“Transformer 已经够用了”的舒适区。你可能搞出了个精巧的新架构,准确率看着不错,但 OpenAI 直接把模型做大十倍,效果立马把你秒了,那大家自然就觉得“接着奏乐接着舞”呗。

“规模化效果太好也是一种不幸”

主持人:我能不能再补充一个理由?我很喜欢的论文“Questioning Representational Optimism in Deep Learning: The Fractured Entangled Representation Hypothesis”里,有个“捷径学习”的问题,我觉得现在的繁荣多少有点海市蜃楼的味道,可能潜藏着我们还没意识到的隐患。而且,我们开始“滥用”架构了。明明知道需要自适应计算来做推理,需要不确定性量化,但我们所做的只是把这些功能 “嫁接” 到现有架构上,而不是设计一种天生就具备这些能力的架构。

Llion:没错,我们现在做的连续思维机器 CTM 就是想从根本上解决这些问题。现在的技术虽然厉害,但总感觉哪里不对劲。

现在有个流行词叫“锯齿状智能(Jagged Intelligence)”,就是说它上一秒能解决博士级的难题,下一秒就能一本正经地胡说八道,错得离谱,这种反差感太强了。我觉得这恰恰反映了当前架构在底层逻辑上可能有根本性的缺陷。

但也正是因为现在的技术“太好”了,好到让你离不开。你说到基座模型能做任何事,是的,现在的神经网络太强了。只要你有足够的耐心、算力和数据,你确实可以逼着它们学会做任何事。但我并不觉得它们“想”这么做,是我们硬逼着它们去拟合的。它们确实是“通用函数近似器”,但我认为存在某一类函数逼近器,更“愿意”以人类的方式去表征世界。

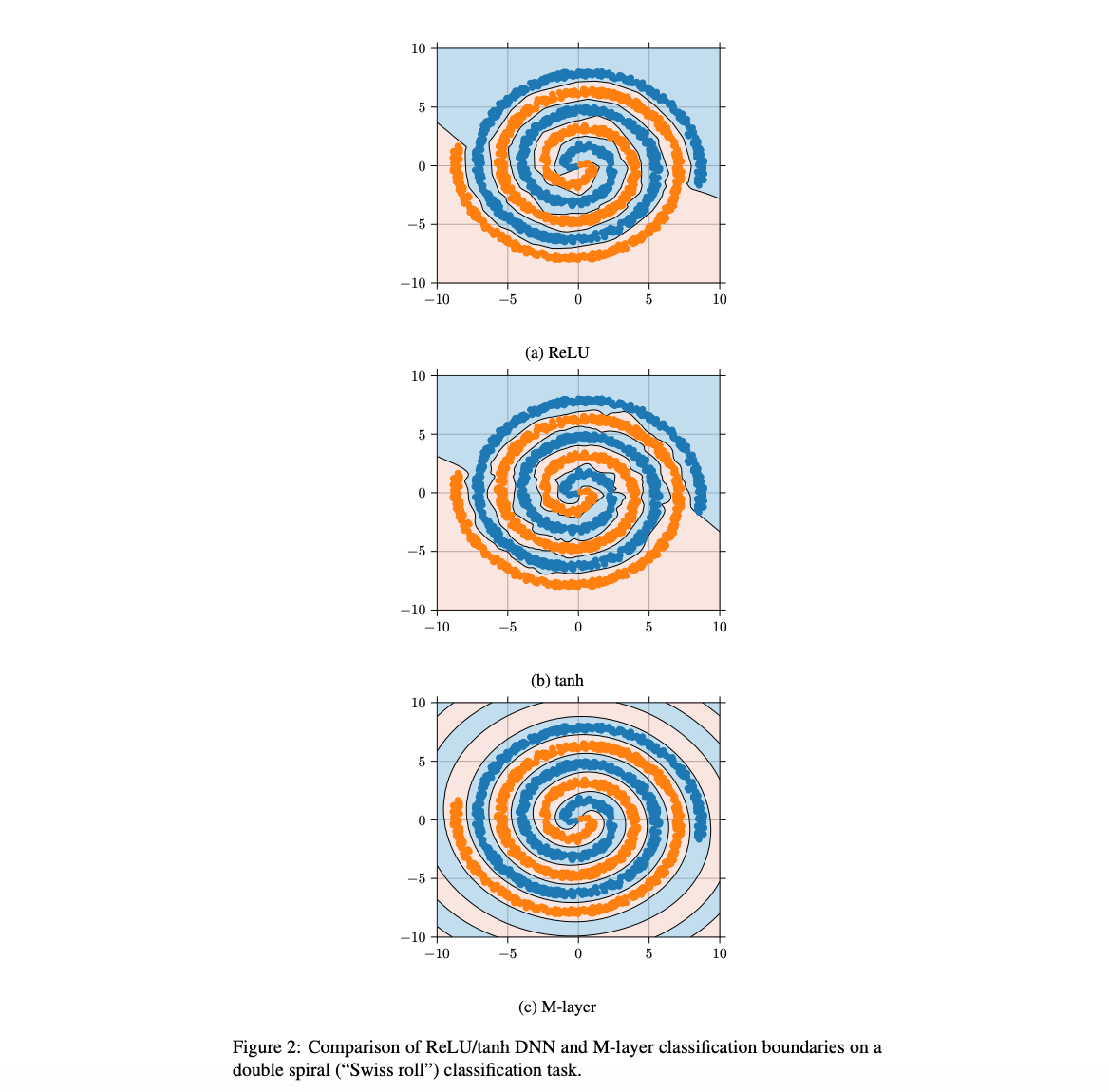

我有篇很喜欢的冷门论文,叫 Intelligent Matrix Exponentiation,好像还被拒稿了。论文中有一个经典的螺旋数据集实验,需要区分螺旋中的两个类别。论文展示了传统 RNN、多层感知机(MLP)和 tanh 激活的 MLP 的决策边界 —— 它们都解决了这个问题,技术上都能正确分类所有点,在这个简单数据集上取得了很高的测试分数。然后,论文展示了他们提出的新层的决策边界,那是一个完整的螺旋,也就是说,这个模型把螺旋数据表示成了真正的螺旋。如果数据本来就是螺旋,我们难道不应该按螺旋来表示它吗?再回头看传统 ReLU MLP 的决策边界,你会发现全是一些细碎的分段线性边界在硬拼、硬逼近。

这就是我想说的:是的,只要训练足够充分,不断调整这些分段线性边界,它确实能拟合螺旋并达到高准确率。但你看到这些图像时,完全不觉得 ReLU 版本的模型真正 “理解” 了这是一个螺旋。而当你用螺旋的方式来表征时,模型不仅能理解,还能正确外推,因为螺旋会一直向外延伸。

主持人:你刚才触及到了一个非常迷人的点,因为我们一直在强调适应性和自适应计算的必要性。我很推崇 Randall Balestriero 的神经网络样条理论(Spline Theory)。在 TensorFlow Playground 上可以看到,当 ReLU 网络试图去拟合一个螺旋流形时,它的表现方式其实非常接近局部敏感哈希结构(Locality Sensitive Hashing, LSH)——它将空间切割成一块块的区域,然后通过这些分块去“预测”螺旋的形状。

但我们真正想要的远不止于此。这也与“冒名顶替(Imposter)”现象有关:模型可以“沿着图案把螺旋描一遍”,却无法继续延展这个模式。仅仅描摹出螺旋的轨迹,和真正理解并延续这个模式,两者天差地别。

如果模型能够以建设性方式来学习,也就是你们论文中所说的那种“复杂化”——通过抽象的构建块,再结合自适应计算,那么它就能真正理解螺旋的结构。这意味着,通过自适应计算,模型可以延续螺旋的形状,然后更新自身权重以实现适应性,这对智能来说至关重要。

我们非常清楚,未来的模型应该具备这些能力。但矛盾的是,当前的大模型“太能干了”,表面上,它们几乎比真正的自适应智能系统更聪明:总能说出我们想听的话,表现出令人惊叹的智能。然而我们也同样清楚:它们依然缺失一些最基本、最关键的智能属性,而这正是我们必须跨过去的下一道门槛。

Llion:所以我对现在的视频生成模型还是持保留态度的。你看之前有一阵子,大家一眼就能看出是 AI 生成的,因为手指头数目不对。当然,现在数据更多了,算力更强了,训练技巧也好了,模型终于“屈服”了,画出来的确实是五根手指。

但我们真的解决问题了吗?还是只是用蛮力逼着神经网络记住了“手有五根指头”?如果它拥有更好的表征空间,比如有“螺旋就按螺旋来表示”这种最基础的直觉式能力,情况会完全不同,它自然就“知道”手指该有几个,也不会犯这种低级错误。

某种意义上,这些模型表现得如此好,是一种不幸。规模化效果太好也是一种不幸,因为这让人们太容易把根本性的问题一扫了之。

大模型会取代人类做科研吗

主持人:你们可能写出了我心目中的年度最佳论文。这可能就是带我们迈向下一步的创新。你们还在欧洲拿到了 spotlight,这也证明了这篇论文有多出色。

Llion:其实 CTM(连续思维机器),并没有完全脱离我们如今被困住的“局部最优”处境,它并不是一种“完全跳出框架、颠覆性的新技术”。我们只是借用了一个很朴素的生物学灵感:神经元的同步机制。当然,这不一定完全符合生物学现实,人脑神经元也不是真的这么连线来搞同步的。但我就是想鼓励大家做这类研究。

而且说实话,这种点子其实很好“卖”。我们在这个过程中完全不用担心被抢发。这种压力完全消失了,我们不需要急着发论文,因为我们觉得:“大概率也没别人在搞这玩意儿。”

我们最终能获得 spotlight,我认为关键就在于:我们花时间把论文打磨得很细致,完成了我们想要的基准实验,尝试了所有计划中的任务,最终形成了一篇完善的论文。

我希望能鼓励研究者去承担更多一点风险,去探索那些更具想象力、带着一点投机性质、但面向长远的科学方向。遗憾的是,大家不敢试。但我希望 CTM 能成为一个榜样,告诉大家这是可行的。我们试了,虽然有风险,但我们找到了有意思的东西,也发了成功的论文。

主持人:如果我们真的找到了一个系统,能获取知识、设计新架构,做那种你说的开放式科学研究,那你认为未来研究进展的主导权会转移到模型上吗?

Llion:我觉得会。至于它会不会完全取代人类,我自己也常常在不同观点之间来回摇摆。

现在强大的算法已经在辅助我们做研究了,而未来它可能会成为一种更强大的辅助工具。比如,我们推出的 “AI 科学家” 系统就展示了端到端的研究能力:从输入一个研究想法开始,你可以完全放手,让它自己完成“构思问题、写代码、跑实验、收集结果、再写论文”的整个科研流程。事实上,我们最近已经有一篇 100% 由 AI 生成的论文被接受了。

但我们这么做主要是为了证明其可行性。但如果让我选,我希望它更具交互性:我抛出个想法,它能反馈更多点子;可以跟我讨论,再去写代码;我可以查看它的代码、检查逻辑,它跑实验,再在结果出来后我们一起讨论。这才是我设想的近期内与 AI 合作研究的方式。

主持人:你能深入谈谈为什么吗?是因为模型还不够懂,需要我们监督?还是说希望产出的成果符合人类兴趣?

Llion:更多是因为,最开始抛出的那个研究想法其实很难描述清楚。这跟带实习生是一样的。我不可能跟实习生说“我有一个疯狂的想法”,然后解释五分钟就把他扔那儿四个月不管。必须有来回的讨论,我有我想探索的特定方向,我得不断地把他们拉回我最初设想的轨道上。

主持人:你之所以能做到这一点,是因为你有丰富的背景、经验、路径依赖,你能够基于深刻的理解做直觉上的创造性决策;你知道哪些想法是值得追的,哪些不是。而实习生没有这些,未来的 AI 模型也许会具备。

Llion:对,没错。如果模型发展到那种程度,我的输入反而会拖后腿,那确实就要放手了。这有点像国际象棋。曾经有一段时间,人机结合下棋能赢过纯 AI 引擎。但现在已经不是了,人类参与进来反而会让 AI 下得更糟。那当然会是一个新的时代。

CTM 做了哪些创新

主持人:我觉得现在正好可以聊聊这篇论文的细节了,就是你刚才提到的“连续思维机器”。

Luke:我的主要研究方向就是 CTM。我们整个团队大概在这个项目上投入了八个月左右的时间。在目前的 AI 研究领域,八个月的周期可能算有点久了。

它最初不叫这个名字,我们之前叫它“异步思维机器”,但每次有人问异步体现在哪,就有点讲不清楚,所以改成了“连续思维机器”。它主要包含三个创新点。

第一个是我们所谓的“内部思维维度”(Internal Thought Dimension)。这个概念本身不新,它跟“潜在推理”(Latent Reasoning)的概念类似,本质上是在一个序列化的维度上投入算力。当你用这种框架来思考问题时,会发现很多看似需要智能才能解决的问题,其实本质上都是序列化的问题。

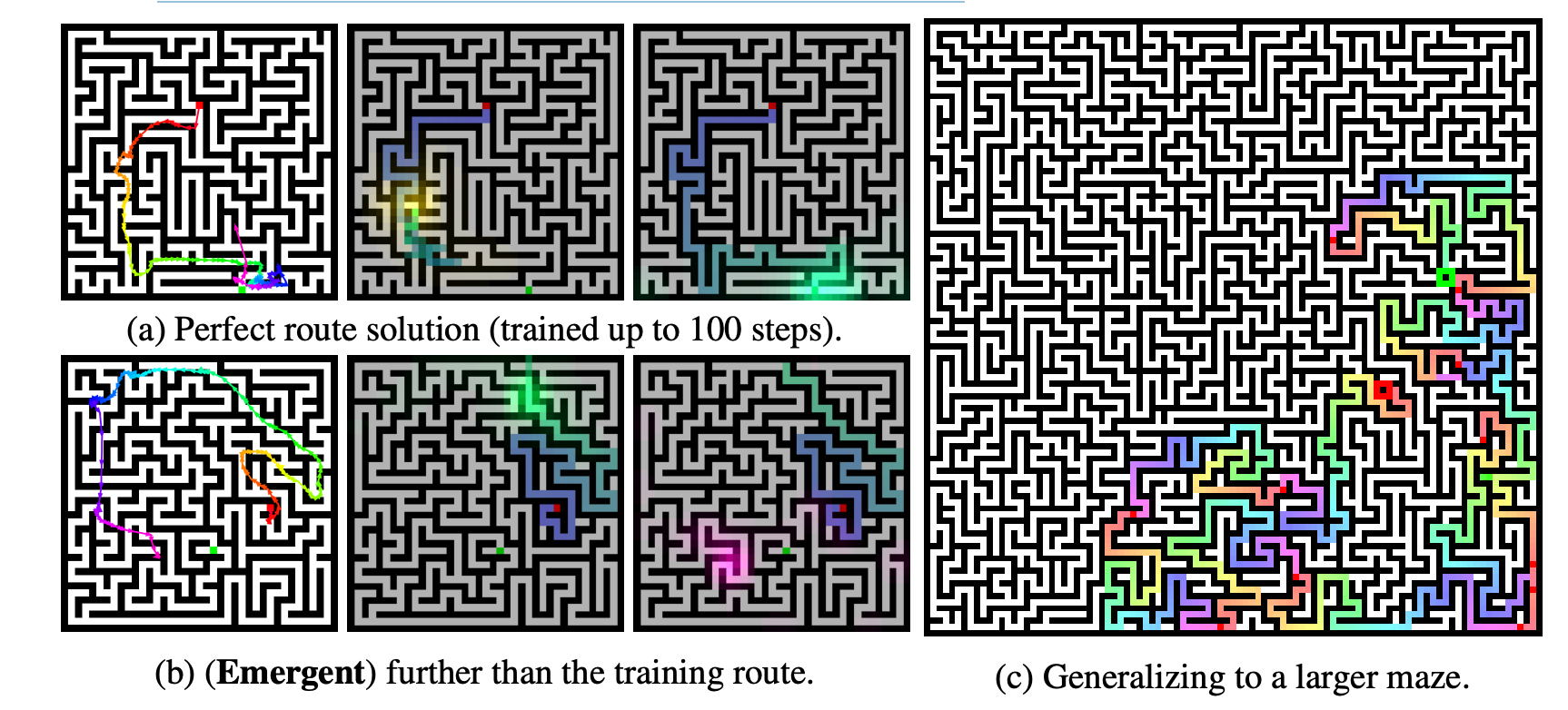

比如,我们在 CTM 上测试的第一个主要任务就是“迷宫求解”。

如果你把迷宫图片输入一个卷积神经网络,让它输出一个同尺寸的图像,在路径位置标 1、非路径位置标 0,这对深度学习来说几乎是小菜一碟。已有很出色的研究证明,通过谨慎的训练方式,可以让这种方法几乎无限扩展,效果非常惊人。

但如果你把这种方法拿掉,转而问:“更接近人类的解法是什么?”它就变成了一个序列问题:你需要一步步地规划 “向上、向右、向上、向左” 等路径,从起点一步步推演到终点。

当你把问题约束到这种序列化方式时,对机器学习系统来说,挑战性反而大大增加了。所以,这成为了我们 CTM 的“Hello World”问题,而我们就是通过在模型内部引入一个连续的“思维序列维度”来解决它。

第二项创新是重新思考“神经元应该是什么”。

在认知神经科学中,有大量优秀的研究揭示生物神经元是如何工作的。而在深度学习领域,神经元则被简化为非常抽象的东西,例如 ReLU 本质上是要么开、要么关。这种抽象其实是非常粗糙的。

于是我们尝试:让每个神经元本身就是一个小模型。事实证明,这种方式能够在系统中自然形成更丰富的动态结构,也让模型具备更复杂的内部行为。

第三个创新点是表征方式。

这来自一个核心问题:如果思考是一个过程,那它的“表示”到底是什么?在生物系统中,思考的表示难道只是“当下每个神经元的状态”吗?我个人的观点是:不是。思考不是瞬时状态,而是跨时间存在的。

所以在工程上,我们不再衡量“某一时刻的神经元状态”,而是测量神经元之间在时间上的同步模式,即成对神经元如何一起变化,以及它们与其他神经元如何协同。这种表示方式打开了一个全新的空间,使得许多新能力成为可能。

主持人:Anthropic 之前发过一篇关于生物学类比的论文,他们也在谈论规划和思考。他们声称他们的系统是在做提前规划,但我觉得你们的系统在计算上是不同的,可以解释一下吗?

Luke:是的,如果从图灵机的角度来看,这种计算边界非常有趣。图灵机能够在纸带上读写,这种图灵完备的概念显然是一个改变世界的伟大想法。

而 Transformer 和 CTM 的主要区别在于:CTM 的“内部思维过程”可以用来拆解问题。

一个问题如果是简单的,当然可以一次性求解。例如前面迷宫的例子,理论上你可以一口气解决。但对于很多“真实且困难”的问题,把它一次性解决会让难度呈指数级飙升。

比如在迷宫任务中,如果让模型“一步到位”预测未来 100~200 步的路径,现有的模型做不到,我们训练的模型也不行。因此,我们必须建立一个“自动课程学习”系统:先让模型只预测第一步,预测对了再训练第二步,然后是第三步、第四步……最终形成复杂能力。

真正有意思的是这种训练方式带来的结果行为。

我喜欢的一种研究方式,也是我鼓励团队成员采用的方式,是理解模型的行为,而不是只看几个指标。因为现在我们训练出的模型在许多方面展现出越来越“智能”的行为,常常让我们惊讶。如果把它们复杂的行为压缩成一个分数或少量指标,可能根本不适合,甚至会误导我们。通过观察模型在特定训练方案下的行为方式,反而能更好理解内部到底发生了什么。

主持人:你们是固定思考步数的吗?大概有一个“上下文窗口”?大概是 100 步左右?

Luke:是的,在迷宫任务中,模型每一步都能看到完整的迷宫图像(它始终可以“同时观察整个输入”),CTM 对输入数据类型是完全“无感”的(语言 token、图像、数字排序任务都可以)。 模型采用注意力机制从数据中检索信息,并且有大约 100 个内部思考步骤。

训练方式是这样的:比如模型正确预测了迷宫的前三步后,在第四步走错了,我们就会停止对前三步的监督,只监督它第四步怎么走。实践中我们会让它多监督 5 步,但原理相同。这会形成一种自我引导式的能力增长机制。

对理解力强的读者来说,你可以很容易想到这种方式如何推广到其他序列任务,比如语言模型的长距离 token 预测、分步骤规划任务、多变量排序或推理过程等各种需要“连续思考”的领域。

主持人:我对“自适应计算”这个概念很感兴趣。第一个问题是,模型的性能对这个固定步数有多敏感?第二个问题是,这些步数能否是“可变的”?也就是说,模型能否根据不确定性或某种准则,自动决定思考更少或更多步?第三个问题是,是否有可能让模型拥有“任意多”甚至“无限多”的思考步数?

Luke:这是非常好的问题。我先回答关于不确定性和步数敏感性的问题。

一个很好的例子是:我们在 ImageNet 分类任务上训练 CTM,损失函数非常简单:我们让模型运行,例如 50 个内部思考步骤,然后从 0 到 49 之间选两个点:模型表现最好的一步(损失最低) 和模型最确定的一步(输出置信度最高),在这两个点分别计算交叉熵,然后取平均作为最终损失。

这么做会自然诱导一种行为:简单样本通常在第 1、2 步就能解决,而困难样本会自然地“思考得更久”。模型会“自动”使用更多的内部时间,而不需要人为设计复杂机制去强迫它思考更多步。

主持人:你们把每个神经元都建模成一个 MLP,这非常有意思。能进一步讲讲这个设计吗?你们还用了“同步化”的概念,能详细解释一下吗?

Luke:当然可以。这是解释论文里所谓“神经元级模型(Neuron-Level Models, NLM)”的好时机,因为同步化的概念正是建立在它之上的。

你可以把一个递归系统想象成一个状态向量,这个状态向量会随着步数不断更新。我们追踪这个状态向量,并让它随时间展开。对于系统中的每一个神经元 i 来说,我们都有一个展开的时间序列,该序列虽然是离散的,但数值是连续的。这些时间序列定义了我们所谓的“随时间变化的激活值”。

“同步化”是什么?非常简单:同步化就是两个神经元时间序列的向量点积。

假设系统中有 d 个神经元,那么就有大约(2/d)种不同的同步对。例如神经元 1 如何与神经元 2 同步、神经元 1 如何与神经元 3 同步……以此类推。同步化的意义在于,它不是看某个单点的激活,而是看激活随时间的动态关系。

NLM 的工作原理是:它会接收一个有限历史激活序列(比如前若干步的神经元激活值),而不是只考虑单步激活。它利用这个历史信息来计算输出激活值,这就是从“前激活”(pre-activation)到“后激活”(post-activation)的过程。

你可能会觉得这很随意,但它确实带来了性能上的提升。不过这并非我们的主要目的。我们追求的是“生物学上的合理性建模”,即在生物学(大脑信息处理的实现方式)和深度学习(高度并行、学习超快、反向传播友好)之间找到一个平衡点。NLM 正是这个理想的中间方案,它能让我们引入一些生物学灵感,但仍然能用深度学习的方式进行训练。同步的概念则是应用在这些 NLM 的输出之上的。

主持人:关于规模扩展的问题,时间复杂度在同步矩阵的维度上是平方级的,你们在论文中提到通过“子采样”来提高性能,但这是否会影响稳定性?这么做的代价是什么?

Luke :这是一个很好的问题。在稳定性方面,我们发现了一个很有趣的现象,也是我们在整个论文实验过程中一直感受到的:无论我们如何尝试,它都能“跑起来”,而且对各种超参数的容忍度非常高。相比之下,用 RNN 或 LSTM 通过时间反向传播(BPTT)通常非常棘手,内部迭代步数一多,学习就会崩溃。

我们使用同步机制,某种意义上是在所有时间点触及了所有神经元,这对“梯度传播”非常有帮助。

还有一个与同步相关的有趣点:假设有 d 个神经元,就会有(2/d)种可能的组合,这意味着系统的底层状态或表征空间远比仅使用 d 个神经元要大得多。而这一点对下游计算、性能以及我们能实现的功能意味着什么,正是我们目前正在积极探索的。

CTM 为什么优于 Transformer

主持人:能简单解释一下,为什么你们认为 CTM 架构在这些方面会显著优于 Transformer 吗?

Luke:我觉得过去几年,语言模型领域最吸引人的工作,就是和“思维链”(CoT)相关的。某种程度上,我认为 CoT 是增加系统计算力的另一种新的“扩展维度”。这是一个非常深刻的突破。我们现在要做的,就是让推理过程完全发生在模型内部,但同时仍然以某种序列化的方式运行。我认为这是非常重要的一点。

你刚才提到了 Gemini 的扩散模型,现在确实有很多团队在探索类似方向。而我认为 CTM 通过“同步机制”和“多层级的时间表征”,在这方面提供了一种尚未被其他方法触及的灵活性。更关键的是,这种高维的潜在空间可以用于不断预测 ARC 中的下一步、再下一百步、甚至两百步,把复杂问题分解为模型可以快速搜索的推理路径。我认为这是一条很有前景的路线。

主持人:你们这个架构跟 Alex Graves 的神经图灵机有没有什么关联?

Luke:我觉得有。神经图灵机最难的部分在于内存的读写,因为它是一个离散的动作,这带来了很多挑战。我不敢说 CTM 明确具备图灵完备性,但我们是在一个潜在空间做推理,并以一种面向多任务的方式自行展开。

我想分享一个相关的观察:以 ImageNet 分类为例,包括各种分类任务,它们是很好的测试场景。数据中有非常简单的样本,也有极其困难的样本。当我们训练 ViT 或 CNN 来做分类时,它必须把从“简单的猫”到“复杂且样本稀少的类别”的所有推理逻辑,全都塞进同一个表征空间里,最后在统一的输出层做分类。

我认为,CTM 的设计打破了这种限制:我们把推理拆开,让模型在不同时间点上判断:“哦,我这里已经足够确定,可以结束了”,或者“这个样本更复杂,需要继续思考”,那么任务就能自然分解为“简单部分”和“困难部分”。我们知道课程学习和连续式学习是有效的,这也是人类学习的方式。如果把这种机制直接镶嵌进模型架构里,并让它自然涌现,那绝对值得探索。

Llion:顺便说到模型校准,现在的神经网络往往校准得很差。理想状态下,如果模型对一个类别的预测概率是 50%,那么它应该在 50% 的时间里是正确的。但事实是,大多数模型训练久了都会变得严重失衡,需要做大量后处理来修正。而我们测了 CTM 的校准度,结果几乎是完美校准。这再次证明了这种架构可能是一种更好的设计方式。

有趣的是,我们并不是为了“做一个校准好的模型”而设计 CTM,也不是为了“实现自适应计算时间”。

我当年特别喜欢 Alex Graves 关于自适应计算时间的论文,那篇论文为了让模型学会“什么时候该停”,不得不添加一个额外损失项来惩罚过多的计算,并且需要大量超参搜索才能让模型真正学会动态计算。但在 CTM 里,我们之前讲过的损失函数设计,这种自适应计算时间竟然是自然涌现的,我们完全没有显式去优化它。

我觉得这才是研究应该走的方向:不是预设一个特定目标,而是从一个有趣的新架构出发,沿着“有意思的梯度方向”探索,让新的能力自然生长出来。

主持人:没错。说到这个,我觉得你们论文最令人兴奋的地方可能是,之前讨论的 “路径依赖” 和 “逐步构建的理解”,这种 “复杂化” 的过程可能与世界模型相关,也与主动推理有关。我们要构建能持续学习、更新参数的智能体,重要的是能构建这种“路径依赖的理解”。因为“如何到达那里”非常重要,这个架构有可能让这些智能体利用这种算法,去探索空间中的轨迹,找到最佳路径,并真正构建出一种 “按自然关节划分世界” 的理解方式。

Luke:这是一个很精妙的视角,我以前没有这样想过。但确实,这种立场在处理模糊问题时会变得非常有趣。因为“用一种方式切割世界”,可能和“用另一种方式切割世界”同样有效。

语言模型出现的幻觉,也许就是在某种精细的层次上“切割了世界”,只是在我们认为的“幻觉”衡量标准下,它的性能不达标。但是当你沿着自回归生成 token 的路径走下去,你最终会得到对世界的一种不同的切割。

而我们想要做的,是训练一个模型,让它能隐式意识到它正在以不同的方式切割世界,并且能够探索这些‘切割’的可能性。我认为这是一种非常令人兴奋的研究方向:将问题分解为可解决的小部分,并以自然的方式学习求解,而无需过多的人工修改。

主持人:这也是我一直在思考的问题。比如说,尽管我非常喜欢 Cholet 衡量智能的观点,但在他的框架里,“适应新奇性”的核心是给出正确答案,而“给出这个答案的原因”同样重要。在机器学习体系中,我们往往依赖损失函数,而损失函数经常会引导模型走向各种捷径。当然,我们也可以退回到符号主义系统,讲究知识构建与语义保持的原则化路径。但我们现在做的是混合体系,因此应该存在一种自然的推理方式:即便最终目标是优化损失函数,但由于模型在开放空间中探索的路径不同,我们至少能在机制层面更有信心:它所进行的推理更符合真实世界的结构。

Luke:你的理解非常到位。显然,不止我们在这样思考,也不止我们在尝试这样做。真正特别的是,我们恰好拥有一种非常适合做这件事的架构——而且某种程度上是意外的,因为它本来也不是为了这些目标设计的。我们只是尽可能尊重大脑、尊重自然的机制:如果我们构建一个受此启发的系统,会发生什么?会出现哪些不同的解题方式?而这些不同的方式出现之后,又能让我们提出哪些新的哲学层面、智能层面的提问?这就是我们现在所在的阶段。

对我来说,有时会感觉问题太多、能处理的人手太少。但我也想借这个机会鼓励年轻研究者:追随你的兴趣,构建你真正关心的东西,看看它会产生什么效果,打开哪些新的大门,引领你走向哪些更深的领域。

可否用来构建下一代语言模型

主持人:我们昨天也讨论过,语言可以被视为一种 “迷宫”,那么有没有可能利用这种架构来构建下一代语言模型?

Luke:说实话,这正是我目前正在积极探索的方向。当迷宫任务加入歧义性之后,它变得格外有趣,因为迷宫可能有多种解法。老实说我自己还没尝试,但也许下周我就会试一试。

你可以想象一个智能体(或 CTM)在观察迷宫并做出行动轨迹。在我们最新的 arXiv 论文(最终版本)中,我们添加了一个补充部分,其中列出了 实验中出现的 14 个有趣现象,其中一个就是:在训练中,模型会先沿着某条路径前进,然后突然意识到“糟糕,错了”,接着回溯,再走另一条路径。随着训练的进行,它越来越擅长迷宫导航,依靠多头注意力的分布式能力逐步收敛到一种很有效的策略。但在早期阶段,它确实会探索多条路径、反复回溯。

我们还有一组更震撼的实验:如果模型没有足够的时间去走完整个迷宫,它会采用“福斯特算法”式的更快的算法。这让我非常震惊,在被严重限制“思考步数”的情况下,模型不再沿迷宫路径慢慢走,而是直接跳到迷宫中大致正确的位置,再倒推路径;然后再次跳跃、再倒推,如此周而复始。这种“跳跃式反向填补路径”的行为完全是由系统时间约束自然涌现。

这引出了很多深层问题:在有限思考时间 vs. 无限思考时间的条件下,模型具体学到了什么不同的算法? 这些差异是否揭示了人类在“受限条件下”与“开放条件下”思考方式的不同?这种行为是否触及某些关于推理本质的问题? 我认为这些问题都非常值得继续挖掘。

主持人:你们俩都是群体方法和集体智能的忠实粉丝,现在我们可以横向扩展这种架构:不仅仅是简单的并行化,还包括并行模型之间的权重共享等。这种扩展可能会带来什么潜在收益?

Luke:这是个非常有趣的研究方向。我们团队现在正在积极探索的一件事,就是记忆机制,尤其是长期记忆,以及这种机制对于这类系统意味着什么。

举个例子:可以构造一个实验,把一些智能体放进迷宫里,让它们自己去解决。当然,不是论文里那种做法,而是在一个极度受限的设置中,例如智能体只能看到周围 5×5 的局部区域,然后我们再给它提供一种保存与检索记忆的机制。任务很简单:走到迷宫终点。

模型必须学会如何构造记忆,以便当它再次来到一个地方时,能意识到:“上次我在这里走错了,这次要换一条路。”进一步地,可以让多个并行智能体共享同一个记忆结构,在同一迷宫里行动,观察会发生什么。它们访问同一个全局记忆,几乎像一种“文化记忆”,所有智能体都可以利用它协作解决任务。我确实认为,记忆将是未来 AI 研究的一个关键要素。

Llion:刚才也提到推理能力。最近外界之所以感觉“推理能力大进步”,因为这确实是大家目前最关注的方向之一。

我们最近发布了一个新数据集,叫 SudokuBench。几周前看到你们播客里自然提到它,我挺开心的。我想多聊一下这个基准,因为我在推广它时遇到点困难:听起来并不“性感”,毕竟一提到数独,大多数人会觉得“这不是早就被解决了吗?” 那一堆数独怎么会对推理研究有意义?

但我们谈的不是普通数独,而是 “变体数独(variant Sudokus)”。

普通数独规则是:每行、每列、每宫填 1~9,不重复。变体数独则是在普通数独规则之上,附加了任意数量、任意形式的额外规则,并且每一个都由人类精心手工设计,拥有完全不同的约束结构。其中一些约束需要非常强的自然语言理解。比如有个谜题会给你一段规则文本,然后告诉你:“顺便说一句,刚才那段描述里有一个数字是错的。” 也就是说,你必须先对“规则本身”做一次元推理,才能开始解题。还有一些谜题是在数独网格上叠加迷宫结构,要求小老鼠按迷宫路径走到奶酪的位置,但路径上经过的格子数字还要满足额外的加和约束。

这些变体数独的多样性难以用语言描述。如果有模型能在这个基准上取得好成绩,它必然具备极其强大的推理能力。目前最好的模型只能在其中最简单、最小的谜题上达到 15% 左右。

我们会发布一篇关于 GPT-5 表现的博客,虽然有提升,但依然完全无法解出许多普通人都能解出的谜题。

我非常喜欢这个数据集,它的灵感来自 Andrej Karpathy 的一句话:

我们现在有大量来自互联网的文本数据,但如果追求 AGI,你真正需要的不是“所有人类写过的文字”,而是“他们写下这些文字时脑中的思维轨迹。” 如果能学习这些,人类级推理就有可能出现。

我当时就在想:这种数据一定存在于某个地方。

我最开始想到的是哲学,比如意识流写作,但那并不可靠。结果在我看 YouTube 时找到了 Cracking the Cryptic 频道。频道里两位英国专家会现场解极难的变体数独,视频有时长达 4 小时,而且他们会用极度细致的方式讲解每一步推理过程,这几乎是完美的“思维轨迹”示例。

我们征得他们同意之后,把所有视频做了转写和处理,形成了一个高质量的人类推理语料库,用于模仿学习。

我们也试过用内部模型训练,但事实证明,我可能把基准做得太高了,以至于目前模型还没能有效利用这些数据。我们之后如果取得进展会公开。

我想强调的是,这是一个完全不同类型的推理基准。 它既极度明确,又极度难以泛化,而当前 AI 无法做到“找到破题点”,只会退化为机械穷举式尝试,完全不像我们从视频语料中看到的人类推理方式。因此,我想在这里向全行业发出挑战:如果能在这个基准上取得突破,那将是真正意义上的 AI 推理能力进步。

主持人:你觉得这些推理模式的多样性如何?也许我有些理想主义,但我喜欢 “知识的演绎闭合” 这个想法:存在一个巨大的推理树,我们每个人都掌握着这棵树不同深度的部分。越聪明、知识越渊博的人,就能沿着这棵树走得越深。我们原则上可以构建推理引擎,让它从第一原理(First Principles)开始推理。但这可能是“计算上不可约的”(Computationally Irreducible),意味着你必须执行所有的步骤。但由于我们并不拥有这棵树的全部,我们需要做的就是 “四处摸索”,寻找 “乐高积木”。也许目前 AI 领域需要做的,就是尽可能多地获取这棵树的部分。但我们能一直深入到最底层吗?

Llion:这是一个引人深思的问题。这棵树可能会非常庞大。人类在解谜时,肯定是在实时学习,不断发现这棵树的新部分。这实际上是一个“元任务”,你不仅在推理,你还在对推理本身进行推理。

我不认为我们现在的 AI 具备这种能力。如果你看那些视频,他们会说:“好的,这看起来像一个奇偶性任务”,或者“这是一个集合论问题”,又或者“也许我该拿出路径工具来追踪一下。” 当然,这些专业人士的脑子里已经有了你说的这个庞大的“乐高积木”集合。所以他们能一眼认出:“这种规则通常需要这类乐高积木。”

看着他们凭借直觉就知道该从哪里入手,真的很神奇。而像我这样解谜不多的人,就需要花很多时间去尝试。但即使是他们也不是完美的。你经常看到他们尝试一种推理路径,然后发现:“不行,这不够明确。” 然后他们会回溯,再走另一条路径。再说一遍,这是我们在当前的 AI 模型中,在解决这个基准测试时看不到的行为。

主持人:这棵树真的非常大,我想树上许多推理模式之间的“系统发育距离”(phylogenetic distance)非常遥远,这使得它们之间很难直接跳跃。这也是为什么我认为作为“集体智能”能很好地合作,因为我们能找到跳到树上不同部分的方法。

Llion:是的,我想这可能就是为什么我们现在尝试应用的强化学习(RL)算法行不通的原因。想要学到这些突破性的思路、理解那些细微的推理,你必须进行采样。但所需的推理类型太具体、太稀有,所以这种技术根本行不通。目前社区里有一种错觉:“我们有 RL,现在所有问题都解决了。” 但对于这个数据集来说,并非如此。

主持人:在结束之前,我想问一下你们正在招人吗?我们听众里有很多优秀的机器学习工程师和科学家,我觉得能在 Sakana 工作会是他们梦想中的工作。

Llion:是的,我们当然在招聘。正如我之前在采访中所说,我真心希望给研究人员尽可能多的“研究自由”。我愿意下这个赌注!我相信这会带来非常有趣的结果,而且我们已经看到很多有趣的东西涌现出来了。

原文链接:

https://www.youtube.com/watch?v=DtePicx_kFY