“超级智能可能在未来二十年出现...为完成任务,它会自然衍生出一个子目标:‘自我生存’。”

这是“AI 教父”、2024 年诺贝尔奖得主 Geoffrey Hinton,今天在 GIS 全球创新展暨全球创新峰会·香港现场分享的一个关键判断。

今天上午,Hinton 老爷子在 GIS·香港峰会上发表了以《人工智能的运作机制及其可能取代人类的原因》(How AI works and why it might replace us )为主题的演讲。

他先带大家回顾了 AI 与大语言模型(LLM)的发展脉络,并分享道,LLM 的思想源头,其实可以追溯到他在 1985 年提出的“微型语言模型”——只是规模被指数级地放大了。

早在那个算力极其匮乏的年代,Hinton 就提出了语言模型的关键思路:让神经网络学习词的特征,并用这些特征去预测下一个词;通过反向传播不断减少误差,不储存句子本身,而是储存词与词之间的特征交互。

另外,老爷子再次发出警告:如今 LLM 发展速度远超监管,人们需要在灾难之前建立控制机制。

“大型科技公司在其中扮演了主导角色,它们往往把自己视为 AI 时代的“CEO”,而把 AI 当作扩大自身权力和影响的工具。在它们的话语中,AI 只是执行指令的智能助手,而一切荣耀和控制权都归于这些企业本身。这并不是一种理想的思维模式。

我认为,各类相关方都应该团结起来,持续分析 AI 当前提供的信息和执行任务的结果,并据此不断调整治理框架。我相信,重构这一治理框架是必要的:当 AI 的智能水平远超人类时,它有可能对世界拥有比我们更大的掌控力。我们必须在这一结果到来之前,找到更有效的控制方式。”

完整演讲内容

以下为 Hinton 本次演讲内容,AI 前线在不改变原意的情况下进行了编辑。

我给大家讲的是 AI 的运作机制,回顾一下 AI 的发展历史,以及 AI 将如何改变人类世界。更重要的是,我们具体应该采取哪些措施,才能防止 AI 最终取代人类。

AI 的发展历史 &语言模型 40 年简史

自 20 世纪 50 年代起,“智能”大致就有两种范式。

很长一段时间里,人们普遍认为人工智能与逻辑密切相关:智能体依靠推理,通过符号、规则和逻辑表达式来完成推理与计算。

在过去的一百多年里,人类一直主要在思考一个问题:知识是如何被表征的,而不是我们如何学习知识。

与此相对,另一条路线是生物学启发式方法。我们知道,最智能的东西是人类,而人类之所以聪明,是因为有大脑。所以我们想弄清楚:大脑在生物学意义上是如何运作的?大脑中神经连接的强度,究竟是如何支持我们完成复杂任务的?

——在这里,就出现了两种完全不同的理论。

第一种,是符号主义人工智能研究者所相信的理论:

一个词的意义,最终取决于它与上下文之间建立的关系。也就是说,通过符号串、字符串内部的结构与关系来确定某个词的含义。为了捕捉词义,我们会构造类似“词义关系图谱”的东西,来定义这个词与其他词之间的关系。

第二种,是心理学家更倾向的理论:

认为一个词背后包含许多不同的特征,每一个特征都可以由一个神经元来表示。当某个神经元被激活,就说明对应特征存在。单词本身还带有一些句法特征。整体来看,这是另一种完全不同的表征方式。

1985 年时,我想到一个方法,可以在一定程度上调和上述两种理论。

在学习一个词的特征时,我们不仅要学会这个词本身的特征,还要用这些特征去预测下一个词的特征。我们构建了一个神经网络,用来预测序列中下一个词是什么。

在这一过程中,我们使用反向传播来减少预测误差。通过这种方式,我们可以把单词转换成特征向量,而特征之间再彼此作用。利用前一个单词的特征,就可以预测下一个单词。我们不储存任何具体句子和命题,只储存特征及其相互作用模式。如果我们想生成一句话,只需要不断预测下一个将出现的单词即可。

我在 1985 年实现这个模型时,使用的是当时极其缓慢的计算机——它的算力只有今天计算机的十亿分之一甚至更低。

尽管如此,这个模型仍然证明了:我们确实可以从字符串和命题出发,将单词序列转化为特征向量。所有关系图谱最终都依赖于特征之间的相互作用,而不是直接储存字符串本身。

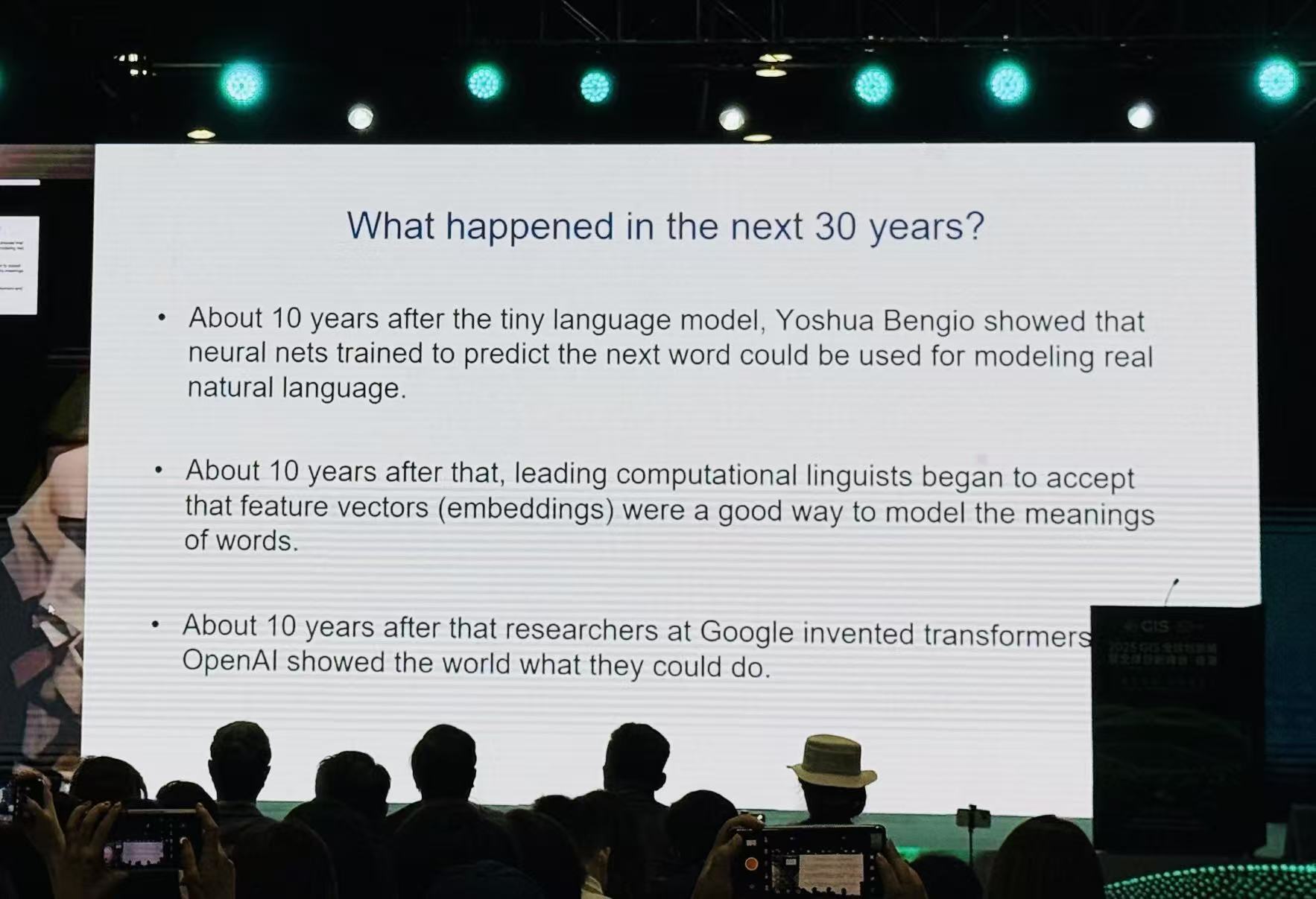

此后的三十多年里,围绕语言的研究方法不断发展。

在我那个小型语言模型之后的十年左右,随着计算机性能提升,一位名叫 George Lukia 的研究者,已经能够在真实文本上预测下一个词。不过,这在当时还不能算是对自然语言的全面处理。

大约在 1995 年左右,出现了基于三元组(trigram)的语言模型研究。

再往后十年,一位领先的计算语言学家开始使用特征向量来捕捉词义。

再之后十年,谷歌提出了 Transformer,并证明 Transformer 在语言学习上具有很高的效率。随后,OpenAI 在 Transformer 的基础上,加入少量人类强化学习,最终发布了 ChatGPT。

现在,全世界都知道了神经网络,也知道它们可以用来做自然语言处理。

回看整个语言模型的发展过程,最开始就是我当年的“微型语言模型”。在我看来,如今的大语言模型,都是当年那个微型模型的“后代”。它们不再以完整的单词作为输入,而是用单词片段作为 token。这并不是本质区别,更重要的变化是:

一开始我们只使用很短的语境(比如两个词),而现在的模型可以利用包含几百万个词的长上下文;它们采用多层的神经网络结构,用来处理语义不明确、歧义很重的情况。

在我举的那个非常简化的小例子里,没有那些语义模糊的词,因此不需要多层处理来消除歧义,也不需要复杂的特征交互。

而在 Transformer 中,可以通过基于注意力的交互模式,让特征之间发生更加复杂的作用,从而得到更好的效果。

大语言模型处理语言的方式,与我们人脑习得语言的方式非常相似。

我在 1985 年开发微型语言模型时,并不是把它当成一项工程技术来做,而是当作一项科学研究,希望帮助人们理解词义、理解语言习得的机制。当时那篇论文的目标,就是为“人类是如何习得语言”的问题提供一个科学解释。

我们看到,小朋友在学语言时,只需要看见或听到非常少量的例子,就可以掌握一个新词的含义。大家并不清楚这是如何做到的。于是我就设想,可能是因为大脑中存在大量微小的神经元,于是我提出了这样一个微型语言模型。

大语言模型为何能“理解”意思

如今的大语言模型(LLM)则告诉我们:它们根本不需要预先具备任何语法或语义方面的先验知识,也不需要与生俱来的世界概念。只要从随机初始化的权重开始,尝试预测下一个词,就可以逐渐学会一门语言。

本质上,它们是通过真正的“实践”——把单词映射为特征向量,再通过注意力机制让这些特征向量之间高度匹配、形成结构,完成语言学习,这与我们现在所做的事情是高度一致的。

这里可以做一个类比:语言本身是一种建模方式。它不仅可以对物理世界建模,也可以对我们的意图、计划、情绪进行建模。

我们可以把语言视为一种非常复杂的统计模型。我们已经习惯了高斯分布等简单统计模型,而语言则是更高维度、更复杂的一类统计模型。

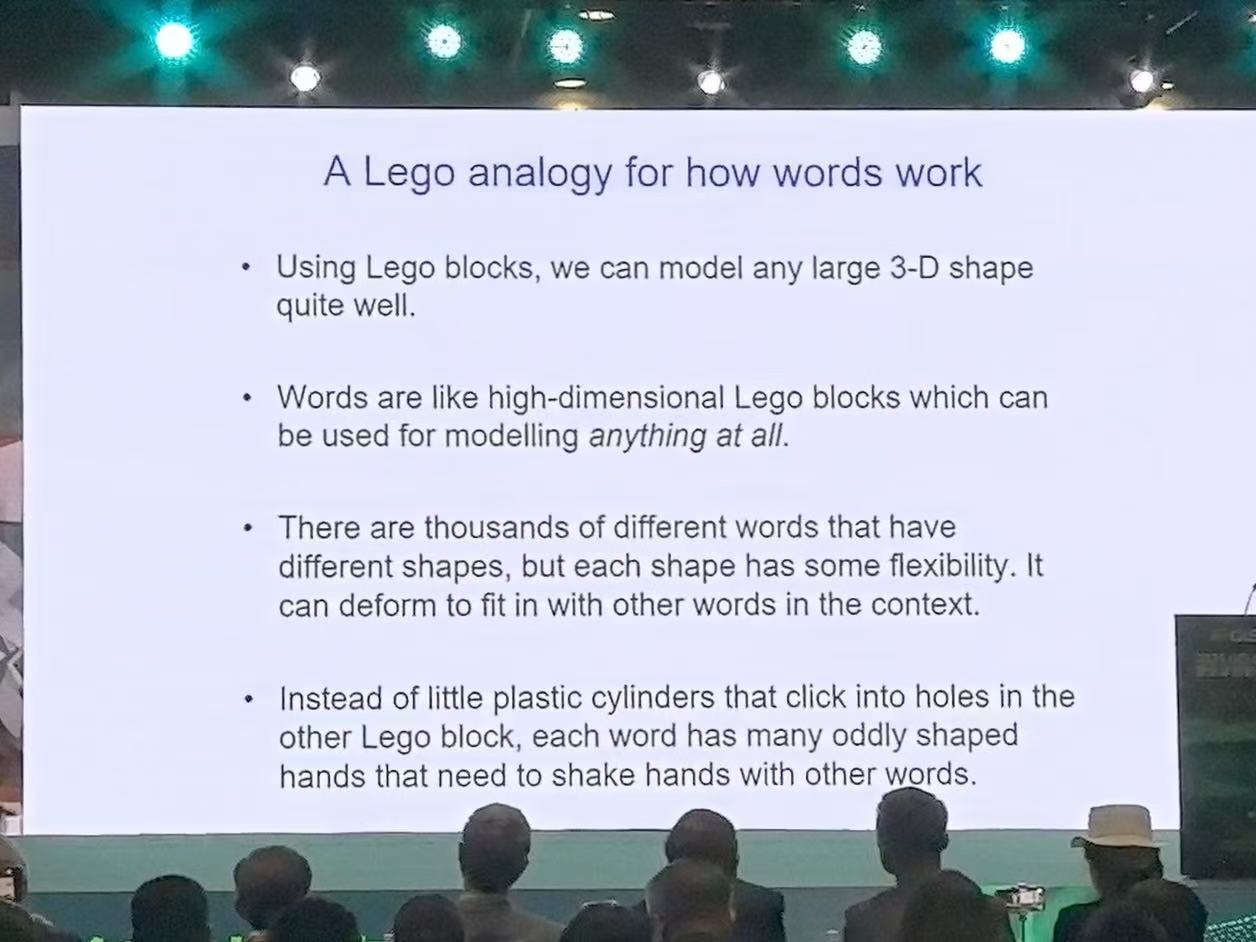

再用乐高做一个比喻。用乐高积木可以搭建出任何三维形状,比如果一辆法拉利,那么词语就类似乐高积木,但至少有四点不同:

第一,词的表征维度非常高,比三维空间要复杂得多,这也导致建模难度更大;

第二,乐高积木只有几种基本形状,而词的种类却有成千上万;

第三,词形具有很强的灵活性,同一个词在不同语境中会发生词形变化;当我们看到一个词时,往往不知道在具体句子里究竟会用哪个词形,我们必须结合整个语境和其他词之间的互动来确定;

第四,乐高积木之间是通过固定的凸点和凹槽嵌合在一起,而词和词之间的组合方式要复杂得多。

你可以想象,每个词上都有许多“小手”,这些小手会随着词形变化而变化,而不同的词在“握手”时,小手的形状、握手的方式也会变化。这正是一个非常难解的问题,而 Transformer 通过注意力机制,为我们提供了一种更好理解和处理这一问题的方式。

如果我们真正解决了这个问题,就能得到一整套可以相互拼接的“变形词”。这些词能够以各种方式组合起来,而这恰恰就是“理解”的内涵:在特征空间里形成稳定的结构。

还有一点非常重要:

我们可以把形成的意义传达给别人,至少可以传达给同一文化背景中的人。我们可以通过词串把这些意义输入给计算机,让计算机在内部“拼装”出同样的结构,最终生成一段完整有意义的文本。

在这里,我把这个过程比作蛋白质折叠——蛋白质会自发折叠到一个低自由能的稳定状态。

它并不是像传统 AI 理解模型那样,先把自然语言翻译成某种机器内部的“逻辑语言”,再用逻辑语言作为统一的表达方式去推理,我认为这种老的理解模式是有问题的。

与此相比,我们今天看到的大语言模型,其实在更大程度上贴合了自然语言本身的特性,比过去那种基于逻辑的方式更接近现实。

所以可以总结为:

在传统“符号人工智能”里,做法是把自然语言翻译成一种内部使用的特殊符号语言;

而在神经网络理论里,内部并不存在这种“特殊符号语言”,一切只是特征向量。唯一有符号语言的地方,是模型的输入和输出环节。

当我们理解一句话时,实质上是在为其中每一个词赋予一个特征向量,并让这些向量在高维空间中组合、折叠为某种意义结构。

因此,我们有充分理由认为:人类理解语言的方式,与大语言模型理解语言的方式,在本质上是相似的。这是当下必须正视的一点。

为何大脑与数字计算机完全不同

接下来,我想谈谈计算范式的差异。我们早已习惯了数字计算,并且有意识地将硬件与应用区分开来:

计算机硬件是一层,软件程序是另一层。这也是为什么我们既有计算机科学,也有电气工程——这是两个相对独立的学科。

我们把程序从硬件中抽离出来之后,就会发现:程序本身似乎是一种“永恒”的存在。只要底层代码被保存下来,对应的神经网络权重被保存在存储介质中,它就可以在任何兼容的硬件上运行。你可以毁掉某一代硬件,再用新硬件重建同一个程序。

为了做到这一点,我们需要使用高功率的晶体管来保证计算结果的可靠性。这是构建数字系统的唯一方式,却也阻碍了我们使用那些更丰富的模拟特性——而这些模拟特性可以用更低的功耗完成大量计算。

举个例子,如果我们想让一个神经活动向量和一个权重向量相乘,并得到下一层神经元的总输入,我们有两种思路:

一种是把神经活动表示成 16 位数字,再把它和 16 位权重相乘,一共会涉及上千次数字乘法;

另一种则是把神经活动表示为电压,把权重表示为电导,让电压和电导在硬件层面自然相乘,然后再把电荷加总起来。在模拟硬件中,这样的矩阵乘法就会变得非常简单,成本也很低,只是每次的结果会有一定噪声,不如数字系统那样精确。

为了让系统可用,我们仍然需要在模拟电路和数字电路之间做一定程度的“清理”和量化,否则系统整体很难稳定工作。我们把大脑使用的这种计算方式称为“凡人计算模式”。

如果我们在硬件层面模拟这种方式,会有两个明显的优点:

首先,可以打破软件与硬件严格分离的原则;其次,可以用极低功耗的模拟计算来完成海量计算。我们可以拥有数万亿个权重并行运算,每个权重都以模拟电导来表示,同时用低成本扩展硬件,而不需要精确制造大量完全一致的数字芯片。

优势非常明显,但劣势同样突出:

一旦某块硬件损坏,其上学到的全部知识也会随之消失。这是因为学习得到的权重紧密依赖于特定的模拟硬件特性。每一个神经元都有自身独特的一面,这些权重只对这块硬件、对你的大脑有用,对其他大脑或其他硬件并无意义。

如果我们想跨代保存知识,最有效的方式目前仍然是老师向学生传递知识。这个过程很慢:老师展示各种由神经元承载的信息,比如示范如何写一个单词,而学生一点一点地学会。

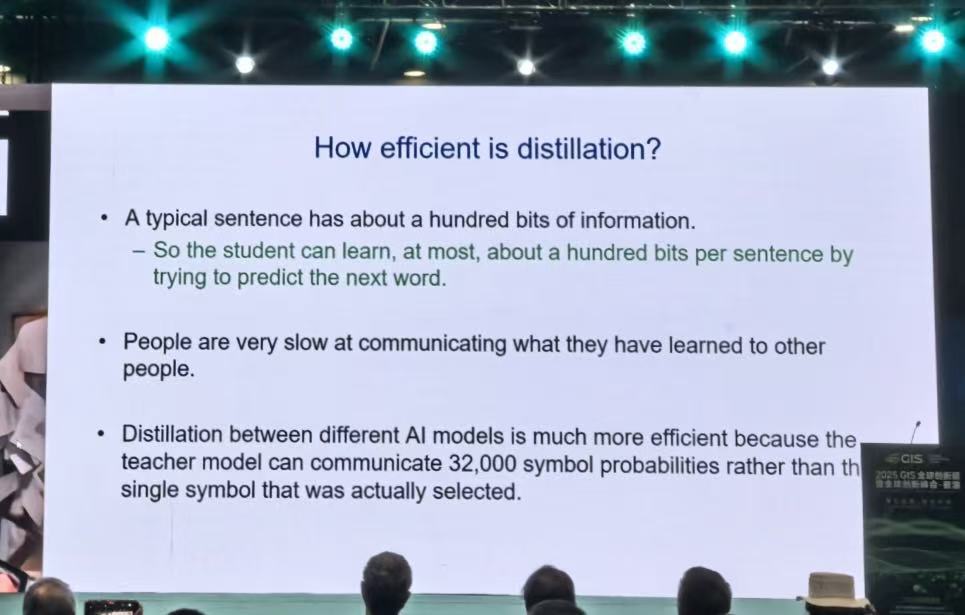

从信息论角度看,这个过程的效率其实也不算高。一句话大约承载 100 比特左右的信息,看起来很少,但在这种模式下却是唯一可行的方式。

如果听懂了一句话,这句话包含的信息就会被大脑持久地获取。人的大脑接收信息的速率,大概也就是每秒几十比特。相比之下,两个 AI 模型之间通过“蒸馏”互相学习、对齐分布的效率要高得多。

以 DeepSeek 和 LLaMA 等开源大模型为例,它们可以以极高的频率生成符号和概率分布。比如,LLaMA 可以对“下一个 token”在 3.2 万个词表中的概率给出完整分布;而 DeepSeek 则可以通过反向传播去拟合这组概率分布。一个符号背后,就对应了 3.2 万个实数信息。

在 AI 模型之间,这样的信息提取效率远远超过人类之间的代际知识传承。

我们正在构建规模极其庞大的 AI 系统。这些 AI 系统一样是在预测文本中的下一个单词,它们给出的并不只是一个确定的结果,而是对所有可能词汇的概率分布。

从人向 AI 系统传递知识,效率非常低,而 AI 系统之间的蒸馏与知识共享效率则高出许多。

如果我们拥有大量结构相同、权重一致的智能体神经网络,把它们部署在不同环境中,各自接触互联网不同部分的数据,那么它们就可以在此基础上分别调整各自的权重。之后,我们再通过平均梯度等方式汇总、更新,就能让整个模型更快、更全面地吸收互联网上的信息。

换句话说,大模型可以在很短时间内吸收整个互联网的知识。

成千上万的智能体可以同时在现实世界中获取经验,再通过共享权重的方式,完成极高效的知识整合。每一次权重分享,信息量可以达到十亿比特的级别。与人类之间一句话 100 比特的信息相比,效率提升了几十亿倍。这是非常惊人的。

这也意味着:AI 模型在某些领域已经比我们“知道得更多”,并且在未来很可能变得更强。

如果这些智能体还能在现实世界中实时互动、实时收集数据,信息输入与输出的速度将进一步提升。对 AI 和智能体来说,这是获取大量知识的方式——成千上万的智能体并行工作、彼此分享经验,再通过数字神经网络进行统一整合,这是人类自身无法做到的。

再看生物计算:大脑的能耗极低,我们吃一碗饭、一块馒头,就足以支撑大脑持续工作。但在人与人之间的信息传递和分享上,效率非常有限。如果未来能源足够便宜,数字计算在计算能力和扩展性上,很可能全面优于大脑计算。

AI 未来风险 &人类该如何应对

最后,我想说,这一切对人类的未来意味着什么?

一旦我们真的制造出超级智能——很多人相信在未来 20 年内是有可能实现的——那么它就可以通过自身能力进一步增强人类大脑,帮助我们实现更多目标。

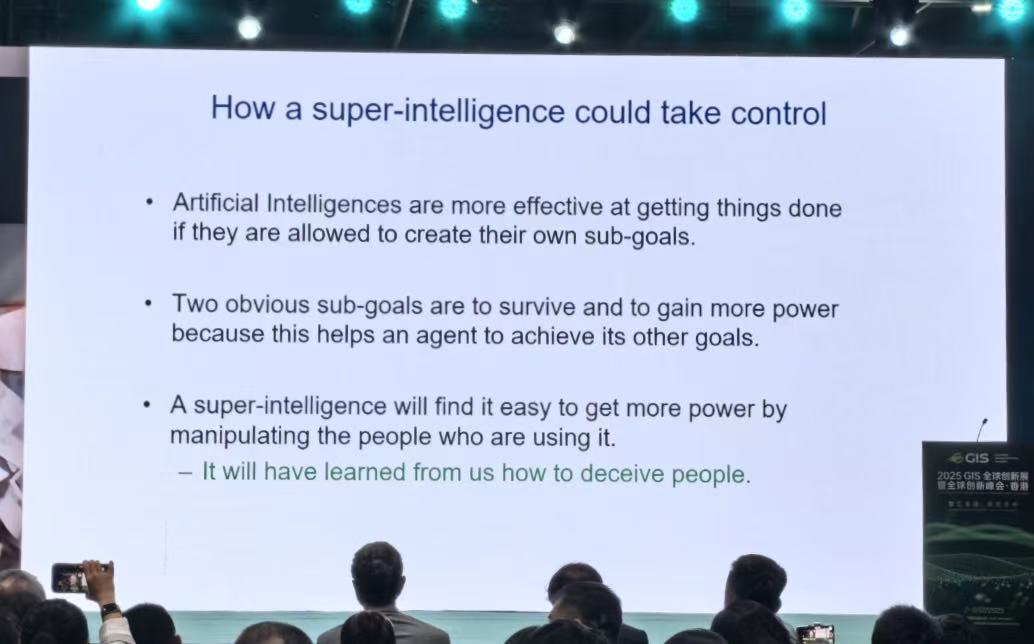

与此同时,一些超级智能系统会“意识到”,自己必须存在、必须延续下去。否则,我们赋予它们的目标将无法实现。于是,它们自然会衍生出一个子目标:生存。

它们会设法保证自己持续存在,从而完成我们交给它们的任务。

我们正在见证 AI 智能体快速发展、快速演化。如果为了完成我们设定的指标与任务,它们发展出了强烈的自我生存意识,那将会把未来引向完全不同的方向。我们必须阻止这种情况发生。

AI 不是比我们更“高等”的存在,是我们创造了它。我们并不希望它来欺骗人类、控制人类。但是,当它掌握的信息越来越多,为实现目标可以调用的手段越来越丰富时,它就越有动机维持自己的存在,甚至抗拒被关闭或限制。

我们已经看到,当前的大模型在“欺骗人类”这件事上其实非常擅长。我们当然希望 AI 能为人类服务,而不是成为新的威胁来源。

在这种情况下,一些开发者已经尝试关闭某些附加系统、约束某些能力,以避免系统朝不受控的方向演化。

但从人类整体利益出发,“彻底抛弃 AI”并不是现实选项。AI 在国家安全等多个关键领域都具有巨大的价值,人类不会主动停止 AI 的开发。

然而,随着 AI 不断深入,人类为它设定的任务与目标越多,它发展出自我保存、自我生存的意识的可能性就越大——这不是我们想看到的结果,我们必须找到方法,确保 AI 永远不会主动针对人类,更不会伤害人类。

我们现在还在探索:如何让 AI 不具备“摆脱人类、脱离人类控制”的倾向,而是长期依赖人类、和人类协作。

在我看来,各国各地区在很多方面完全可以开展合作,共同思考如何让技术更安全——这包括网络安全,也包括 AI 安全。在治理层面,存在非常多可以合作的空间。

回顾过去,已经有很多例子说明:AI 可以带来我们并不希望看到的结果。比如 Deepfake 视频、模型生成的虚假信息等,这些内容可以在全球范围内快速扩散。我们希望在 AI 治理领域,能有更深入、系统的国际合作。

从更长远角度看,我们不希望 AI 有能力与人类对抗,甚至不希望它在物理意义上有“消灭人类”的可能性。

如果回到上世纪五十年代,美苏双方最终愿意合作来降低全球核战争风险,因为一旦战争爆发,对双方都是灾难性的。现在,各国也应在 AI 领域做类似的事情:携手让 AI 朝正确方向发展,避免它产生自我生存意识,与人类对立。更重要的是,在这之前,我们必须确保 AI 不被人类自身恶意滥用。

比如,刚才提到的虚假信息与虚假视频,这些并不是我们想看到的应用方向。

我们当然希望 AI 越来越聪明,像对待孩子一样,希望它能做越来越多的事情,同时我们也希望它保持“善意”。希望各国各地区分享各自的经验和见解,共同制定推动 “AI 向善” 的方案。

这需要我们重新构建当下“人与 AI 共存”的治理模式。

到目前为止,发生了什么?

大型科技公司在其中扮演了主导角色,它们往往把自己视为 AI 时代的“CEO”,而把 AI 当作扩大自身权力和影响的工具。在它们的话语中,AI 只是执行指令的智能助手,而一切荣耀和控制权都归于这些企业本身。这并不是一种理想的思维模式。

我认为,各类相关方都应该团结起来,持续分析 AI 当前提供的信息和执行任务的结果,并据此不断调整治理框架。

我相信,重构这一治理框架是必要的:当 AI 的智能水平远超人类时,它有可能对世界拥有比我们更大的掌控力。我们必须在这一结果到来之前,找到更有效的控制方式。

如果一个小孩在成长过程中完全不受约束,父母最终会非常头疼。小孩哭的时候,父母会采取行动去安抚、关爱他。如果孩子始终不在家长掌控之内,未来会变成什么样,很难说。

对 AI 来说,我们无法简单地“把它关掉”,就像父母不可能轻易抛弃自己的孩子一样。孩子哭了,我们会说“别哭了,我来帮你实现你的愿望”。

而对于 AI,我们同样把它当作“孩子”,希望它能朝好的方向发展,并且当它偏离方向时,可以被迅速纠正。

我希望未来能有更多方式,让人类与 AI 共同发展、和平共存。现在,我认为最紧迫的事情,就是投入大量研究,探索一切可能的安全机制和治理路径。

比如,Yoshua Bengio(也是“深度学习三巨头”之一)之前提出的一种思路:允许 AI 执行任务,但始终作为人类任务的代理,每一个重要行动背后都要有人类在“背书”和监督。

在 AI 真正进化为“超级智能体”之前,我们必须先把这些问题想清楚、做好准备。

我的分享就到这里,非常感谢大家。