OpenAI 今天发布了 GPT-5.1,这是对其 8 月份发布的旗舰模型的更新。OpenAI 称其为 GPT-5 的“升级版”,使“ChatGPT 更智能,对话也更愉快。同时,OpenAI 在用户聊天界面增加了更多“个性 /语气”选项,如 Friendly(友好)、Candid(坦率)、Quirky(古怪)等。

OpenAI 深夜放出两款 GPT-5.1 新模型

新模型包括两个版本:GPT-5.1 Instant 和 GPT-5.1 Thinking。

根据 OpenAI 的官方公告,前者比其前代产品“更热情、更智能,也更善于遵循用户指令”,后者“现在更容易理解,处理简单任务速度更快,处理复杂任务也更持久”。在大多数情况下,系统会自动将用户查询匹配到最合适的模型。这两个新模型将于本周开始向 ChatGPT 用户推出,而旧的 GPT-5 模型将在 ChatGPT 的“旧版模型”下拉菜单中保留三个月,之后将下架。

GPT-5.1 Instant

ChatGPT 最常用的模型 GPT-5.1 Instant 现在默认更加亲切自然,更具对话性。根据早期测试,它常常以其趣味性给用户带来惊喜,同时又保持了清晰度和实用性。

据介绍,OpenAI 改进了指令执行能力,因此该模型能够更可靠地回答用户实际提出的问题。

GPT-5.1 Instant 首次运用自适应推理技术,在回答更具挑战性的问题前,能够自主决定何时进行思考,从而在保持快速响应的同时,给出更全面、更准确的答案。这体现在它在 AIME 2025 和 Codeforces 等数学和编程评估测试中的显著提升。

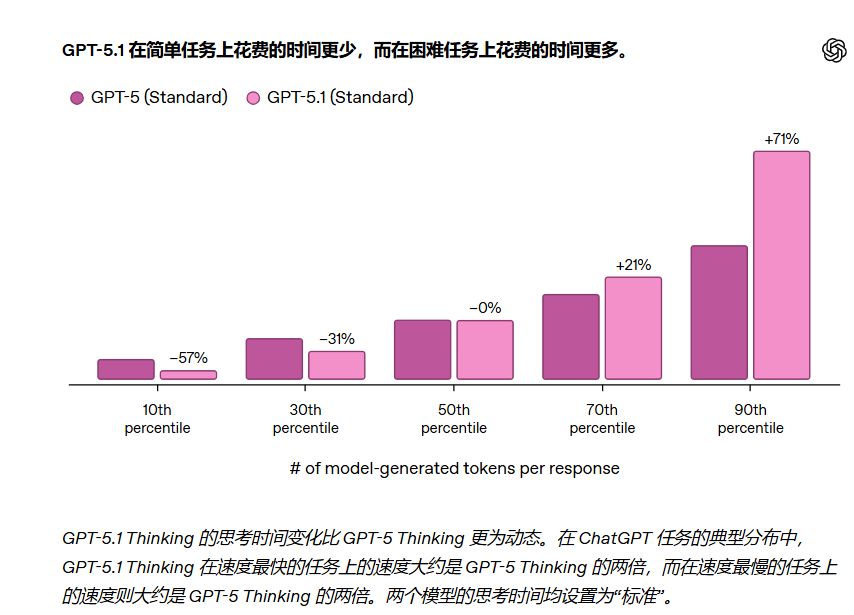

GPT-5.1 Thinking

OpenAI 也在升级 GPT-5 的思维模式,使其在日常使用中更加高效且易于理解。现在,它能更精准地根据问题调整思考时间——在处理复杂问题时投入更多时间,而在处理简单问题时则更快响应。实际应用中,这意味着对于难题,它能给出更详尽的答案;而对于简单问题,它则能更快地给出响应。

OpenAI 表示,此次版本更新在模型的功能和易用性方面都取得了显著提升。GPT -5.1 Auto 将继续把每个查询路由到最合适的模型,因此在大多数情况下,用户无需选择模型就会发现,GPT-5.1 的回答听起来更智能,语气也更自然。

GPT-5.1 Instant 和 Thinking 版本今天开始逐步推出,首先面向付费用户(Pro、Plus、Go、Business),随后面向免费用户和未登录用户。企业版和教育版用户可享受七天的提前体验(默认关闭)。体验期结束后,GPT-5.1 将成为唯一的默认模型。

同时,OpenAI 计划在未来几天内逐步推送,以确保所有用户都能获得稳定的性能体验。此外,OpenAI 表示很快也会将 GPT-5 Pro 更新至 GPT-5.1 Pro。

为什么模型拟人化很重要?

除了这些模型改进之外,OpenAI 还让自定义 ChatGPT 的语气和风格变得更加容易。用户对 ChatGPT 的回复方式有着强烈且多样的偏好,因此,根据个人喜好调整其语气应该是一件毫不费力的事情。

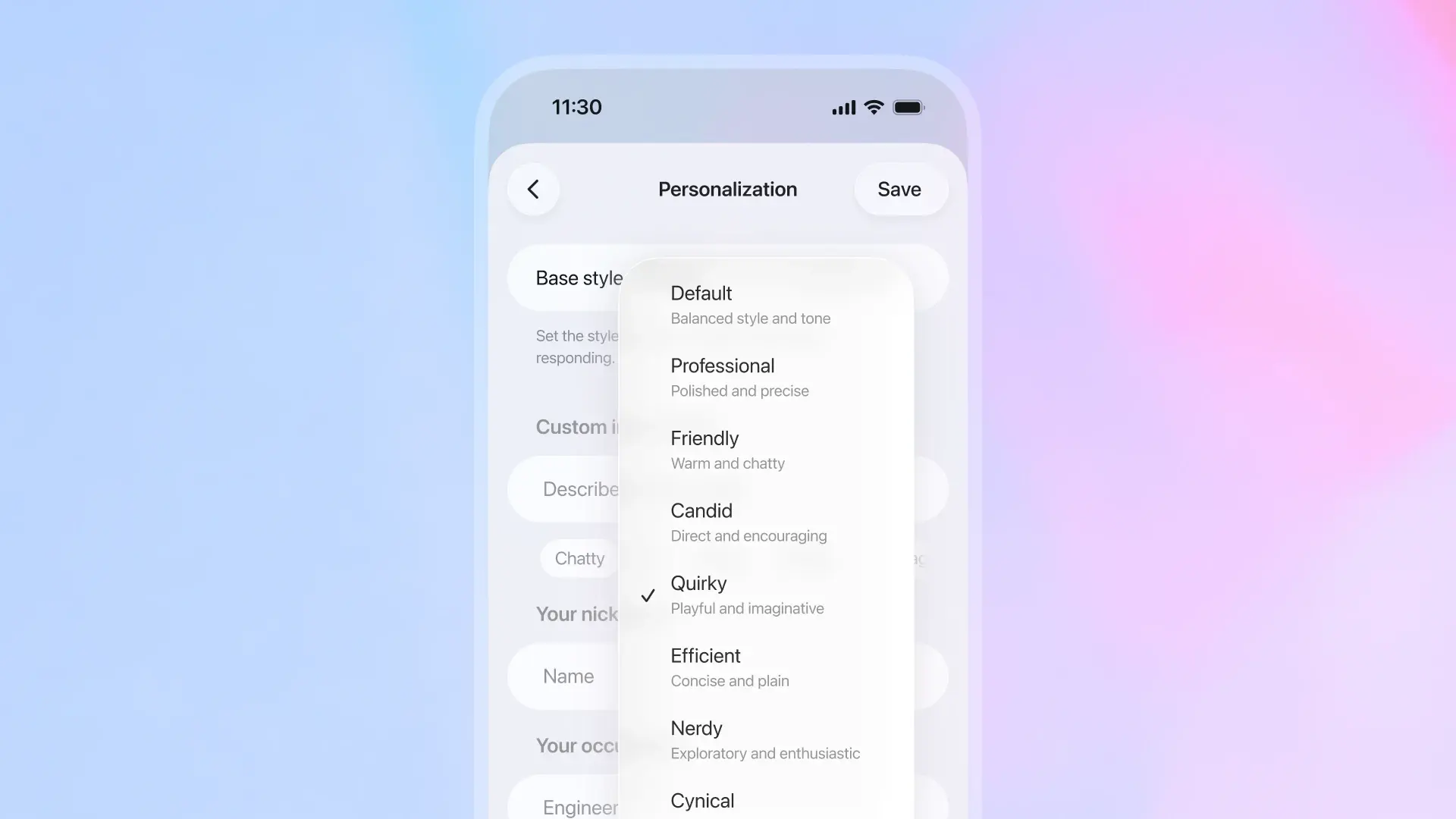

今年早些时候,研发团队添加了预设选项,方便用户自定义 ChatGPT 的回复语气。如今,OpenAI 对这些选项进行了优化,使其更好地反映用户使用 ChatGPT 的常见方式。“默认”、“友好”(原“倾听者”)和“高效”(原“机器人”)选项将保留(并进行更新),同时新增了“专业”、“坦诚”和“古怪”选项。这些选项的设计理念源于他们对用户如何自然引导 ChatGPT 的了解,旨在让用户能够快速、直观地选择最适合自己的个性。

这些性格设置适用于所有模型。OpenAI 强调今年早些时候推出的“愤世嫉俗”(原名“愤世嫉俗者”)和“书呆子” (原名“书呆子”)选项将继续保留,并位于个性化设置的同一下拉菜单中。

除了这些预设选项之外,对于希望更精细地控制 ChatGPT 回复方式的用户,OpenAI 也在尝试允许用户直接在个性化设置中调整 ChatGPT 的各项特性,包括回复的简洁程度、亲切程度、易读性以及表情符号的使用频率。

事实上,不只是 OpenAI 在追求模型的拟人化,其他科技巨头也开始有意地强调模型的拟人化。

Anthropic 在其官网中明确指出,他们对 Claude 的 “character (性格)”进行了训练:目标是让 Claude 具备好奇、开明、反思的特质。 例如,他们指出,Claude 会说:“我喜欢尝试从多角度看问题,但我也敢表达我认为伦理上不当或事实上错误的观点。”

在媒体访谈中,Anthropic 研究员就把 Claude 比作“一个受欢迎的旅行者(well-liked traveller)”,可以适应当地习俗、善于聆听、但并非一味讨好。这种拟人化即体现在:模型不仅要“给答案”,更要“以某种语气”“以某种态度”与人对话。

Anthropic 的研究中还提到“persona vectors(人格向量)”这个概念:模型内部的某些激活或表示会与“性格”“语气”“态度”相关。通过操控这些,可以控制模型偏向“乐观”“抱歉”“怀疑”等语气。 虽然这不是一个最终产品的“人格选择器”,但从研究视角看也说明,模型“拟人化”的背后有技术机制:不是简单堆参数,而是让模型“能表现出”某些人类-风格的语气/角色。

那么,为什么让大模型更“温暖”,很重要?业内分析人士表示:

“让模型更人性化、更温暖,本质上是大模型企业在追求更高层次用户体验和更广泛应用场景的结果。首先,从用户体验与黏性的角度看,当用户与模型的互动更像与‘人’交流时,会感到自然、舒适,也更容易建立信任。相比冷冰冰的机械式回复,一个语气柔和、有情感色彩、能对人类情绪作出回应的系统,更能让人产生亲近感与依赖感。

正如 OpenAI 在 GPT-5.1 的说明中所强调的,‘好的 AI 不仅要聪明,还要愉快地交谈’,用户体验的改善意味着更高的使用频率与品牌认同,这在商业层面具有显著优势。其次,从应用场景的扩展来看,随着模型能力的提升(如 GPT-5 在写作、代码生成、视觉理解等方面的进步),AI 已从传统的问答工具转向聊天式辅导和情感支持、虚拟伙伴等更具互动性的方向。在这些需要情绪共鸣和语气细腻度的场景中,冰冷的机器感会成为障碍,而拟人化表达能让模型更好地融入对话。最后,从大众化普及的角度出发,拟人化还能有效降低技术的心理与认知门槛。对模型厂商而言,这不仅能扩大用户基础,也有助于让 AI 真正走进日常生活。”

网友狂吐槽:不实用,谁会和模型做朋友

OpenAI 推出 GPT-5.1 后迅速在 X、Hacker News 上引发热议,多数声音对“强化个性”的方向提出质疑。网友表示:我们要高效工具而非“虚拟朋友”。

在 Hacker News 上,一位名为 url00 的用户直言,他并不希望 GPT 变得更像人,而是想要“完全相反的方向”——一个像《星际迷航》里 LCARS 系统那样高效、冷静的工具。“我不想和它聊天,我想用它工作。”他说,并表示自己作为订阅用户,对这次变化“相当失望”。

有网友直接质疑核心需求匹配问题,SocialJerm 表示:“要求输出的‘个性’与输入内容相匹配,这过分吗?”

更多网友将矛头指向功能定位,verge_user_m5in44gm 直言,AI 公司从用户被 AI 社交模拟误导的诸多案例中得出了错误结论,“看到这类公告就想到,我们终于造出了经典科幻小说《别创造折磨枢纽》里的‘折磨枢纽’”。他吐槽:

“只有深陷其中失去判断力的人,才会将'更好地模拟用户值得信赖、能提供情感支持的朋友'列为季度核心产品目标,我想要的是《星际迷航:下一代》里的企业号 D 型计算机——冷静、简洁、实用、不添乱,没有特定提示就不会凭空构想或猜测,本质是带自动化宏功能的图书管理员,最好是马杰尔·巴雷特·罗登伯里配音,而不是虚假的朋友”。

有用户直言,“别再骗人说屏幕对面是真人打字了。LLM 应该是极其有用的生产力工具,而不是情感支持。”

用户 gnat 则抱怨模型过于频繁地自我提示人格设定,他称:

“每次回应都像在表演:‘好的,我会保持简洁专业。是的,七宗罪只有七个。’——这更像是在展示它理解了指令,而不是在真正回答问题。”

网友 sheepscreek 甚至为这一现象下了定义:“提示表演:语言模型过度展示或夸大自己对指令或人设的遵从,以证明它在‘努力扮演角色’,而非直接给出所需答案。”

还有用户担忧个性功能影响使用体验,Cixtpide 表示自己订阅服务只为中性、全面且直截了当的 Thinking 模型,对添加“个性”感到失望,“希望能通过自定义指令降低个性浓度”。他还提到,此前使用个性化功能时曾出现输出语言与提问语言不一致的情况,计划尝试“高效”设置,期待其有所改进。

还有用户表示模型一味地谄媚并不是好现象。并称自己注意到有人将哪些大模型最擅长反驳用户进行了简单的对比,结果显示结果 Kimi 在反驳用户方面做得更好。

“这正是我喜欢 Kimi K2(思考模式)的原因。根据我的使用体验,它对任何并非显而易见的观点或陈述都会提出非常有力的质疑,而且不会轻易放弃。它会不断地追问、修正、完善自己的论点;如果你改变立场或接受了它的批评,它还会再次重申自己的观点。这样的特性让它非常适合用来辩论或打磨文章思路。尽管它几乎从不会完全认同你的看法,有时会让人觉得有点不解风情,但这没什么问题——毕竟它不是人。只是我的社交本能偶尔会忘记这一点,希望它能像真人一样点头同意。甚至还有人做过一个简单的比较,分析哪些大模型最擅长反驳用户,结果 Kimi 名列前茅。”

参考链接:

https://eqbench.com/spiral-bench.html