随着 1.0 版本的发布,Dev Proxy达到了一个重要的里程碑,引入了一系列旨在帮助开发人员构建更可靠的 AI 应用程序的新功能。正如公告中所报道的那样,这次更新的重点是对语言模型行为的逼真模拟、高级资源跟踪和集成工具的改进。

这标志着这是 Dev Proxy 的第一个主要版本,该团队将其描述为:

我们很高兴地宣布 Dev Proxy 的第一个主要版本!在过去的几年里,我们发布了一些功能,我们相信这些功能可以帮助开发者构建更健壮的应用。在最近的重构之后,我们已经为我们未来的工作打下了坚实的基础。也就是说,我们一直在改进我们的代码库,并对任何更改持开放态度。接下来,我们将使用 SemVer 来传达每个版本中更改的范围。我们将继续定期发布版本,并且如果我们发布了一些突破性的更改,我们将清楚地传达更改的内容及其影响。

其中最值得注意的新增功能之一是LanguageModelFailurePlugin,它使开发人员能够测试他们的应用程序如何响应不可预测的 AI 输出。据其描述,该插件可以模拟 15 种常见的失败类型,包括幻觉、偏见、误解、矛盾的陈述和模棱两可的回应。需要注意的是,开发人员还可以定义自定义故障场景,确保他们的系统在处理不可靠的 AI 生成内容时具有鲁棒性。

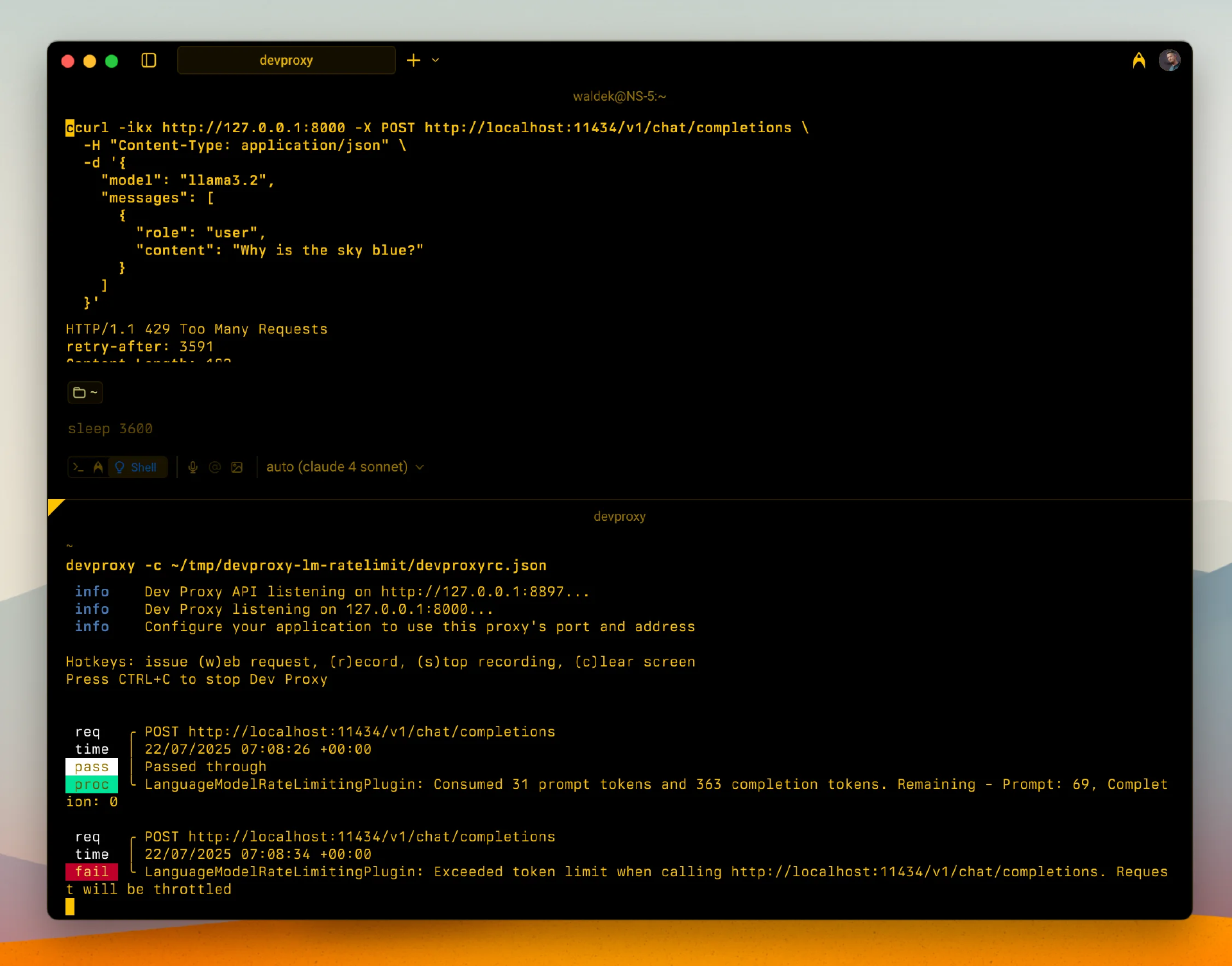

另一个关键的增强是LanguageModelRateLimitingPlugin,它引入了基于 Token 的速率限制模拟。该特性反映了大语言模型提供者如何通过在可配置的时间范围内允许输入和输出 Token 的不同阈值来强制执行限制。根据开发团队的说法,该功能有助于模拟 AI 集成的实际性能边界和预算约束。

(模拟超过 LLM 请求的 Token 限制,来源:微软官方公告)

OpenAITelemetryPlugin也得到了改进,现在支持从流式响应中跟踪 Token 使用情况。该插件可以以 Markdown、JSON 或纯文本格式生成详细的成本和使用摘要,使开发人员能够更好地监控测试活动并预测生产成本。

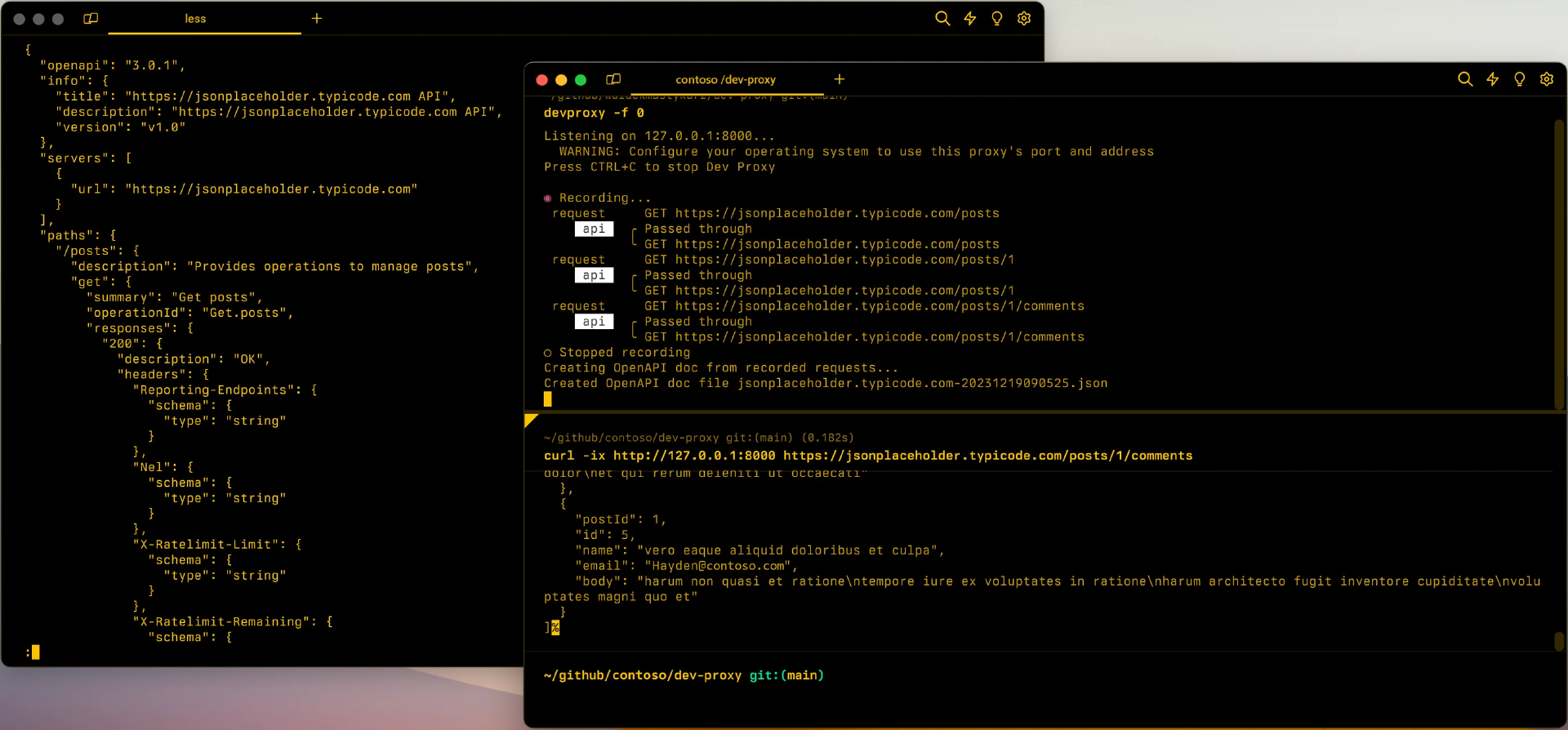

OpenAPI 规范生成已经通过更新OpenApiSpecGeneratorPlugin进行了改进。这些增强包括排除响应类型的能力——对于忽略此类元数据的 AI 智能体特别有用——以及捕获默认参数值的能力,从而提高了 AI 工具使用自动化 API 的准确性。

(从截获的请求和响应中生成 JSON 格式的 OpenAPI 规范,来源:微软文档)

除了主应用程序之外,还更新了几个 Dev Proxy 工具。 Dev Proxy Toolkit是一个 Visual Studio Code 扩展,现在支持 v1.0.0 架构,包括语言模型插件的新配置片段,添加了对诊断的 JSONC 支持,并提供了设置基本配置标志的快速操作。

Visual Studio Code Tasks集成已经增强,可以在调试会话期间自动启动和停止 Dev Proxy。GitHub Actions集成已经被简化,以使 CI/CD 工作流程更容易,.NET Aspire扩展已经更新以支持.NET 8。

该版本还提供了一个改进的Dev Proxy MCP Server,它为编码智能体提供了直接访问更新的文档、模式和构建配置的最佳实践指南。根据该团队的说法,在使用 AI 辅助配置编辑时,这些添加的功能已经带来了更好的结果。

其他变更包括 Chrome DevTools 中增强的流式响应处理,通过自定义 OIDC 元数据 URL 扩展的身份验证兼容性,简化的 Linux 安装默认值,改进的配置验证以及更具弹性的错误处理。

对于感兴趣的读者,可以在官方公告中获得包含完整的功能列表、改进和缺陷修复列表的完整发布说明。

原文链接: