本文要点

- Launchbury 将统计学习归类为他称为的第二次 AI 浪潮。在这次浪潮中,强调的是感知和学习的过程,但是这项技术却缺少推理和抽象的能力。

- AI 的核心是一个高度有序的结构。在实践中,大部分 AI 实例是由无数的松散的实现和算法结合而成的,并且它们通常会跨越多个领域。

- 潜存在机器学习底层的大量算法也带来了巨大的信任问题,尤其对于那些软件测试人员来说。

- 由于在 AI 训练的过程中需要广泛的数据来进行训练,测试机器学习就变得更加复杂了。

- 如果盲目倾向于信任那些还未被大规模信任的技术,可能会导致被误导,甚至会产生一些有危险性的结论。

最近有关时下流行的人工智能(AI)的言论正不绝于耳。AI 充斥着我们的日常生活,从 Google 搜索到 Uber、Lyft 打车、再到航班定价、以及 Alexa 和 Siri 等众多应用中都有它的身影。对于一部分人来说,人工智能确实解决了他们的困难,它大大提高了人们的生活质量,同时也为各行各业创造了大量产业上的革新。然而,另一部分人则提出可怕的警告说,我们很快就会完全被卓越的机器智能所征服。AI 中通常,但也并非一定,由软件主导控制,然而软件很容易出现漏洞。鉴于这点,我们该如何确定 AI 本身是否足够可靠以完成其任务,或简单来说,我们可以有多信任 AI 所产生的结果?

信任错位的风险

就自动驾驶而言,AI 被应用于众多萌发的自动驾驶系统中。这样可以使车辆遵守交通规则,当然算法首先自身得遵守。在佛罗里达州,有一个案例,一辆自动驾驶的汽车侧面撞击了一侧的卡车,造成驾驶座上“司机”的死亡。该起事故最终归因于驾驶员的失误,因为自动驾驶仍被认为是其驾驶座上司机的操作。当时的回避系统在设计上需要雷达和视觉系统在达成一致后才采取回避行为。然而有证据表明,视觉系统遇到来自白色卡车反射阳光所产生的眩光,该系统既未察觉也没有对即将出现的危险作出回应。然而,重要的是,有其他证据表明,当时“司机”正在观看 _ 哈利波特 _ 电影。驾驶员显然过度信任了自动驾驶系统,尽管估计在碰撞前有七秒钟的反映时间 1,但他并没有主动监控自动驾驶行为,也没有对其进行操控,酿成了悲剧。在设计保证书上已明确在使用自动驾驶时仍然需要司机全身心的关注,但司机未能履行。在这起少数案例中,对基于 AI 的系统的信任错位产生了致命的后果。

建立信任区间

AI 的进步着实令人印象深刻。DARPA 是早期成功举办了自动驾驶竞赛的赞助商,其于 2016 年底举办了信息技术大挑战赛(CGC)。CGC 建立了一个独立的机器,可以进行一个被称为“抢旗帜”的黑客实时游戏。在游戏的代码中,隐藏着一个“旗帜”,黑客的任务就是利用漏洞来找到并获取对方的旗帜。CGC 向获胜的团队提供了 200 万美元的奖金。在最终的 CGC 比赛轮次中,在一个普通的封闭式网络上相对放着七对机器。在没有人工干预的情况下,这些机器需要识别对方系统中的漏洞,并在自己的系统上修复它们,再利用这些漏洞来攻破对方系统抢到旗帜。最终,来自卡内基梅隆大学的队伍 Mayhem 赢得了比赛的胜利 2。

DARPA 的信息创新办公室主任 John Launchbury 将与 CGC 类似的 AI 类型称为 _ 手工知识 _。它们是从早期的专家系统发展而来,这种技术对于现代 AI 的发展仍然至关重要。在这些手工知识中,系统的决策是基于精心设计、手动定义的规则集而来的。这种类型的人工智能善于推理,但在感知上是有局限性的。况且,它不具备学习或抽象的能力 3。

虽然我们越来越相信,在未来,推理 AI 可以快速诊断和修复软件漏洞。但需要注意的是在 CGC 比赛中,范围是有意被限制了的,而放到开源操作系统层面这就会被简化为互相之间的竞争 4,已知的恶意软件会被植入真实的注水版本中 5。这可以减轻开发的负担,对竞争评估产生统一的基础。无需重大修改,就可以限制竞争对手把软件发布到更大范围的网络中。

使用这类“肮脏的技巧”来在竞争中打败对手增加了行业中一个新的阴暗面。虽然其重新编写代码以快速隔离并修复漏洞的能力非常好,但将这些漏洞转化为用于攻击他人代码的行为就另当别论了。有人担心,如果这样的能力被释放并失去控制,它就可能成为一种“超级代码”,这样可以避免常见的漏洞,同时能够利用相同的漏洞来控制他人的网络,影响面还会包括正蓬勃增长但可能较为脆弱的物联网(IoT)。这一担忧促使电子前线基金会(Electronic Frontier Foundation)在 AI 开发者中呼吁采用“道德准则”来限制推理系统以可靠的方式来运行 4。

机器学习引发信任博弈

Launchbury 将 _ 统计学习(statistical learning)_ 归类为他称为的第二次 AI 浪潮。在这次浪潮中,强调的是感知和学习的过程,但是这项技术缺少推理和抽象化的能力。令人印象深刻的是,根据统计数据,机器学习时常产生不可靠的结果,通常表现为奇怪的异常值。机器学习模型也可能随着时间的推移受到污染的训练数据的影响而产生扭曲 3。鉴于并不是所有的 AI 学习都能产生可预测的结果,这就导致 AI 系统可能以意想不到的方式出现问题。有效地定义基于 AI 的工具的可信水平成为一个巨大难题 6。

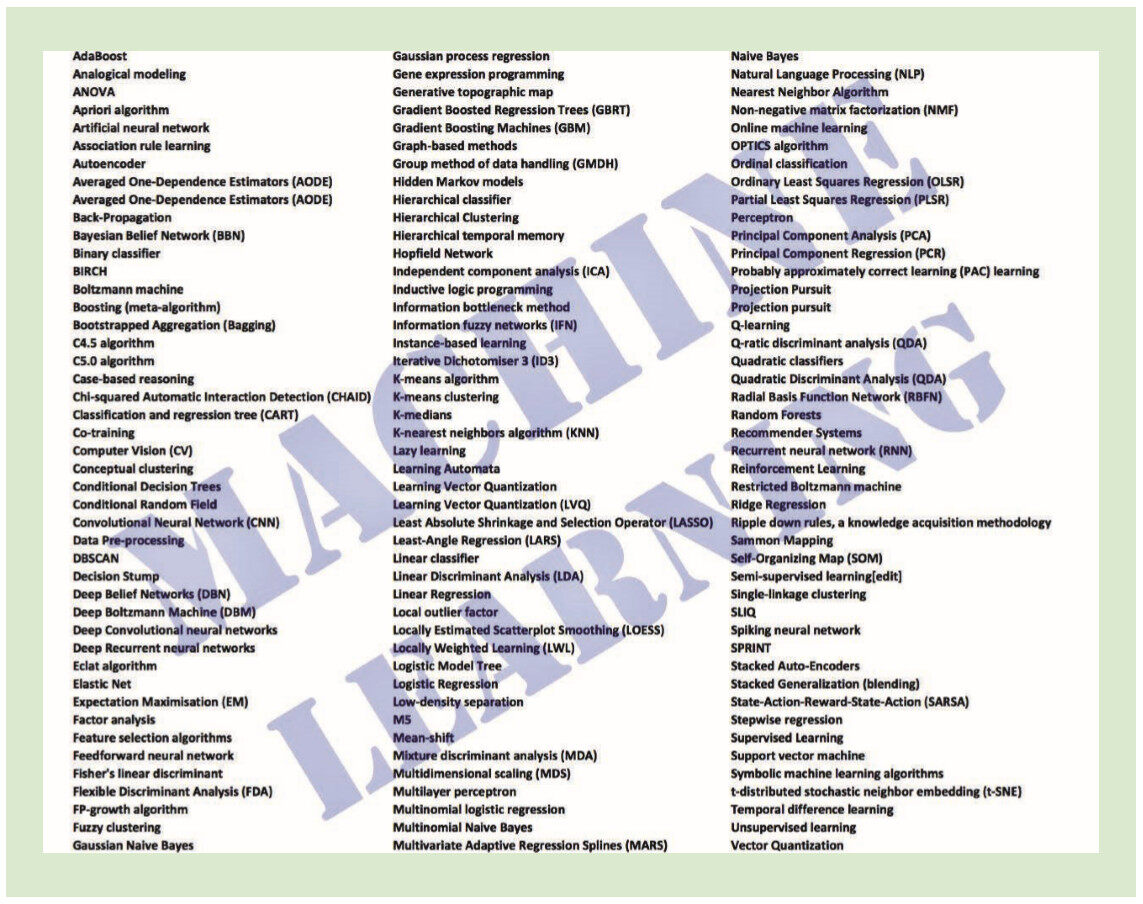

AI 的核心是一个高度有序的结构。在实践中,大部分 AI 实例是由无数的松散的实现和算法结合而成的,并且它们通常会跨越多个领域。事实上,AI 远远超出了计算机科学的范围,它包括神经科学、语言学、数学、统计学、物理学、心理学、生理学、网络科学、伦理学等诸多领域。在图 1 中列出了一个不太完全的算法列表,这些算法是第二次 AI 浪潮的基础,通常统称它们为机器学习。

图 1:一些流行的 AI 机器学习算法

潜存在机器学习底层的大量算法也带来了巨大的信任问题,尤其对于确保程序可信的软件测试人员来说。当 AI 与任务关键性相关联时,案例越多,测试人员必须基于多个因素来建立测试的基础,如程序一致性、可重复性、透彻性、被使用的路径跟踪或可识别的系统故障模式等。

找到最为合适的 AI 算法这一重要问题最早可追溯到 1976 年 3。日常的 AI 从业者面临着这一令人困惑的问题,即使用哪种算法来应对所需的 AI 设计。假定一个预期的结果,哪种算法最为精确?哪个最高效?在预期的环境中哪种实现最为直接?随着时间的推移,哪个崩溃的可能性最小?哪些是最熟悉的,也最有可能被使用的?系统设计是否基于某种形式的中心节点、分布式代理、甚至软件代理商?所有这些能怎样被测试?

这些问题表明,在广泛可被替代的 AI 相关算法和技术的选择上,需要在设计上做出一定的权衡。事实上,AI 的这种可替代性的存在本身就表明,大多数 AI 架构远非一致及内聚的。更糟糕的是,推理和学习系统需要高度的基于上下文的定制。这当然会扩展到 AI 的测试阶段,因为每个算法和它的定制实现都带来了自己独特的深层次测试挑战,即便是在单元测试层面也是如此。

一个上层的 AI 测试能评估正确图像识别和分类的能力。在某些情况下,这种测试已经超越了人类进行此类判断的能力。例如,Wild(LFW)数据集中的标记面部数据有大约 13,000 张图像,可用于进行面部识别,通过使用神经网络或深度学习来训练和校准识别面部的机器学习工具。新的自动 AI 图像识别工具可以通过使用该数据集在整体上胜过人类的脸部识别能力 7。然而,该任务本质上就是感性的。这些任务通过数学相关的几何模式进行区分,但是没有任何形式的高阶认知推理。此外,虽然将其选择性识别的准确性与人类的能力进行比较,但在测试中,底层代码库的其他任务的关键点并未被检查。

代码之外

图 2:信息的来源可能往往不是明确的

其他信任相关的因素更远远超出了代码的范围。编码是一种创造性的行为,同时也是有语法规范的,所以它需要进行一定程度的解释过程。编码者可能会有意无意地将文化或个人偏见注入到最终的 AI 代码中。想象一个编码人员创建了一个高度精确的面部识别程序,但在识别过程中没有考虑皮肤色素沉着因素。这种行为可能会产生和对肤色有增强处理的算法不一样的结果。相反,罪犯的重复犯罪率则会使一些基于 AI 的监狱释放判决在种族上产生偏见。这就意味着某些罪犯比其他人更有可能获得提前释放的机会,而无关其日常表现 9。语义的不一致性可能更进一步危及 AI 代码的中立性,特别是在涉及到自然语言处理或习惯用语识别的情况下更是如此。

有人提出如今所有的 IT 职业都是网络安全相关职业 10。这也对 AI 的开发及其实现领域产生了巨大的影响。从网络安全的角度来看,“谁知道机器知道什么,以及机器是何时知道这些的”这个问题变得很重要。机器学到的东西通常不容易被看到,这是深藏在其编码中的。这不仅影响到新的内部化的数据,而且在 IoT 中,这些数据可以跳过决策触发器,并激活执行器来转化“学习”的结果成为某个实际行为。缺乏了具体的标识和准确性,所有基于 AI 的物联网刺激反馈机制就变得同样不可确定。无论如何,在关键任务系统中所产生的操作都需要进行严格的校验。

第三次浪潮

Launchbury 预见到我们需要一个尚未完成的 AI 第三次浪潮,并称其为 _ 语境适应 _。这项技术需要更多的工作,将感知、学习和推理的优势融合在一起,并支持极高水准跨领域的抽象 3。

于 2017 年 5 月结束的 2017 本体(Ontology)峰会巧妙地将主题命名为“AI、学习、推理和本体论”。峰会公报草案得出结论认为,迄今为止,大多数人工智能的方法,包括机器学习工具,都是以次级象征(subsymbolic)方式来运行的,使用的是与人类思维大相径庭的运算技术,这印证了 Launchbury 的观点。虽然许多形式的人工智能都取得了很大的进展,但从象征层面充分表现知识还尚未成熟。相应地,本体论作为一种正规的语义组织工具的作用仅仅在对 AI 及其最终测试环境上具有有限的优势。

语义网络包含以节点和连接来表示知识的图。它提供了一种表示符号之间关系的可理解和可视化的方式,通常使用多义词来表示,即在不同上下文中传达不同的含义。今天大部分的 AI 都是以次级象征的形式存在的,将来需要处理更为真正意义上的应用语义来实现第三次浪潮。在这种情况下,AI 将变为非线性的,其中因果关系通过多个执行线程逐渐解耦。这需要建立 _ 复杂的自适应系统 _(CAS),它会持续受非线性网络行为的影响。

在 CAS 中,随着时间的推移,基于环境的状况会出现新的行为。其内部可以有多个自行组织的路径产生成功或失败的结果,这些路径都是由高度多样化的节点和连接触发的,这些节点和连接可以随着时间的推移而增加、变化或缩小。在与数据相关的嵌入式软件结合使用时,这样的网络会对传统的递归式单元测试产生冲击。这是因为在 CAS 中,整体往往远不单单是各部分的加和 11。相应地,应用网络科学中提供了一些较好的方法来评估那些随着时间的推移出现的动态 AI 行为。通过图论和时间维度来描述没有按线性路径达到预期效果的动态行为也更容易被理解 12。

在采用一些可靠的方法来评估 AI 可信度之前,我们必须保持谨慎。如果盲目倾向于信任那些还未被大规模信任的技术,可能会导致被误导,甚至还会产生危险的结论。

引用

- N.E. Boudette, “Tesla’s Self-Driving System Cleared in Deadly Crash”, New York Times, 19 Jan. 2017.

- D. Coldewey, “ Carnegie Mellon’s Mayhem AI Takes Home $2 Million from DARPA’s Cyber Grand Challenge ”, TechCrunch, 5 Aug. 2016;

- J. Launchbury, “ A DARPA Perspective on Artificial Intelligence ”, DARPAtv, 15 Feb. 2017;

- N. Cardozo, P. Eckersley, and J. Gillula, “ Does DARPA’s Cyber Grand Challenge Need a Safety Protocol? ” Electronic Frontier Foundation, 4 Aug. 2016;

- A. Nordrum, “ Autonomous Security Bots Seek and Destroy Software Bugs in DARPA Cyber Grand Challenge ”, IEEE Spectrum, Aug. 2016;

- S. Jontz, “ Cyber Network, Heal Thyself ”, Signal, 1 Apr. 2017;

- A. Jacob, “ Forget the Turing Test-There Are Better Ways of Judging AI ”, New Scientist, 21 Sept. 2015;

- J. Demsar, “Statistical Comparisons of Classifiers over Multiple Data Sets”, J. Machine Learning Research, vol. 7, 2006, pp. 1-30.

- H. Reese, “ Bias in Machine Learning, and How to Stop It ”, TechRepublic, 18 Nov. 2016;

- C. Mims, “ All IT Jobs Are Cybersecurity Jobs Now ”, Wall Street J., 17 May 2017;

- P. Erdi, Complexity Explained, SpringerVerlag, 2008.

- N. Masuda and R. Lambiotte, A Guide to Temporal Networks, World Scientific Publishing, 2016.

关于作者

George Hurlburt 是非营利组织 STEMCorp 的首席科学家,该组织致力于通过应用网络科学进一步推动经济发展,并将自动化技术推广为对人类有用的工具。Hurlburt 从事基于动态图像的物联网架构。他是 IT Professional 编辑委员会成员,同时是南马里兰州高等教育中心的董事会成员。可以通过点击这里和他进行联系。

本文首次刊登于《IEEE IT Professional》杂志。《IEEE IT Professional》提供了针对当今战略性技术问题的稳固且经同行评议过的信息,用以应对运营可靠、灵活的企业所带来的挑战。IT 经理和技术主管可通过该杂志来获得最先进的解决方案。

评论