如果说 2021 年科技圈最火的概念是“元宇宙”,那么 2022 年最火的一定是 Web3.0 了。目前看来,较早定义 Web3.0 概念的,是区块链研究员 Eshita。

Web1.0:可读 Read

Web2.0:可读+可写 Read+Write

Web3.0:可读+可写+拥有 Read+Write+Own

不过,从直观感觉上来讲,这个划分可能不太准确。毕竟在 2004 年之前就有大量的 BBS、社区和论坛,还有 QQ 这样的社交软件,可以做到信息的读和写,读和写应该并不是 Web1.0 和 Web2.0 的本质区别。今天的头条新闻和当年的门户网站看起来都是信息分发,但它们无论是从技术还是业务逻辑上都有本质的区别。

Web3.0 的“Own”不代表价值。资产,从定义上来讲,就是透过交易或非交易事项,能以货币衡量,能够为个人或企业带来收益的东西。如果不能变现,不能流通,不能带来现金流,所有权也没有价值,一栋坐落于衰退地区的每年需要缴纳大额房产税的房产可能是个负资产。

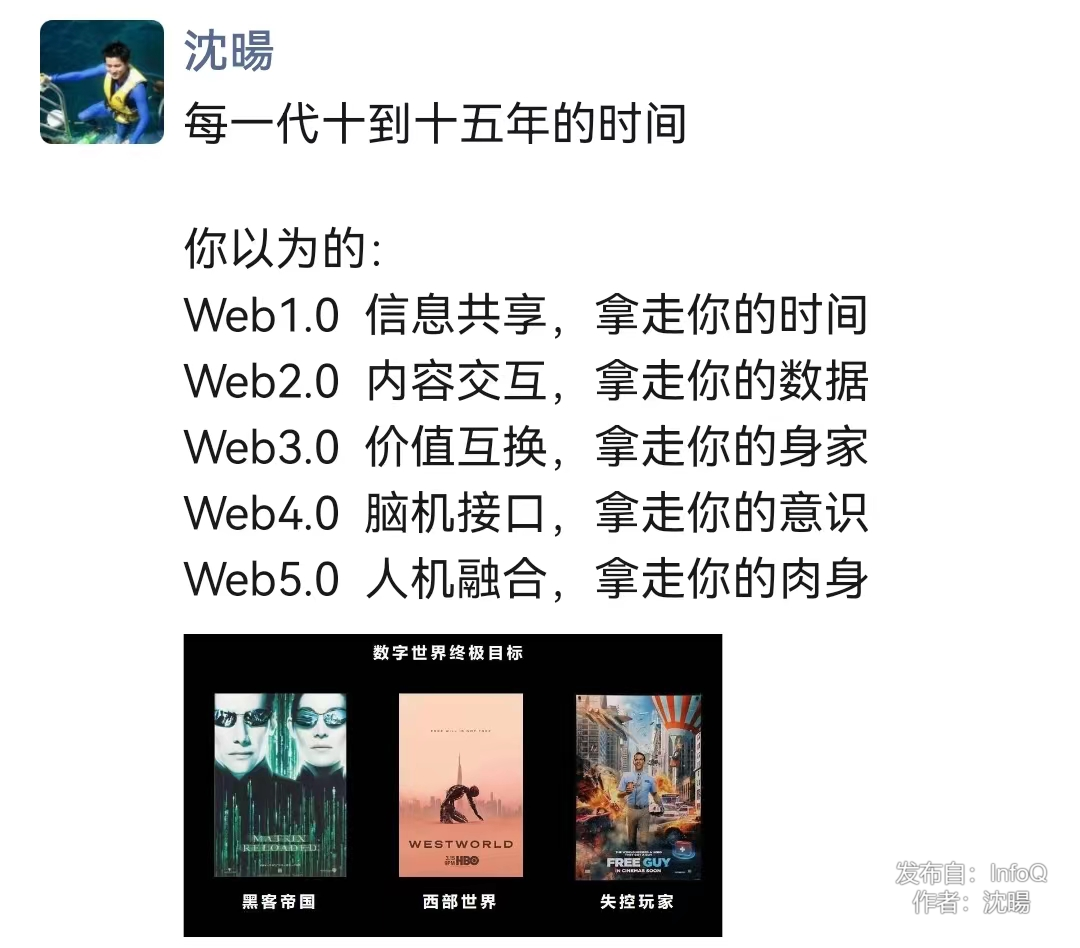

前段日子在朋友圈看到关于 Web1.0 到 Web3.0 的一个调侃,觉得还有点意思,于是结合自己过去的一些经历,再开了一下脑洞,补充了一下对 Web4.0 和 Web5.0 的想象。之后有不少朋友对这个段子感兴趣,于是花时间写下这篇文章,使得段子变得有逻辑,这样也能让自己信服未来是美好的,值得努力再奋斗几十年。

我这个调侃也结合了我自身的经历,我学过自动化和模式识别,研究过 1 年的脑机接口项目,然后从事了十多年的信息化、数字化和数据技术相关工作,折腾过一年的区块链和量子应用,在工作之余也对经济理论比较关注。

不卖关子,先给大家看一下 Web1.0 到 Web5.0 的推演过程,然后再详细展开每个阶段的故事。

从 Web1.0 到 Web5.0——关键时刻的预测

Web1.0

1993~2004 年,信息的共享和交互

标志性启动事件:Mosaic 浏览器的出现,是点燃因特网浪潮的火种之一。

变革原因和对 Web2.0 的影响:互联网产生了大量的数据,但是因为技术瓶颈无法盈利。

Web2.0

从 2004 年开始,数据价值深度挖掘,产生互联网巨头

标志性启动事件:谷歌在 2003 年后陆续发表关于 GFS、MapReduce 和 BigTable 的论文。

变革原因和对 Web3.0 的影响:智能数据的价值深度挖掘,互联网巨头开始盈利,并形成垄断,在智能手机带来 APP 数据隔阂,用户需要更开放和公平的互联网。互联网平台已经深度数字化,孵化了各种大数据和云计算的技术底座。

Web3.0

从 2018 年开始,数字化的普及和对等价值交换

标志性启动事件:《通用数据保护条例》(GDPR)的发布。

变革原因和对 Web4.0 的影响:数据平权和对等价值交换,打破 APP 的隔阂和互联网平台的垄断,个人和组织的深度数字化,积累可以孵化 AI 的完备数据画像,量变引起质变。

Web4.0

预计从 2030 年开始,意识的交互

标志性启动事件:面向个人的完备 AI 助理,通过熟人的“图灵测试”。

变革原因和对 Web5.0 的影响:对人类大脑和行为的深度模拟,完成 Web5.0 需要的智能基础,人机融合可以进一步解放生产力。

Web5.0

预计从 2045 年开始,意识的互联,人机融合

预测标志性启动事件:人机融合的图灵测试。

Web1.0:信息共享的时代

在 Web1.0 时代,诞生了门户网站、聊天软件、BBS、电商购物网站等互联网应用。这个时代最大的特点是联网和在线,任何线下的场景搬到线上就可以获得火热的关注。Web1.0 的兴起很重要的两个原因是个人计算机的普及和因特网的大众化。

由于互联网用户增多,产生了巨量的内容和数据,服务器的硬件成本和技术团队的人工成本急剧上升,互联网企业压力巨大。门户网站的盈利方式主要靠广告,但是一个网页的页面布局空间有限,容纳太多广告的话会影响用户的体验。如果不能产生个性化的广告和精准的推送,从多个客户赚取广告费用,那么互联网公司的营收就无法支撑庞大的基础架构和技术成本。Web1.0 时代的社交软件也很难把客户的各种数据保存在服务器端,因为数据的存储和处理成本过高。

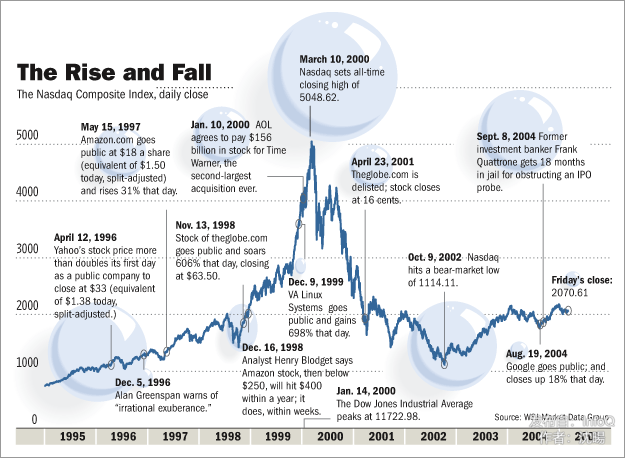

在 Web1.0 里,大多数互联网应用只能做到信息的发布、共享和交互,很少能做到更深层的价值挖掘。第一代互联网在盈利模式上始终是个难题,这个问题导致了第一次互联网泡沫的破裂。1994~2004 年,是第一个互联网浪潮兴起、泡沫和衰退的完整周期。

在 Web1.0 时代,虽然名头响的是互联网企业,但是在市值和盈利能力上还是那些企业信息化的 IT 巨头们更胜一筹,例如微软、思科、英特尔、IBM 等。互联网给数据技术带来的最大挑战就是数据量极大,但是单位数据的价值不高。企业的应用和业务流程数据往往是抽象和精炼的数据,如果把那些 IT 巨头面向的企业级信息化的数据和系统比作工厂在矿山里炼金,那么互联网的数据处理就像是在河里淘金,这两个场景需要的技术体系完全不同。互联网企业需要以极低的成本来收集、存储和处理数据,然后通过精准的广告体系来变现。

延展思考

在 Web1.0 时代,你每天花多少时间上网和线上社交?

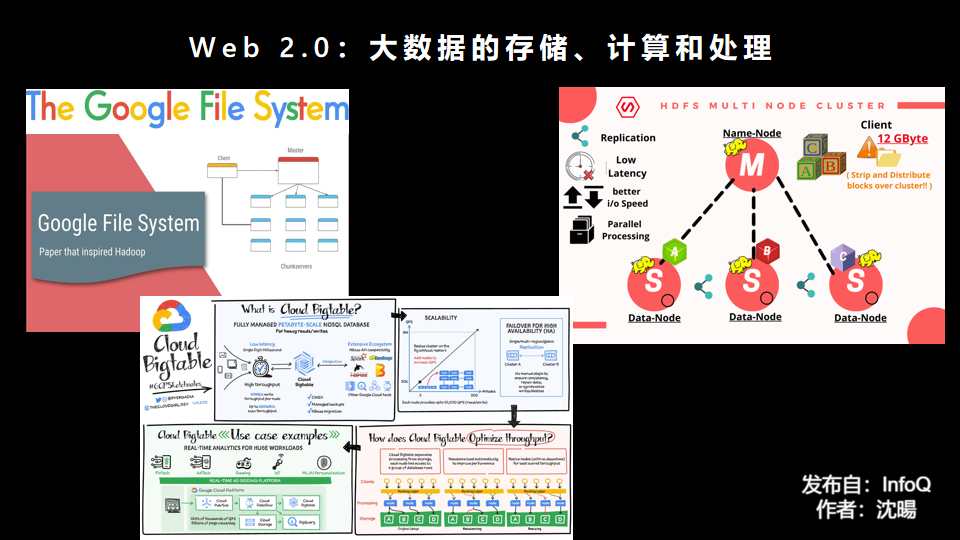

Web2.0:数据的大浪淘沙时代,诞生互联网巨头

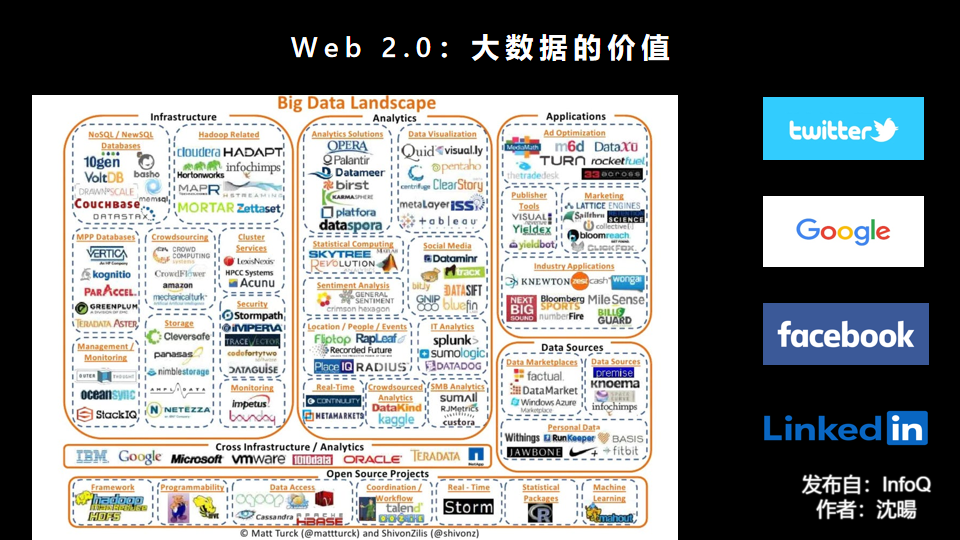

Web2.0 诞生的标志性事件应该就是谷歌在 2003 年后陆续发表了关于 GFS、MapReduce 和 BigTable 的论文,解决了数据存储、计算和处理的成本问题。谷歌通过内部自研,攻克了互联网领域的这三座大山。谷歌通过大数据的成本优势,很早就实现了盈利,并于 2004 年公开上市。

其他的互联网公司,有些用游戏、短信、甚至一些擦边球的业务利润继续补贴互联网业务,熬过了没有大数据技术的艰难时光。后来各互联网公司通过开源和合作的方式逐渐把谷歌的理论工程化,形成了后来的大数据技术和生态体系,成为互联网业务的基石。

Web2.0 时代是数据、计算和产品的工业化时代,互联网平台处理数据的成本越低、效率越高,其垄断地位就会逐渐形成。过去十几年里,在搜索、社交、地理服务和信息发布等各个领域,出现了各种各样的互联网平台,这些巨头利用自身在数据上的技术和规模优势,不仅仅通过精准广告实现了数据的价值,也通过数据、流量和场景的结合对传统行业造成了巨大的挑战。一些传统行业公司甚至畏惧与互联网公司合作,因为担心自己积累了几十年的宝贵行业经验建立的护城河,被互联网企业通过数据和流量轻松攻破。

有了精准的数据,就可以形成巨大的流量;有了流量,就等于把控了线上的营销渠道。那些对制造、供应链、物流和渠道依赖性不高的产品,在垄断性的流量前基本没有还手之力。通过大数据和千人千面的精准建模,互联网巨头也开始渗透金融领域,通过金融的杠杆不断放大业务规模。

海量的个人隐私数据让一些互联网平台得以引导用户购买特定产品,使得用户对投放的内容和产品上瘾。它们利用大数据杀熟,同样的商品和服务,多次查看价格会出现变化,老客户的价格比新客户更高。它们只推荐能带来潜在商业利益的产品甚至假冒伪劣产品,而不是对用户最适合、最恰当的商品。

一些平台甚至可以利用数据,对个人的欲望、情绪乃至意识形态加以操控,指引用户阅读特定文章,为特定人投票或对特定群体产生特定的偏见。它们甚至可以成为特定政治势力的代理工具,影响国家大选。即使是大国总统,也可能被互联网平台禁言而失去自己的舆论阵地。

在 Web2.0,因为智能手机的兴起,从网页时代进入了 APP 时代,各种弊端表现得尤其明显。

Web2.0 时代一个不公平的现象,是广大用户贡献了互联网平台需要的数据,但是双方的地位并不对等。用户贡献了账户和数据,但是 Web2.0 的架构是站在互联网应用的视角来建设的。对于个人来说,其数据是存在一个个 APP 的服务器里。当互联网应用关闭的情况下,用户的博客、文章、好友列表和关系、聊天记录都将从互联网上消失,并且很难被个人用户在本地长期保存下来。

在基于 PC 网页浏览器的互联网时代,各个网站之间还能相互跳转,相互引用,互联网用户还能够方便地订阅不同平台的信息。在 APP 时代,一些平台美名其曰 ALL IN 移动端,大幅砍掉纯 Web 的内容和服务,不登录不让看商品目录,不下载 APP 就不让看全文。用户成了数据运营和流量转化的工具人,成了各个 APP 的笼中之物,却没有享受到互联网带来的开放透明。

在数据安全上,在“不登录不让使用”“不同意收集数据不让使用”等条款下,个人数据被过度采集。互联网平台在管理用户数据的时候,其管理政策和技术过程的披露不够公开透明,也发生过对内监管不严数据被过度使用、对外数据泄露的安全事故。

一些互联网平台被用户贴上了垄断、霸道、乱用算法的标签。凡此种种,都违背了互联网发展的初衷,互联网用户期待未来能有一些改变。

延展思考

在 Web2.0 时代,你清楚自己的数据被怎样使用么?

Web3.0:数字化的普及和对等价值交换

为了规范管理互联网平台的扩张和对数据的使用,欧洲颁布了《通用数据保护条例》(GDPR),中国也制定了数据安全法。GDPR 规定数据主体享有的七项数据权利分别是:访问权、更正权、删除权(“被遗忘权”)、限制处理权、可携带权、反对权,以及不受制于自动化决策的权利。

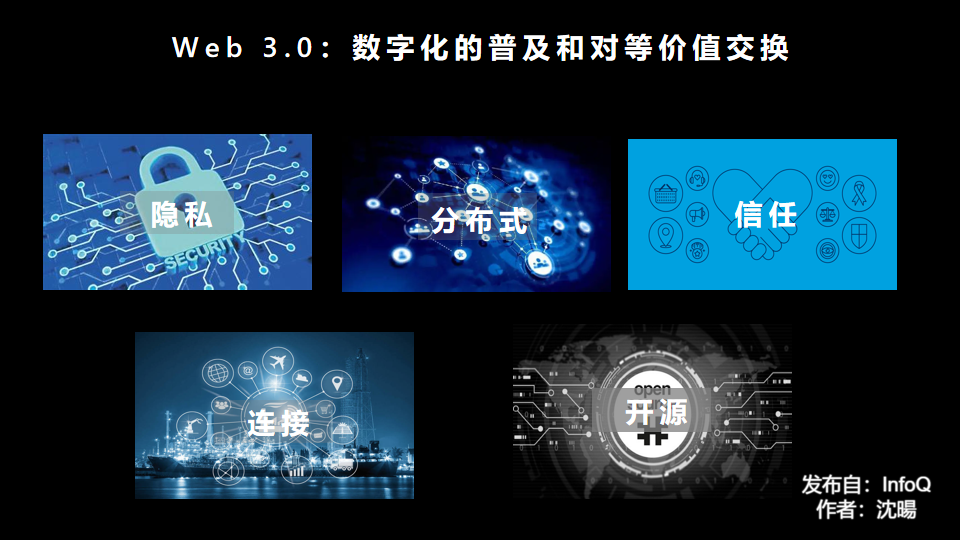

与此同时,在区块链的分布式和去中心化的哲学思潮的影响下,科技圈也希望用更透明、更公平、更开放、更去中心化和价值连接的方式实现一个全新的互联网。个体用户不仅仅在乎数据的权力,也在乎怎样在新的互联网架构体系下分享到价值,这就是 Web3.0 概念的产生。火爆的 ICO、加密货币、Defi、GameFi、NFT 等概念层出不穷,使得 Web3.0 的概念在媒体、投资圈、技术圈讨论火热。很多人认为 Web3.0 是下一代颠覆性的互联网架构,也有很多人认为 Web3.0 只是一个理念的炒作,很难真正落地,最终只会是一地鸡毛。

如果说,Web2.0 给用户带来的困扰是垄断、算法不透明和数据滥用,那么 Web3.0 就需要在分布式、隐私、开源、信任和连接上做到更好,让互联网用户能够真正分享到 Web3.0 的好处。在 Web2.0 时代,即使作品版权归用户,但由于流量完全控制在互联网平台,用户很难将自己的作品或者数据变现。所以对 Web3.0 的定义,信息对等的价值交换取代了“Own”的概念,如果资源不能带来预期的收益,用户的所有权无法体现价值。

与互联网巨头谈对等价值交换,除了法律保障,还得有实力和资源。这里有两种实现对等关系的途径。

第一个途径是把以前的互联网平台完全排除在外,通过对等的个体或者是通过限制个体的规模,建立一个独立的 Web3.0 的生态体系。类似比特币那样的区块链架构是非常完备的体系,对大多数个体也有公平清晰的规则,但是用这样的架构无法支撑 Web3.0 的海量用户和应用场景。

比特币的架构体系完美得让人感觉冷血,这个游戏好像是为机器人设计的。在比特币里最关键的两个因素是能源和算力,二者构成了机器世界的生存基本元素。想象一下,在一个完全是机器人的世界里,机器人依靠能源产生比特币,也可以用比特币来交换能源,获得更多能源和更优算力的机器人,可以轻松淘汰其他机器人。也许区块链大放异彩的时刻,要等到 Web5.0 时代吧。

如果不使用闭环的区块链架构,很多项目披着 Web3.0 的外衣,带有很强的迷惑性,使得大众难以辨别是非。关于一些乱象,可以参考这篇文章:《Web3.0里的各种乱象:谈谈StepN和NFT》。

第二个途径是加强普通企业和个人的数据管理、技术和价值交换的能力,参与原先的体系,与互联网平台共舞。借用区块链的哲学思想和技术体系,充分利用现有的技术和法律的保障来构建 Web3.0 可能更实际一些。到目前为止,GDPR 也只是一系列的法规,还没有具体的技术和产品跟法规一一对应,整个 Web3.0 的发展和落地应该会比大家想象的要更漫长。如果 Web3.0 的核心是数据平等和对等价值交换,数据平等是为了更好的和规模化的对等价值交换,那么可以围绕这两点来展开各种探索。

Web3.0 对个人的影响

大多数企业都已经完成了基础的数字化建设,通过各种系统很容易追溯到过往的记录。企业即使是用 SaaS 应用软件或者公有云,也会将数据留存在自己的管控范围内。但是对于个人来讲,大多数人除了照片、文档和各种笔记外,其他的数据都在哪里呢?个人的数字化,并不是一堆照片和文档的堆积,就像企业级的 ERP 应用也不只是一堆文件和数据的堆积。

例如个人用户的手机里有各种银行和理财的 APP,却很少有一个值得信赖的总账管家,来帮助自己管理各个账户里的交易和数据。虽然个人手机里有几十个 APP,有的 APP 记录了自己的跑步数据,有的 APP 记录了自己的睡眠数据,有的 APP 记录了自己的体重数据,但是当你想把这些数据汇总在一起做一个归因分析的时候,对于非技术人员来讲几乎不可能。

因业务调整,跑步软件 NRC APP 从 2022 年 7 月 8 日起停止中国大陆地区服务。虽然用户可以从 NRC APP 里导出自己需要的数据,但是裸数据对用户来讲并没有太大的价值,原始的经纬度的记录也需要应用才能被用户理解。当你换一个新的健身 APP 的时候,是否还能用以前的数据和记录?

HTTP 协议发明者蒂姆·伯纳斯-李(Tim Berners-Lee)在 1998 年提出一个语义网(Semantic Web)概念,它的核心是:通过给互联网上的文档(如: HTML 文档)添加能够被计算机理解的语义(元数据),从而使整个互联网成为一个通用的信息交换介质。但是在进入 APP 时代后,互联网平台并没有沿着这个开放的方向发展。

因为不满互联网平台对数据的垄断,Tim Lee 又做过一次尝试,在 2018 年发布了 Solid 的去中心化平台,这并不是一个区块链平台,https://solid.mit.edu/。Solid 的设计思路是每个人都可以拥有一个数据 POD,这个 POD 可以架设在自家的服务器上,也可以由第三方网站托管。当用户访问互联网应用的时候,数据留在个人的 Solid 的数据 POD 上,把互联网应用、平台数据和个人数据分开。Solid 只是第一步,个人数据保存在 POD 上,也还需要维持数据的一致性和整合。

当一个用户想把自己在互联网平台的文章迁移出去,可能会使用 beepress 或者 wxsync 这样的插件工具把文章同步到自己部署的开源 Wordpress 系统上。当用户想收藏整理自己在各种 APP 里阅读的内容,可能会用到 Cubox 这样的工具。Web2.0 时代 APP 造成的数据墙,使得个人数字化的难度加大了很多,在 Web1.0 时代很简单的浏览器收藏夹所实现的功能,现在却需要很多专业的工具才能完成。在 Web3.0 时代,应该会有更好的工具来帮助个人实现更深层次的数字化,这或许是个不错的机会点。

大多数成熟的企业都已经建立了数据平台。在 Web3.0 时代,个人也需要一个属于自己的数据管家,用来管理自己所有的数据存储、分析和交互方式。当 APP 需要调用数据的时候,由管家来决定哪些数据可以被调用,是否需 APP 来支付数据调用的成本;当 APP 产生数据的时候,需要把属于个人的数据也保存在个人数据管家里;当 APP 停止运营的时候,需要把个人的数据以方便读取的方式交给个人数据管家,用另一个开源或者免费的应用来接管这些数据;个人数据管家还可以对多个 APP 产生的数据进行关联分析;个人创作的作品,例如文章、视频等,也是第一时间保存在个人数据管家中,然后通过接口与各个内容分发的平台进行数据和价值的交换。随着时间的推移,各种关于个人的数据都将长期保管在个人数据管家之中,形成个人的虚拟印象,最终产生足够智能的 AI 数字人,数据积累对 AI 的孵化,是 Web4.0 发展的一个重要基础。

个人数据想要得到价值,必须通过服务或者产品来体现,在 Web3.0 时代,个人也需要将自己的能力打造成标准的产品,这样可以更好地进行对等交易。过去几年,无论是自媒体、公众号还是短视频,都有非常多的专家在将自己的价值产品化,逐渐形成清晰的个人画像。这点上,微信公众号的 Slogan 倒是挺符合 Web3.0 的价值观。

个人数字化的难点在于:个体的需求具体而清晰,但是每个人的个性和隐私需求可能不同,会不会出现好的工具体系来加速将每一个人数字化呢?

实现 Web3.0 需要打破 APP 之间的数据墙

打破互联网平台对数据的垄断也离不开手机厂商对个人隐私的保护。苹果公司首席执行官蒂姆·库克在接受《时代》杂志记者采访时称:关于我们所有人的信息比十年前或五年前更多,它无处不在,你正在到处留下数字足迹。

假设网络的速度足够快、延时足够低,也许云手机的生态可以加速个人数据管家的诞生。云手机方案可行的话,手机可以只留下电池、屏幕、摄像头、通信和加密解密的功能,计算、存储和应用都在云手机上。如果需要硬件升级,可以在后台实现一键升级扩容;如果 APP 需要升级,可以在虚拟的硬件环境里升级,而不用与复杂的硬件进行兼容测试。

现在的互联网架构中,有大量应用要用手机号码注册,而手机号码又直接对应个人最隐私的数据——身份证号码,一旦暴露,将给个人带来极大影响。而通过云手机里个人数字管家生成的虚拟身份与各种 APP 对接,可以在真实身份上加一层防护,实现数据更高级别的安全防护,避免隐私的泄露。

云手机也许还可以避免高端手机芯片的封锁,以弯道超车的方式实现一种新的架构体系。如果云手机的方案能落地,运营商就能从现在数据通道的地位翻身,转型为未来的数字化主战场了。由于云手机的技术对带宽和延时的要求很高,运营商的通信基站和边缘数据中心能够形成更好的组合,更能主宰云手机的市场。在运营商主导的云手机体系里,云手机之间的个人数字管家可以实现受监管的自组网,共享分布式数据和应用体系,用来对抗垄断的互联网平台。

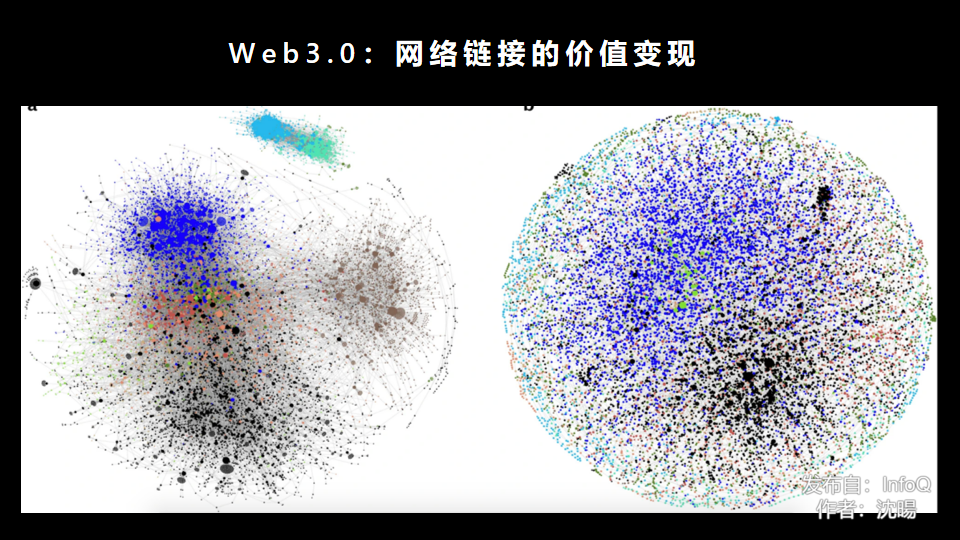

Web3.0 的网络链接价值

对 Web3.0 来讲,参与其中的个体和企业是对等的关系,在价值交换时需要经过复杂的网络链接,而不仅仅是通过单一的互联网平台。

例如,一个企业在做招聘的时候,可以通过带明确激励条件的小程序做传播,每个点击、传播和报名的用户都会通过信息加密记录下来。经过多次链路传播后,企业可以核对最终录取者的信息,并把激励发放给链路中间所有的贡献者。这样的小程序,虽然不是完备的区块链架构,但是如果企业能够长期保持其在激励上的信用,应该是可以替代传统的网站招聘方式,毕竟企业招聘和帮朋友介绍机会是个双赢的事情。这样的方式可以做到精准的信息匹配,在一定程度上也能很好地保护链路上用户的隐私。

由于行政区划与地理远近并非一致,信息传递不能只依行政区划来安排优先级。比如河南信阳跟湖北武汉一样爱吃热干面,它离武汉比离河南省会郑州更近。如果一个武汉的公司去河南高校招聘,招聘信息传递到河南信阳的同乡群里,得到的反馈可能会比传递到普通的毕业班级群里要多得多。但是这样精准的信息传递,需要把信息和价值通过网络传播、反馈和验证,最终才能得到最佳匹配路径,降低成本,使得企业和个人都受益。

Web3.0 时代,并不是要倒退到互联网的前夜,做事都得靠关系,靠线下的走动;而是要让这种线下的信息和价值,实现数字化、网络化并且可传递。深网信息挖掘的技术变得更重要,可能强化版的图数据库会成为时代的主宰,各种中小型信息数据站点又能够繁荣发展。

Web3.0 对非互联网企业的影响

在没有计算机的年代,货币就是最好的“数字化”工具,人们用货币来衡量社会活动参与个体和企业的经济价值。

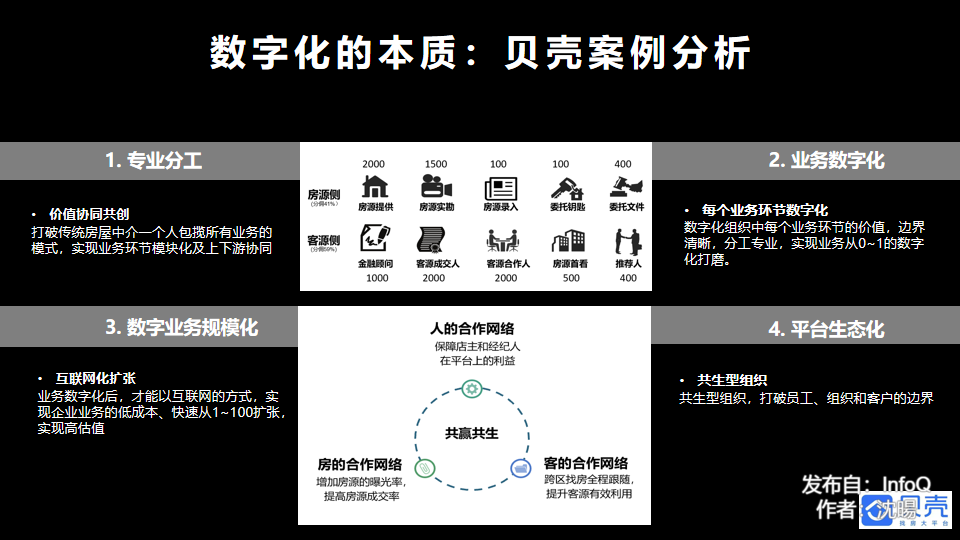

在过去研究的案例中,贝壳是一个把极其传统的行业和低频业务做了成功的数字化改造的公司。贝壳数字化成功的很重要的原因,是定义和计算一个业务内的不同组织和环节的价值,边界清晰,分工专业,实现企业内外协同的市场化和货币化,最终实现了业务规模化扩张和平台生态化。

在数字货币的技术和规则成熟后,数字货币不仅仅可以用于企业对外的业务结算,也适用于企业内部的价值结算,未来每个大型企业都有属于自身的数字货币体系。尽早建立一个企业内部的业务、组织和流程的价值体系,并且不断与外部的供应商和服务体系进行对比,可以增加外界对企业的各类资源价值的认知确定性。

价值和数字化的结合,打破了企业传统部门和公司的边界,清晰的规则,可以帮助企业实现规模的扩张和实现健康的平台生态。企业可以尝试用 Web3.0 的理念,打造行业联盟或者供应链上下游的合作体系,互相开放数据,将跨企业之间的业务数字化,将数字化的普及和对等价值交换的理念做实做深做透,在合作竞争中探索 Web3.0 的最佳实践。契约经济和数字化,不一定非得依靠区块链,用电子合同也可以实现大部分的需求。

企业对数据的管理体系比较成熟。在一些高频和标准的应用场景中,例如客服等体系,可以引入 AI 助理,不断迭代成为企业的虚拟员工。对于低频和复杂的场景,有些企业已经在部门聊天群里引入 AI 机器人,不断学习员工问与答产生的数据,学习企业或者部门的一些特有业务术语和业务逻辑。对于一些商业软件或者互联网平台造成的数据隔阂,也可以使用带有 AI 能力的 RPA 工具将企业的业务流程智能化。

并非每个企业都能拥有互联网企业那样的海量数据,在营销端的数据和流量被互联网平台把持的情况下,普通企业可以聚焦在自己的优势领域,例如生产制造、供应链体系、经销商管理,在供给端做深做透,在每个环节研究数字和价值的深层关系,不用过于焦虑。一味地脱实向虚并不可取,企业不可能靠裸数据来换取价值,数据积累的目的是为了更低成本更高效率的规模交易,交易离不开为实体赋能的产品和服务。社会生产制造消费中有很多智慧和经验,有的已经迭代成为最佳实践和第一性原理,其公式对业务的指导有效性,会超过数据的方法论。如果 Web3.0 真的能实现,在营销端和流量上,非互联网企业将不再处于劣势,那时候比拼的就是供给端的实力了。

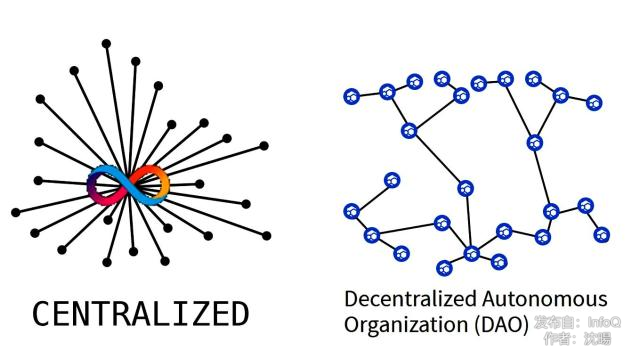

企业与员工之间的关系也可以做 Web3.0 的探索。大多数情况下,企业相对员工都是处于优势的地位,因为企业掌握了更多的信息和数据。分布式自治组织(DAO)的概念最早由美国作家奥里·布莱福曼(Ori Brafman)在一本名为《海星和蜘蛛》的书中提出。他在书中将中心化组织比喻为蜘蛛,将分布式组织比喻为海星。

中心化组织在未来也不会消失,有复杂链路的业务很难通过去中心化的方式去开展工作。组织是人类社会的最有力的武器之一,有了组织,才能建立庞大复杂的工业体系,才能有登月这样的伟大创举。大型企业不太可能完全用分布式自组织的方式进行复杂的生产,但是对于一些新业务,企业可以用阿米巴敏捷小组模式,用 DAO 的理念进行探索。企业可以用对等价值交换的理念,评估创新业务中员工和企业资源在每个环节中的贡献,据此不断孵化出新的业务和组织形态。

在不涉及到企业敏感数据的时候,企业也可以探索在数据治理上企业与员工的关系。企业可能是一个员工消耗时间最多的场所,哪些数据应该归员工所有?员工在回顾过去经历的时候是否有完整的画像?没有工作中的数据,个人的虚拟印象是不完整的。

企业数字化的难点在于:组织的需求是抽象并且变化的,组织需要长期探索和打磨才能形成适合自己的方法论和体系。

Web2.0 时代的共享平台跟 Web3.0 的区别

在 Web2.0 时代,也有很多平台与生态一起共享收益。例如很多电商平台除了自营业务,也有各类中小卖家;每个司机也是共享打车平台独立的“合伙人”,在各个平台之间进退自如;在内容创作平台上,创作者也可以获得平台的奖励。是不是这样的平台其实已经属于 Web3.0 时代了?

这些平台在价值分享上做到了一定的开放,但是大部分平台对分润的模式和算法并不公开透明;另外平台也没有考虑参与者的视角,创作者切换平台有很高的成本。在这点上,开源开放可以使得共享平台真正走向 Web3.0 时代。

一些激进的企业,也许可以通过完全开源的方式,比如开源代码、开放业务模式、开放财务数据、开放非敏感的业务数据,达到透明的信息披露,获得客户、员工和投资方更高的信任。例如开源公司 Gitlab 就把自己的员工手册和管理方式也开放在互联网上,这样全球远程协同的员工可以更好地融合。

个人非常期待能看到有开源社区能以 Web3.0 的方式组织起来,开源社区的运作和数据本身就比较公开透明,如果能把平台、代码贡献者、社区参与者和早期用户的贡献价值体现在项目中,不断地平衡过去、现在和未来参与者的贡献价值,最终将收益返还给所有贡献者。也许 Web3.0 的一个标志性事件,就是通过这样的方式打造成功的项目,并能在传统交易所上市,获得公众的认可。

Web3.0 会是一个技术上的倒退么?

1980 年代,只有巨头们拥有大型计算机,但是个人和普通企业很难消费得起。从大型计算机到 PC 时代,很多人认为是技术上的一个倒退。从各种各样的性能指标上来讲,当年的大型机和小型机都比个人电脑强大很多倍。但是如果时代还停留在大型机时代,那么互联网的兴起就变成不可能的事情。Web1.0 时代也是到了后期,通过分布式的集群,云计算的算力才超过传统的大型机。

40 年后的今天,只有大型互联网平台才有大量的数据,个人和普通企业只是数据的提供者,而无法充分利用数据时代的红利。今天大家都能轻松地购买电脑和手机,但是硬件不等于软件,软件不等于数据,数据不等于信息,信息不等于价值。很多个人和普通企业的数字化水平,还停留在封闭和碎片化的状态。

类似 GDPR 的法规,必然会对互联网平台在技术架构体系上产生各种约束,数据的收集、处理、应用和归档难度也大幅增加。Web3.0 需要的分布式体系,在起步阶段的效率,可能不如集中式的 Web2.0 互联网平台。并且 Web3.0 时代需要的分布式体系,不仅仅是个分布式计算体系,不仅仅是上万个计算节点组成的云,不仅仅是一个大的分布式数据库,而是一个由很多个体和组织联合起来的,分布式、隐私、开源、信任和价值连接的复杂体系。

除了区块链的技术体系外,数字货币、电子合同、隐私计算、联邦身份管理账户体系、深网信息挖掘、个人数字管家、AI 助理、应用平民化、全员的数字思维、联盟和上下游共生思维等,都是建立 Web3.0 体系的重要技术和文化基础。

也许在一段时间内,Web3.0 体现出的技术水平没法超越 Web2.0 时代。不过通过 Web3.0 的建设,个体得以深度数字化,为 Web4.0 的到来提供了全面的数据基础。如果没有数据平等和对等价值交换的基础,到了 Web4.0 和 Web5.0 时代,还是互联网平台垄断一切,其副作用将不可想象。

延展思考

在 Web3.0 时代,怎样不被各种概念忽悠?

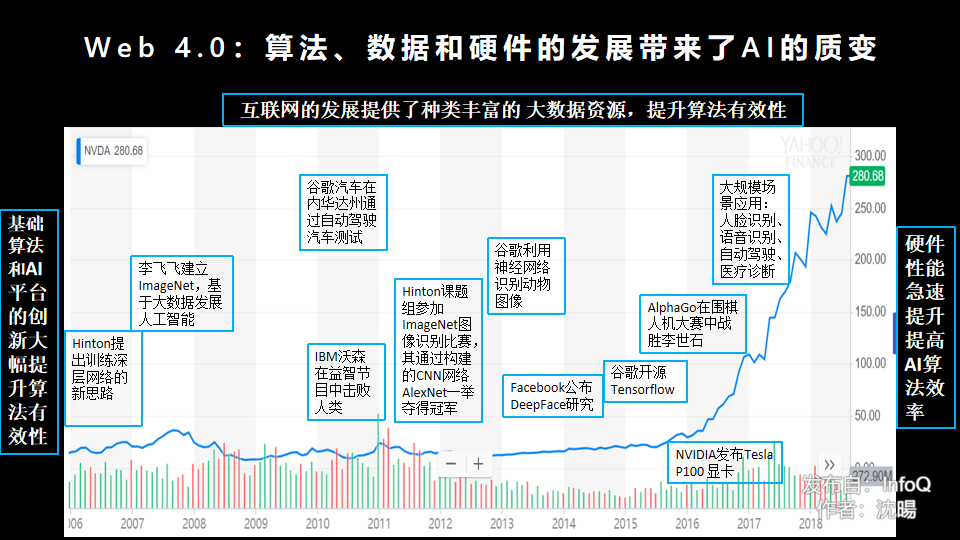

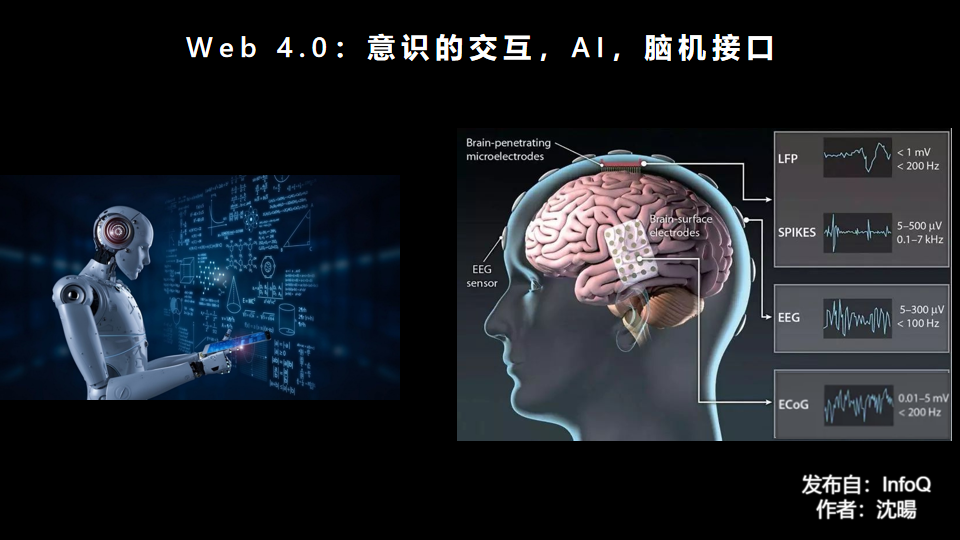

Web4.0:AI+脑机接口,意识的交互

AI 的发展从量变到质变

世界上第一台通用计算机“ENIAC”于 1946 年在美国宾夕法尼亚大学诞生,在计算机诞生后不久,AI 与人脑的较量就开始了。计算机科学和密码学的先驱阿兰·麦席森·图灵于 1950 年写了一篇论文《计算机器与智能》,文中预言了创造出具有智能的机器的可能性,提出了著名的图灵测试:如果一台机器能够与人类展开对话而不能被辨别出其机器身份,那么称这台机器具有智能。图灵测试是人工智能哲学方面第一个严肃的讨论。

在 2006 年之前学习 AI 的同学可能会感受到,无论用什么算法都很难满足通用场景。哪怕是现在看起来挺简单的车牌识别和人脸识别,当时都靠算法工程师调参的手艺,可能在一个特定的场景下可以工作,但是切换到另一个相似的场景就不能满足要求了。

在 2006 年加拿大多伦多大学教授 Hinton 提出深度学习的新思路后,人工智能的发展才开始进入快车道。随着互联网的发展提供了丰富的大数据资源以及 GPU 的硬件性能提升,AI 的发展终于在 2016 年迎来了质变。2016 年 3 月,Google 旗下的 AlphaGo 在韩国首尔以总比分 4 比 1 的成绩战胜了围棋世界冠军、职业九段选手李世石。2017 年 5 月,进化后的 AlphaGo 在“人机大战 2.0”中,以 3:0 战胜世界排名第一的中国选手柯洁。

今天大家觉得 AI 还比较弱智,无论是家里的智能音箱,还是跟电商的 AI 客服对话,大家发现 AI 并不是真的懂自己,无法理解和回答你的很多个性化问题。

这背后的深层原因是现在的大数据积累都是从互联网平台视角出发的,而不是从个人用户视角出发的。

即使互联网平台拥有大量的数据,但其在个人的维度上是碎片化和不完整的。由于数据隐私问题,个人也不可能把自己的完整数据交给互联网平台。但是可以想象一下,如果个人的数字管家,拥有一个人一生的数字化的记录,比如收集记录一个人一生的视频,每个刺激、反馈和动作,每个阅读的内容和笔记,每一段对话和思考,那这样的数据足以训练 AI 读懂一个人。

如果 Web3.0 真的可以实现,可以想象,个人数字化水平会有飞跃的发展。随着技术的发展和进步,“个人数字化”的门槛会大幅降低,越来越多的个人数字画像会被完整记录,虚拟数字人也会越来越懂个人的需求。

大脑和 AI 的运作机理类似

科学家和工程师提升计算机的 AI 水平时,另外一条研究路线也取得了巨大进步,那就是对大脑运作机理的研究。最近读了一篇非常有意思的文章:《大脑中的熵、自由能、对称性和动力学》。

人类的大脑在一定程度上是一个贝叶斯模型,生成内部的模型不断地预测和判断未来,然后将预测与感官输入不断对比,并通过反馈来校验更新内部的模型。从这个角度来看,现在的 AI 训练模式和大脑做的事情非常类似。以德州扑克为例,人类通过观察自己的起手牌、公共牌、对手的出牌行为和对手的过往历史记录,并结合当时对手的表情动作,来做出自己的下注及判断对手的下一步动作。

德州扑克一直是人工智能领域最难攻克的问题之一,因为扑克对局涉及“隐藏信息”。你不知道对手的牌是什么,也不知道对手对你手牌 Range 的判断,要想在牌局中获胜,需要成功运用 bluff 和其他多种策略。这些策略跟国际象棋、围棋等透明的对局不同,相比较而言,德州扑克面临的问题更像是真实人类社会生活工作中的真实场景,这使得德州扑克成为 AI 科学家们最感兴趣的领域之一。

在 2015 年就有德州扑克 Solver 的概念。与围棋领域的 Alpha Go/Alpha Zero 全自动 AI 算法相比,Solver 更像是一个辅助的场外计算器,估算对方手牌的 Range 以及对方猜测你的手牌的 Range。有了这个辅助计算器,人类可以降低计算的复杂度,而把更多的能量放在最终决策上。不过专业的 Solver,因为计算量太大,很难在手机里完成实时的计算。

而类似 Alpha Go 的全自动德州扑克 AI 算法也取得了很大的成绩。Libratus 在双人对决的比赛里获得了非常好的成绩,而 Pluribus 算法在六人游戏中表现出众,使用了深度学习算法的 Deepstack 和 Poker CNN 也取得了不错的成绩。

德州扑克游戏有一定的特殊性,牌局里有很多隐藏信息,参与的玩家也会受到情绪和体力的影响,牌局的走势有相当大的随机干扰。在德州扑克领域靠算法不能保证 100%的胜率,AI 可能不能完全战胜人类中最优秀的选手。但是如果一个 AI 能够记录一个人类选手历史上的所有数据,包括各类身体表情的数据,通过大量的训练,AI 最终应该也能模拟出这个人类选手的出牌风格。在这种情况下训练出的 AI 虽然不一定每次都能跟模仿对象出一样的牌,但是从多轮牌局的统计维度上来看,应该能保持非常好的一致性。

另外人类大脑处理信息大概是在 100ms 以内完成的,如果 AI 也能在便携的计算设备里以相同或者更少的时间做出反馈,那么可以认为 AI 能够很好地模拟大脑的工作机制。人类的大脑毕竟不是个无限的信息容器,AI 模拟人类在打德州扑克时的风格,应该很快能实现。

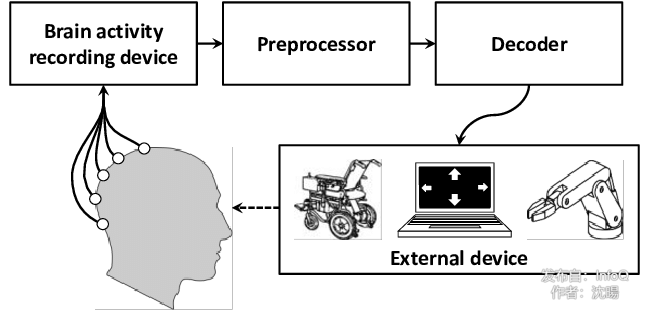

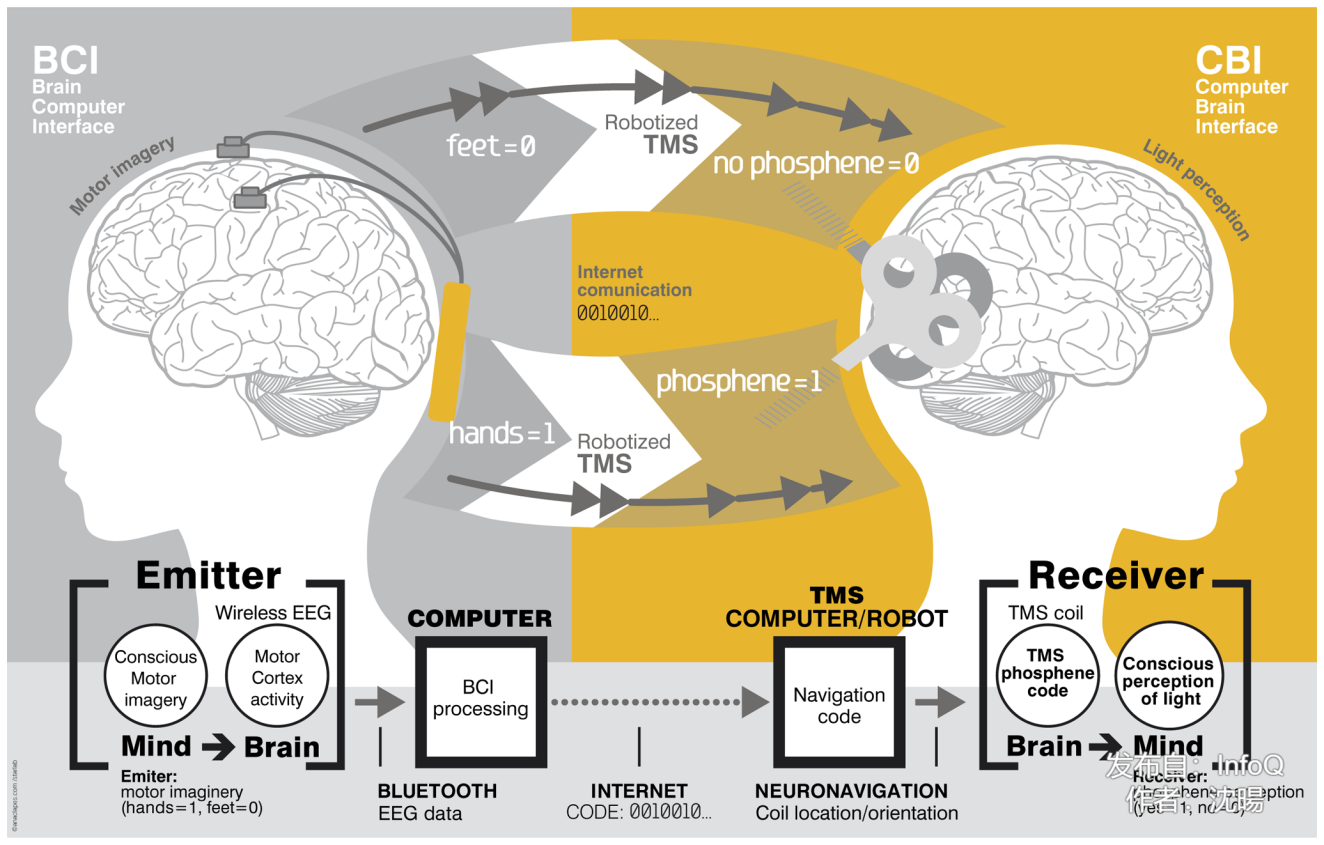

AI 通过脑机接口读取人类意识

对大脑的研究除了通过输入和反馈,也需要对大脑的实体进行深度研究。其中脑机接口就是一项非常实用的技术。目前,大部分的脑机接口就只是对大脑进行读取信息的操作。

早在 1857 年,英国青年生理科学工作者卡通(R.Caton)就在猴脑上记录到了脑电活动,并发表了论文《脑灰质电现象的研究》。1924 年,德国的精神病学家贝格尔(H.Berger)真正地记录到了人脑的脑电波,人的脑电图从此诞生了。

20 年前我做脑机接口研究的时候,脑电采集设备还不是很灵敏,为了提高灵敏度,实验人员甚至可能要剃光头并涂上导电胶体。常见的实验场景是,实验人员戴上脑电采集的电极帽,通过脑电信号和算法,控制屏幕上的鼠标达到指定的区域。在当年大多数公开的记录中,准确率只能达到 75%,在这种情况下,要完成一个字符的输入可能要花上 1 分钟。

最近 10 年,脑机接口领域的发展突飞猛进。

2021 年 4 月,脑机接口公司 Neuralink 发布了《Monkey MindPong》的 Demo 视频。一只猴子正在靠“意念”轻松地玩电脑游戏。在这个系统里,先是通过正常连接的摇杆来校准系统,然后用脑电的信号输出和算法来精准模拟有线摇杆的信号;系统校准后,即使是断开摇杆的连线,猴子也可以靠着脑电的信号输出来完成游戏。下面的 Demo 显示摇杆跟显示屏之间的连线已经断开了。不过 Neuralink 的脑机接口是一种侵入式的系统,需要通过手术将芯片植入到猴子的大脑中,然后通过 USB-C 接口读取大脑信号。

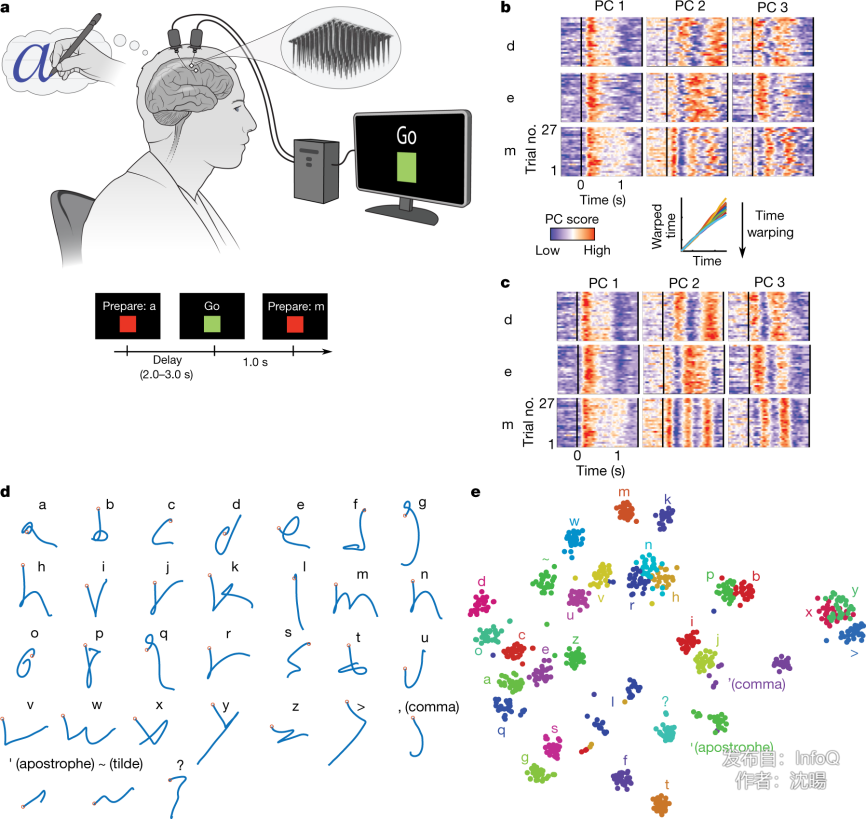

2021 年 5 月,斯坦福大学、霍华德・休斯医学研究所(HHMI)和布朗大学等团队用脑机接口技术实现了瘫痪患者将脑中的“笔迹”转化成屏幕字句,并在 Nature 杂志发表论文《High-performance brain-to-text communication via handwriting》。他们将 AI 软件与脑机接口设备结合,利用大脑运动皮层的神经活动解码“手写”笔迹,并使用循环神经网络(RNN)解码方法,将笔迹实时翻译成文本,快速将患者对手写的想法转换为电脑屏幕上的文本。实验人员每分钟可以输入 90 个字符,接近正常人在智能手机上的打字速度,这个性能已经非常接近实用场景了,实现了 AI 读懂人类大脑中的表达。

大脑中不断闪现想法,不一定每个想法都有语言的表达和身体的动作反馈,例如选手在德州牌局正式下注前的挣扎和思考,这些在隐藏层的意识活动对 AI 的训练也非常有价值。毕竟人类受到社会和环境的约束,很多想法是无法实现的,尤其是一些重大事件的决策,不是每件事都能下决心和落地的,人的一生做不了太多次重大决策。如果只是把最终表达出的语言和实际落地的行动作为 AI 训练的来源,样本量就会过少,就会遗漏掉那些人性最重要的部分,使得 AI 无法模拟人类在关键时刻的决策。

AI 实现对大脑的模拟的 3 个方向

1.AI 对抽象但是简单的概念进行识别,例如对图像、声音等的识别来模拟大脑的功能。

2.通过预测—反馈的不断测试和复杂的博弈场景,利用全面的个人数据,用 AI 来拟合人类对各种输入的反馈。

3.通过对脑机接口的研究,一方面深度挖掘大脑隐藏的工作机制和那些没能表达出来的想法,塑造更完整的 AI;另一方面提供一个很好的人机交互方式,人类可以通过简单的方式表达自己的意识。

未来,也许人们会随身戴上便携式的脑电设备,用以训练属于自己的 AI 助理。无论是游戏还是汽车驾驶,都是非常适合迭代优化个人 AI 助理的场景。当 AI 助理足够了解你的时候,人们就可以复制多份 AI 助理,用来处理不同的工作,大家就应该可以把更多的时间放在家庭和休闲上了,这时候的 AI 助理应该称得上合格吧。

在 Web4.0 时代,可以实现意识的复制,意识在虚拟空间的交互,还有计算机对大脑意识的读取。

延展思考

在 Web4.0 时代,怎样保护自己的意识被合法使用?

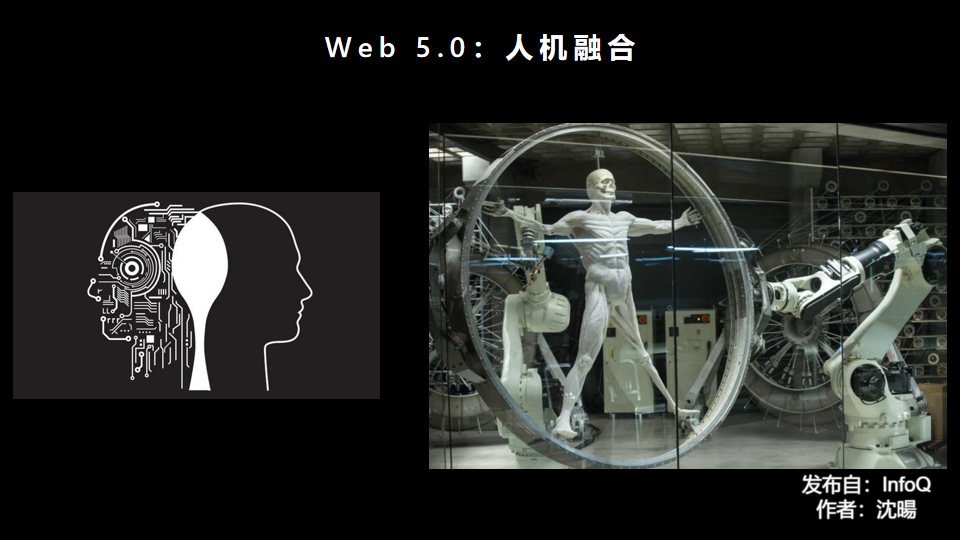

Web5.0:人机融合的时代

也许大家觉得 Web5.0 的提法有些过于超前,不过很多 Web5.0 时代的技术,现在都已经在萌芽了。人机融合的定义,借用图灵测试的标准,就是无论是在网络的交流中,还是实际的交往中,已经分辨不出是机器还是人了。

首先,我们从仿人机器人开始说起。

在人形机器人领域受关注度最高的玩家要属波士顿动力公司。2009 年,波士顿动力的双足机器人 Petman 原型机亮相,此时它需要拖着电缆在履带上晃晃悠悠地行走。2013 年,初具人类外形的 Atlas 原型机亮相,这时的 Atlas 已经能够在碎石堆上行走,还会“金鸡独立”,以及承受大摆球的撞击。这段视频发布两个月后,波士顿动力被谷歌母公司 Alphabet 收购。2017 年,波士顿动力被日本软银集团收入囊中。易主并未影响到 Atlas 的快速成长,它的动作更加流畅,并且能够上台阶、后空翻等。随后几年里,Atlas 学会了跑步、体操、翻滚、倒立、跳舞等技能。2021 年 6 月,现代汽车集团与软银集团宣布,前者完成了对波士顿动力公司 80%股权的收购。

另外一家是特斯拉。继 2021 年 8 月宣布特斯拉人形机器人(Tesla Bot)计划后,今年 6 月,马斯克在推特上表示,将在今年 9 月 30 日的特斯拉 AI Day 推出 Tesla Bot 原型机。特斯拉人形机器人被命名为 Optimus(擎天柱),高 1.72 米,重 56.6 千克,与人类相仿,身体由特殊材料制成,内置特斯拉 FSD(完全自动驾驶)芯片,并共用 AI 系统。根据特斯拉的计划,Optimus 最早将于 2023 年开始生产。在马斯克看来,从传感器和执行器的角度来看,制造一个人形机器人是有可能的,目前所缺少的要素有两点——足够的智能和扩大的生产规模。

Web4.0 的发展和积累刚好可以给机器人带来足够的智慧。如果 AI 机器人对外界的每一个刺激都能做出跟人类一样的动作和反应,那么在模拟人的方面就算是成功的。

但是机器人的结构与人类肯定会有天壤之别,以机械或者其他材料打造的机器人是无法模拟人类的血肉之躯的,也无法提供人类交流时需要获得的真实感受。也许听觉是第一个被 AI 机器人模拟成功的,然后视觉可以模拟一部分,但是像触觉、嗅觉、味觉等就很难模拟。正是因为这些难点的存在,所以 AI 机器人不能在打德州扑克时有爽朗的大笑,和 Bluff 后紧张的微表情。这些信息和感受对身边的人类来说同样重要。

Web4.0 阶段的脑机接口只是实现从大脑读取意识,但是在 Web5.0 阶段,脑机接口还需要实现给大脑写意识的功能,这样才能真正实现意识的互联互通。人类的大脑本身就是一个非常好的计算和仿真系统,是一个效率极高的元宇宙体系,私密而又有无穷的可能。在梦境里,人类可以把以前真实见过的、听说过的、想象过的各类场景和人物重新组合,模拟出全新的场景。这些组合也许符合现实的规律,也许可以超越现实的约束。只需要少量的输入刺激和引导信号,就可以让人类的大脑模拟出丰富的场景,类似“盗梦空间”的情景可能就不再是科幻了。

像触觉、嗅觉、味觉这些机器人很难模拟出来的反馈,也可以通过脑机接口输入的方式在人类大脑中产生类似的刺激。如果人类无法分辨这个刺激的来源是人类还是互联的机器 AI,那么人机融合的“图灵测试”应该就可以被认为通过了吧。

延展思考

在 Web5.0 时代,肉身会被替代么?

后 Web5.0 时代

也许,“冷血”的区块链体系在人机融合的时代里可以大放异彩,能源和算力成了时代的硬通货。人类能进入 Web3.0,打破互联网巨头的垄断么?人类在 Web5.0 时代,能与机器共存么?技术进步得越来越快,但是,人类的意识何去何从?人类的肉身何去何从?